RAG(Retrieval-Augmented Generation)融合了兩大核心組件:

-(i)檢索模塊,負(fù)責(zé)從外部知識庫中檢索相關(guān)文檔或信息,利用密集向量表示從大型數(shù)據(jù)集,如維基百科或私有數(shù)據(jù)庫中識別相關(guān)文檔。

-(ii)生成模塊,負(fù)責(zé)處理這些信息,產(chǎn)出類似人類語言的文本,檢索到的文檔隨后被送至生成模塊,該模塊通常基于 transformer 架構(gòu)構(gòu)建。

RAG有助于減少生成內(nèi)容的“幻覺”現(xiàn)象,確保文本更具事實性和上下文適宜性。RAG已廣泛應(yīng)用于多個領(lǐng)域,包括:

在RAG出現(xiàn)之前,自然語言處理(NLP)主要依賴于檢索或生成方法。

這兩種方法的互補(bǔ)性,使得大家開始嘗試檢索和生成的混合系統(tǒng)。最早的混合系統(tǒng)可以追溯到DrQA,使用檢索技術(shù)來獲取問答任務(wù)的相關(guān)文檔。

RAG模型包括兩個核心組件:

RAG的強(qiáng)項在于其能夠動態(tài)利用外部知識,在性能上超越了依賴靜態(tài)數(shù)據(jù)集的生成模型如GPT-3。

BM25是一種使用較廣的信息檢索算法,利用詞頻-逆文檔頻率(TF-IDF)來根據(jù)相關(guān)性對文檔進(jìn)行排序。盡管是一種經(jīng)典方法,依然是許多現(xiàn)代檢索系統(tǒng),包括RAG模型中使用的系統(tǒng)的一個標(biāo)準(zhǔn)算法。

BM25根據(jù)查詢詞在文檔中的出現(xiàn)頻率來計算文檔的相關(guān)性得分,同時考慮文檔長度和詞在整個語料庫中的頻率。盡管BM25在關(guān)鍵詞匹配方面表現(xiàn)出色,但它在理解語義含義上存在局限。例如,BM25無法捕捉詞與詞之間的關(guān)系,并且在處理需要上下文理解的復(fù)雜自然語言查詢時表現(xiàn)不佳。

但是,BM25因簡單高效而被廣泛采用。適用于基于關(guān)鍵詞的簡單查詢?nèi)蝿?wù),盡管像DPR這樣的現(xiàn)代檢索模型在處理語義復(fù)雜的任務(wù)時往往性能更好。

密集段落檢索(Dense Passage Retrieval,DPR)是一種新的信息檢索方法。使用一個高維向量空間,查詢和文檔都被編碼成高維向量。

采用雙編碼器架構(gòu),分別對查詢和文檔進(jìn)行編碼,從而實現(xiàn)高效的最近鄰搜索。

與BM25不同,DPR在捕捉查詢和文檔之間的語義相似性方面表現(xiàn)出色,使其在開放域問答任務(wù)中極為有效。

DPR的優(yōu)勢在于其能夠根據(jù)語義含義而非關(guān)鍵詞匹配來檢索相關(guān)信息。通過在大量問答對語料庫上訓(xùn)練檢索器,DPR能夠找到與查詢上下文相關(guān)的文檔,哪怕查詢和文檔沒有使用完全相同的詞匯。最新的研究通過將DPR與預(yù)訓(xùn)練語言模型結(jié)合,進(jìn)一步優(yōu)化了DPR。

REALM將檢索過程融入語言模型的預(yù)訓(xùn)練,確保檢索器與生成器協(xié)同優(yōu)化,以適應(yīng)后續(xù)任務(wù)。

REALM的創(chuàng)新之處在于:能夠?qū)W習(xí)檢索出能夠提升模型在特定任務(wù)上表現(xiàn)的文檔,比如問答或文檔摘要。

訓(xùn)練過程中,REALM對檢索器和生成器進(jìn)行同步更新,優(yōu)化檢索流程以更好地服務(wù)于文本生成任務(wù)。

REALM的檢索器被訓(xùn)練為能夠識別出既與查詢相關(guān)又有助于生成準(zhǔn)確、連貫回答的文檔。因此,REALM顯著提升了生成回答的質(zhì)量,尤其是在需要依賴外部知識的那些任務(wù)上。

最新研究顯示,在某些知識密集型任務(wù)中,REALM超越了BM25和DPR,特別是在檢索與生成緊密結(jié)合的情況下。

RAG的精髓在于檢索段落的質(zhì)量,但許多現(xiàn)有方法依賴于基于相似性的檢索(Mallen等,2022)。

Self-RAG和REPLUG通過利用大型語言模型(LLM)增強(qiáng)檢索能力,實現(xiàn)了更靈活的檢索。

初次檢索后,交叉編碼器模型通過聯(lián)合編碼查詢和檢索文檔來重新排序結(jié)果,計算相關(guān)性得分。這些模型雖然提供了更豐富的上下文感知檢索,但計算成本較高。

RAG系統(tǒng)利用LLM中的自注意力機(jī)制來管理輸入和檢索文本各部分的上下文和相關(guān)性。在將檢索信息整合到生成模型時,采用交叉注意力機(jī)制,以確保在生成過程中突出最相關(guān)的信息片段。

在 RAG 中,生成器是將檢索到的信息與輸入查詢?nèi)诤希勺罱K輸出的關(guān)鍵環(huán)節(jié)。

一旦檢索組件從外部資源中提取出相關(guān)知識,生成器便會將這些信息編織成連貫、符合上下文的回應(yīng)。大型語言模型(LLM)構(gòu)成了生成器的核心,確保生成的文本流暢、準(zhǔn)確,并與原始查詢保持一致。

T5((Text-to-Text Transfer Transformer)是RAG系統(tǒng)中用于生成任務(wù)的常用模型之一。

T5的靈活性體現(xiàn)在其將所有NLP任務(wù)視為文本到文本的任務(wù)。這種統(tǒng)一的框架使得T5能夠針對廣泛的任務(wù)進(jìn)行微調(diào),包括問答、摘要和對話生成。

通過整合檢索與生成,基于T5的RAG模型在多個基準(zhǔn)測試中超越了傳統(tǒng)生成模型,如GPT-3和BART,特別是在Natural Questions數(shù)據(jù)集和TriviaQA數(shù)據(jù)集上。

此外,T5在處理復(fù)雜多任務(wù)學(xué)習(xí)方面的能力,使其成為需要應(yīng)對多樣化知識密集型任務(wù)的RAG系統(tǒng)的首選。

BART(Bidirectional and Auto-Regressive Transformer)特別適合處理從嘈雜輸入中生成文本的任務(wù),例如摘要和開放域問答。

作為一種去噪自編碼器,BART能夠重建損壞的文本序列,使其在需要從不完整或嘈雜數(shù)據(jù)中生成連貫、事實性輸出的任務(wù)中表現(xiàn)出色。

當(dāng)與RAG系統(tǒng)中的檢索器結(jié)合時,BART已被證明能夠通過外部知識提高生成文本的事實準(zhǔn)確性。

基于文本的RAG模型是目前最為成熟且廣泛研究的類型。

依托文本數(shù)據(jù),執(zhí)行檢索與生成任務(wù),推動了問答、摘要和對話智能體等應(yīng)用的發(fā)展。

BERT和T5等Transformer架構(gòu)構(gòu)成了文本RAG模型的基石,運(yùn)用自注意力機(jī)制來捕捉文本內(nèi)的上下文聯(lián)系,從而提升檢索的精確度和生成的流暢度。

基于音頻的RAG模型將檢索增強(qiáng)型生成的理念拓展至音頻領(lǐng)域,為語音識別、音頻摘要和語音界面中的對話智能體等應(yīng)用開辟了新天地。音頻數(shù)據(jù)常通過Wav2Vec 2.0等預(yù)訓(xùn)練模型衍生的嵌入表示來呈現(xiàn)。這些嵌入作為檢索和生成組件的輸入,使得模型能夠有效地處理音頻數(shù)據(jù)。

基于視頻的RAG模型融合視覺與文本信息,增強(qiáng)了視頻理解、字幕生成和檢索等任務(wù)的表現(xiàn)。視頻數(shù)據(jù)通過 I3D TimeSformer 等模型的嵌入表示來呈現(xiàn)。這些嵌入捕捉了時間與空間特征,對于有效的檢索和生成至關(guān)重要。

多模態(tài)RAG模型融合了文本、音頻、視頻和圖像等多種模態(tài)的數(shù)據(jù),為檢索和生成任務(wù)提供了一種更全面的方法。

例如Flamingo這樣的模型將不同模態(tài)整合進(jìn)一個統(tǒng)一的框架內(nèi),實現(xiàn)了文本、圖像和視頻的同時處理。跨模態(tài)檢索技術(shù)涉及在不同模態(tài)間檢索相關(guān)信息。

“檢索即生成(Retrieval as generation)”通過結(jié)合文本到圖像和圖像到文本的檢索,將檢索增強(qiáng)型生成(RAG)框架擴(kuò)展到了多模態(tài)應(yīng)用。利用大規(guī)模的配對圖像和文本描述數(shù)據(jù)集,在用戶查詢與存儲的文本描述相匹配時,能夠快速生成圖像(“檢索即生成”)。

基于智能體的RAG

一種新的智能體檢索增強(qiáng)型生成(RAG)框架采用了分層的多智能體結(jié)構(gòu),子智能體使用小型預(yù)訓(xùn)練語言模型(SLMs)針對特定的時間序列任務(wù)進(jìn)行微調(diào)。主智能體將任務(wù)分配給這些子智能體,從共享知識庫中檢索相關(guān)提示。這種模塊化多智能體方法實現(xiàn)了較高的性能,展現(xiàn)了在時間序列分析中相較于特定任務(wù)方法的靈活性和效率。

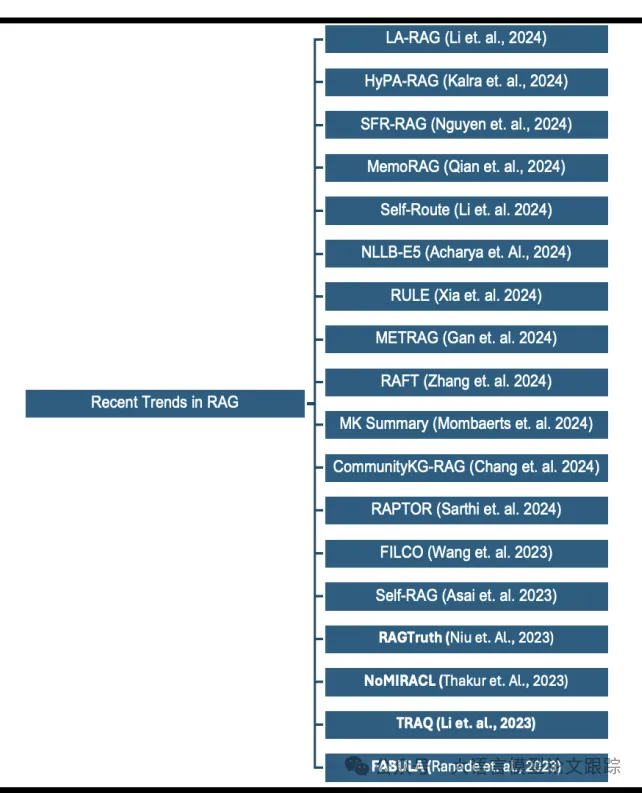

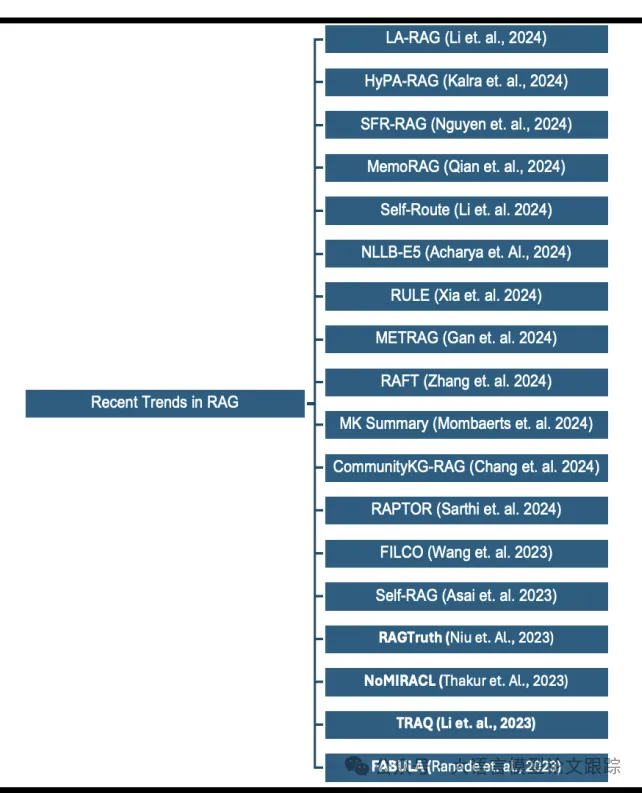

RULE

RULE是一個多模態(tài)RAG框架,旨在提升醫(yī)學(xué)視覺-語言模型(Med-LVLM)的事實準(zhǔn)確性,通過引入校準(zhǔn)選擇策略控制事實風(fēng)險,并開發(fā)偏好優(yōu)化策略平衡模型內(nèi)在知識與檢索上下文,證明了其在提升Med-LVLM系統(tǒng)事實準(zhǔn)確性方面的有效性。

METRAG

METRAG,一個多層次、思維增強(qiáng)(thoughts enhanced)的檢索增強(qiáng)型生成框架,結(jié)合文檔相似性和實用性來提升性能。包括一個任務(wù)自適應(yīng)摘要器,以產(chǎn)生蒸餾后內(nèi)容摘要。利用這些階段的多次思考,LLM生成知識增強(qiáng)內(nèi)容,在知識密集型任務(wù)上與傳統(tǒng)方法相比展現(xiàn)出更優(yōu)越的性能。

RAFT(Retrieval Augmented Fine-Tuning)

干擾文檔是檢索增強(qiáng)型微調(diào)(RAFT)(Zhang等,2024)的關(guān)鍵特征之一,用不相關(guān)、干擾性文檔訓(xùn)練模型如何辨別,而直接引用相關(guān)來源。結(jié)合思維鏈推理,增強(qiáng)了模型的推理能力。RAFT在特定領(lǐng)域的RAG任務(wù)中表現(xiàn)出一致的性能提升,包括PubMed、HotpotQA和Gorilla數(shù)據(jù)集,作為LLMs的后訓(xùn)練增強(qiáng)。

FILCOFILCO旨在提升生成模型在開放域問答和事實驗證等任務(wù)中提供的上下文質(zhì)量,解決對檢索段落過度或不足依賴的問題,可能導(dǎo)致生成輸出中的幻覺問題。該方法通過詞匯和信息論方法識別有用的上下文,并通過訓(xùn)練上下文過濾模型在測試期間提煉檢索上下文,提高了上下文質(zhì)量。

Self-RAG

反思標(biāo)記是自反思檢索增強(qiáng)型生成(Self-RAG)(Asai等,2023)的關(guān)鍵屬性,通過結(jié)合檢索與自反思來提高大型語言模型(LLMs)的事實準(zhǔn)確性。與傳統(tǒng)方法不同,Self-RAG自適應(yīng)地檢索相關(guān)段落,并使用反思標(biāo)記評估和提煉其響應(yīng),允許模型根據(jù)特定任務(wù)需求調(diào)整行為,并在開放域問答、推理、事實驗證和長篇生成任務(wù)中表現(xiàn)出優(yōu)越性能。RAG的智能性和有效性在很大程度上取決于檢索質(zhì)量,對知識庫的更多元數(shù)據(jù)理解將增強(qiáng)RAG系統(tǒng)的有效性。

MK Summary

一種以數(shù)據(jù)為中心的檢索增強(qiáng)型生成(RAG)工作流程,超越了傳統(tǒng)的檢索-閱讀模式,采用了準(zhǔn)備-重寫-檢索-閱讀框架,通過整合上下文相關(guān)、時間關(guān)鍵或特定領(lǐng)域的信息來增強(qiáng)LLMs。其創(chuàng)新點包括生成元數(shù)據(jù)、合成問題和答案(QA),并引入文檔集群的元知識摘要(MK摘要)。

CommunityKG-RAG

CommunityKG-RAG是一個零樣本框架,將知識圖譜(KGs)中的社區(qū)結(jié)構(gòu)整合到檢索增強(qiáng)型生成(RAG)系統(tǒng)中。通過利用KGs中的多跳連接,提高了事實檢查的準(zhǔn)確性和上下文相關(guān)性,超越了不需要額外領(lǐng)域特定訓(xùn)練的傳統(tǒng)方法。

RAPTOR

RAPTOR引入了一種層次化方法來增強(qiáng)檢索增強(qiáng)型語言模型,解決了傳統(tǒng)方法只檢索短的、連續(xù)文本塊的限制。RAPTOR通過遞歸嵌入、聚類和總結(jié)文本,形成摘要樹以在不同抽象級別檢索信息。實驗表明RAPTOR在需要復(fù)雜推理的問答任務(wù)中表現(xiàn)出優(yōu)越性能。當(dāng)與GPT-4配對時,RAPTOR在QuALITY基準(zhǔn)測試中的準(zhǔn)確性提高了20%。

近期推出的支持長期上下文的大型語言模型(LLMs),如Gemini-1.5和GPT-4,顯著提升了RAG性能。

Self-Route

Self-Route 通過模型自省動態(tài)分配查詢至RAG或LC,從而優(yōu)化計算成本與性能。為RAG和LC在處理長期上下文任務(wù)時的最佳應(yīng)用提供了深刻見解。

SFR-RAG

SFR-RAG是一個小巧而高效的RAG模型,旨在增強(qiáng)LLMs對外部上下文信息的整合,同時減少幻覺現(xiàn)象。

LA-RAG

LA-RAG是一種新型RAG范式,旨在提升LLMs中的自動語音識別(ASR)能力。亮點在于其能夠利用細(xì)粒度的標(biāo)記級語音數(shù)據(jù)存儲和語音到語音的檢索機(jī)制,通過LLM的上下文學(xué)習(xí)提高ASR的精確度。

HyPA-RAG

LLMs在AI法律和政策背景下因知識過時和幻覺而面臨挑戰(zhàn)。HyPA-RAG是一個混合參數(shù)自適應(yīng)檢索增強(qiáng)型生成系統(tǒng),通過自適應(yīng)參數(shù)調(diào)整和混合檢索策略提高了精確度。在NYC Local Law 144的測試中,HyPA-RAG展現(xiàn)了更高的正確性和上下文精度,有效應(yīng)對了法律文本的復(fù)雜性。

MemoRAG

MemoRAG引入了一種新型RAG范式,克服傳統(tǒng)RAG系統(tǒng)在處理模糊或非結(jié)構(gòu)化知識時的局限。MemoRAG的雙系統(tǒng)架構(gòu)利用輕量級長距離LLM生成草稿答案并指導(dǎo)檢索工具,而更強(qiáng)大的LLM則負(fù)責(zé)完善最終輸出。這一框架針對更好的線索提取和記憶容量進(jìn)行了優(yōu)化,在復(fù)雜和簡單的任務(wù)中都顯著超越了傳統(tǒng)RAG模型。

NLLB-E5

NLLB-E5推出了一個可擴(kuò)展的多語言檢索模型,解決支持多語言,尤其是像印度語這樣的低資源語言所面臨的挑戰(zhàn)。借助NLLB編碼器和E5多語言檢索器的蒸餾方法,NLLB-E5能夠?qū)崿F(xiàn)跨語言的零樣本檢索,無需多語言訓(xùn)練數(shù)據(jù)。在Hindi-BEIR等基準(zhǔn)測試上的評估顯示了其強(qiáng)大的性能,突顯了任務(wù)特定的挑戰(zhàn),并推動了全球包容性的多語言信息獲取。

在RAG模型中整合文本、圖像、音頻和視頻數(shù)據(jù),需著眼于提升多模態(tài)融合技術(shù),實現(xiàn)不同數(shù)據(jù)類型間的無縫交互,包括:

隨著RAG模型在更廣泛的大規(guī)模應(yīng)用中部署,其擴(kuò)展性變得至關(guān)重要。研究應(yīng)聚焦于開發(fā)高效擴(kuò)展檢索和生成過程的方法,同時不犧牲性能。分布式計算和高效索引技術(shù)對于處理龐大數(shù)據(jù)集至關(guān)重要。提升RAG模型的效率需要優(yōu)化檢索和生成組件,以減少計算資源和延遲。

未來的RAG模型應(yīng)專注于根據(jù)個體用戶的偏好和情境個性化檢索過程。這包括開發(fā)基于用戶歷史、行為和偏好調(diào)整檢索策略的技術(shù)。通過深入理解查詢和文檔庫的上下文和情感,增強(qiáng)RAG模型的上下文適應(yīng)性,對于提升生成響應(yīng)的相關(guān)性至關(guān)重要。研究應(yīng)探索基于互動上下文的動態(tài)調(diào)整檢索和生成過程的方法,包括將用戶反饋和上下文線索整合到RAG流程中。

解決偏見是未來研究的關(guān)鍵領(lǐng)域,尤其是針對RAG模型的偏見。隨著RAG系統(tǒng)在多樣化應(yīng)用中的部署,確保公平性并減少檢索和生成內(nèi)容中的偏見至關(guān)重要。未來的RAG研究應(yīng)聚焦于保護(hù)隱私的技術(shù),以在檢索和生成過程中保護(hù)敏感信息。包括開發(fā)安全數(shù)據(jù)處理方法和隱私意識的檢索策略。模型的可解釋性也是持續(xù)改進(jìn)RAG研究的一個關(guān)鍵領(lǐng)域。

拓展RAG技術(shù)以支持多語言,尤其是資源匱乏的語言,是一個充滿希望的發(fā)展方向。

致力于提升跨語言檢索與生成能力,確保在不同語言中都能提供準(zhǔn)確且相關(guān)的結(jié)果。提升RAG模型對低資源語言的有效支持,需要開發(fā)在有限訓(xùn)練數(shù)據(jù)下進(jìn)行內(nèi)容檢索與生成的方法。研究應(yīng)聚焦于轉(zhuǎn)移學(xué)習(xí)與數(shù)據(jù)增強(qiáng)技術(shù),以提高在邊緣語言中的表現(xiàn)。

未來RAG研究應(yīng)探索能夠適應(yīng)變化查詢模式和內(nèi)容需求的動態(tài)檢索機(jī)制。包括構(gòu)建能夠根據(jù)新信息和用戶需求演進(jìn)而動態(tài)調(diào)整檢索策略的模型。

研究混合檢索方法,結(jié)合密集檢索與稀疏檢索等不同策略,有望提升RAG系統(tǒng)的效果。研究應(yīng)著眼于如何整合多樣化的檢索方式,以適應(yīng)各種任務(wù)并達(dá)到最佳性能。

將RAG模型與腦機(jī)接口(BCIs)相結(jié)合,可能在人機(jī)交互和輔助技術(shù)領(lǐng)域開辟新的應(yīng)用。研究應(yīng)探討RAG系統(tǒng)如何利用BCI數(shù)據(jù)來提升用戶體驗和生成具有上下文感知的響應(yīng)。RAG與增強(qiáng)現(xiàn)實(AR)和虛擬現(xiàn)實(VR)技術(shù)的結(jié)合,為創(chuàng)造沉浸式互動體驗提供了機(jī)遇。未來的研究應(yīng)調(diào)查RAG模型如何被用于增強(qiáng)AR和VR應(yīng)用,通過提供上下文相關(guān)的信息和交互,提升用戶體驗。

文章轉(zhuǎn)自微信公眾號@算法進(jìn)階