鍵.png)

GraphRAG:基于PolarDB+通義千問api+LangChain的知識(shí)圖譜定制實(shí)踐

我們輸入文字,點(diǎn)擊“執(zhí)行測(cè)試”,等待片刻,便可試聽語音合成的效果:

hifi_spk1(3),阿里云開發(fā)者,13秒

第二種方式是使用編程,通過簡單的幾行代碼,就可以實(shí)現(xiàn)自己的語音合成功能,并集成嵌入到具體的應(yīng)用中去。這種方式適合選定喜歡的發(fā)音人后、進(jìn)行深度的應(yīng)用開發(fā)。

魔搭社區(qū)提供了免費(fèi)的CPU算力(不限額)和GPU算力(NVIDIA-V100-16G 限額100小時(shí)),供開發(fā)者進(jìn)行使用,下面我們使用Notebook開發(fā)環(huán)境來簡單演示如何實(shí)現(xiàn)使用代碼進(jìn)行語音合成。

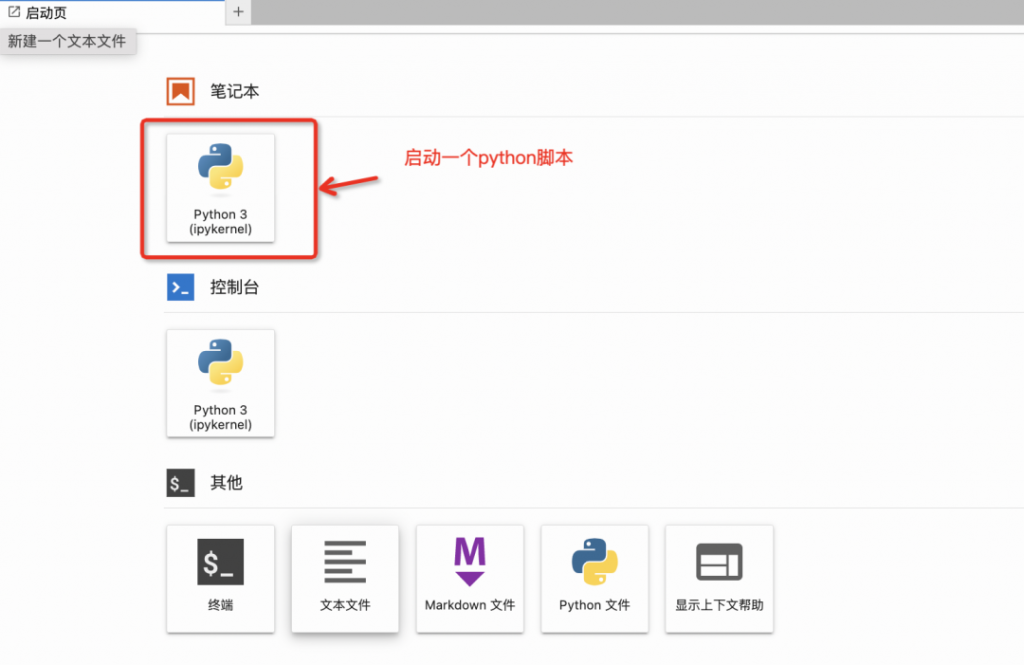

讓我們選擇CPU服務(wù),稍等幾分鐘服務(wù)啟動(dòng),我們點(diǎn)擊“查看NoteBook”,進(jìn)入開發(fā)環(huán)境,選擇啟動(dòng)一個(gè)python腳本。

這些語音AI模型都配備了代碼示例,我們可以在模型詳情頁的代碼示例中找到:

將該代碼進(jìn)行復(fù)制并粘貼至notebook的python腳本當(dāng)中,我們可以將代碼中‘待合成文本’字符串替換成想要的合成本文,并執(zhí)行程序,便可以下載生成的音頻文件進(jìn)行試聽。

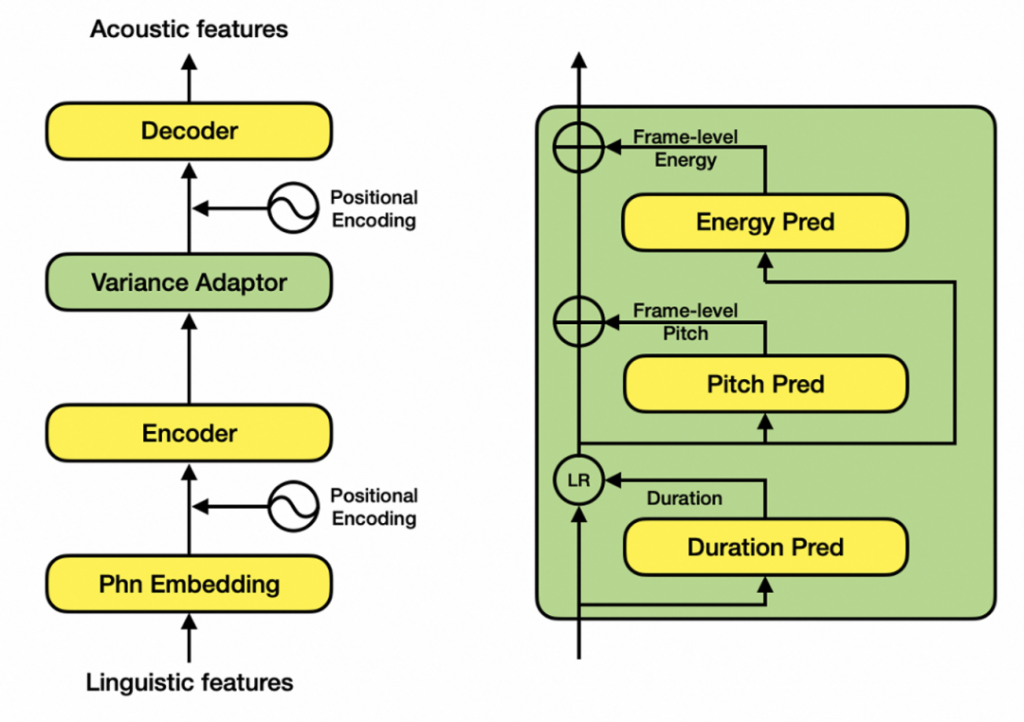

這項(xiàng)語音合成技術(shù)背后是達(dá)摩院的顯式韻律聲學(xué)模型SAMBERT以及Hifi-GAN聲碼器的結(jié)合。

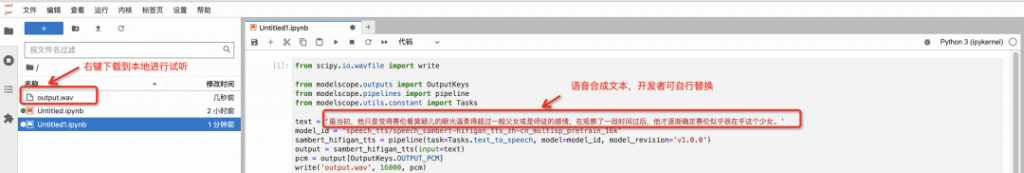

在語音合成領(lǐng)域,目前以FastSpeech2類似的Non-Parallel模型為主流,它針對(duì)基頻(pitch)、能量(energy)和時(shí)長(duration)三種韻律表征分別建模。但是,該類模型普遍存在一些效果和性能上的問題:獨(dú)立建模時(shí)長、基頻、能量,忽視了其內(nèi)在聯(lián)系;完全非自回歸的網(wǎng)絡(luò)結(jié)構(gòu),無法滿足工業(yè)級(jí)實(shí)時(shí)合成需求;幀級(jí)別基頻和能量預(yù)測(cè)不穩(wěn)定…

因此達(dá)摩院設(shè)計(jì)了SAMBERT,一種基于Non-Parallel結(jié)構(gòu)的改良版TTS模型,它具有以下優(yōu)點(diǎn):

在魔搭社區(qū)上,達(dá)摩院語音實(shí)驗(yàn)室開放了核心的語音識(shí)別模型“Paraformer語音識(shí)別-中文-通用-16k-離線”,這是即將大規(guī)模商業(yè)部署的下一代模型,其訓(xùn)練數(shù)據(jù)規(guī)模達(dá)到5萬小時(shí)以上,通過對(duì)非自回歸語音識(shí)別模型技術(shù)的改進(jìn),不僅達(dá)到當(dāng)前類Transformer自回歸模型的語音識(shí)別準(zhǔn)確率,而且在推理效率上有10倍的加速比提升。

模型鏈接參考文末[2]。

在魔搭社區(qū)中,語音識(shí)別模型與語音合成一樣,提供Demo和Notebook兩種方式進(jìn)行效果體驗(yàn),操作方法請(qǐng)參見上文,不再贅述。

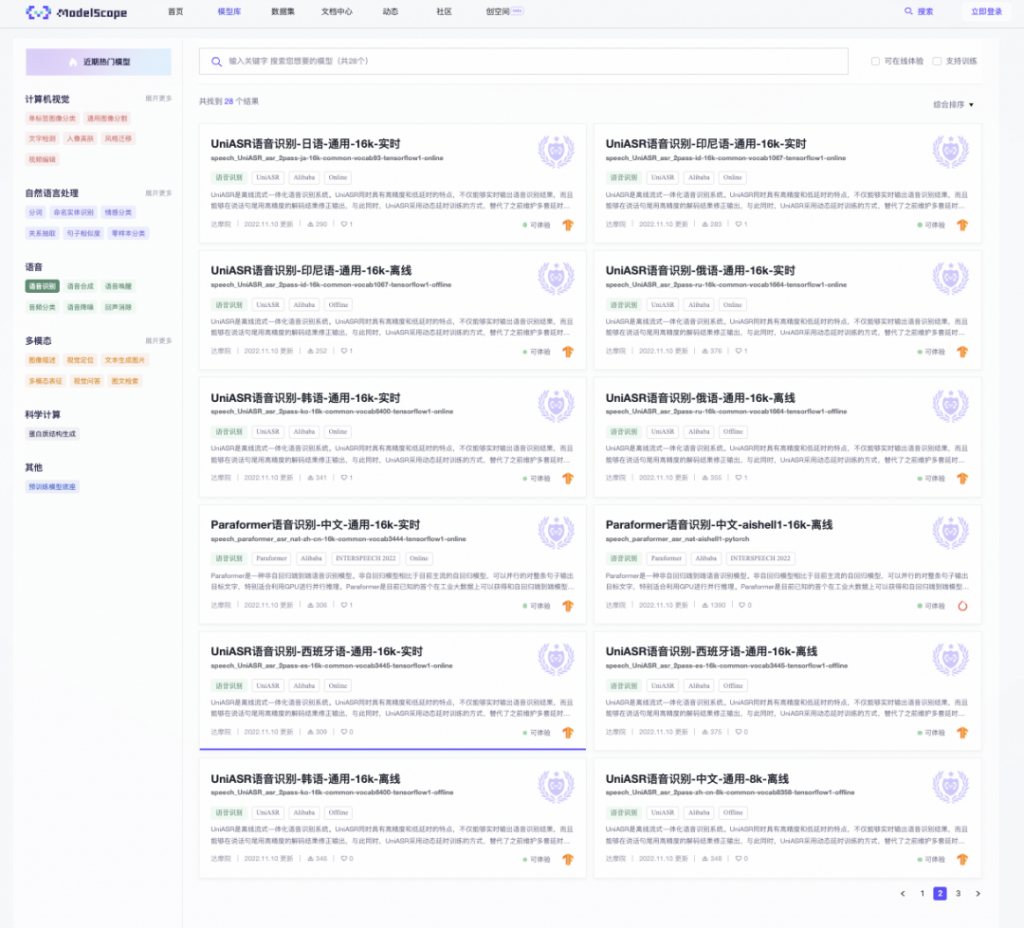

除了開放最先進(jìn)的Paraformer模型之外,語音實(shí)驗(yàn)室還免費(fèi)開放了當(dāng)紅的語音識(shí)別模型UniASR,它在公有云上提供商業(yè)化的服務(wù),廣受歡迎。UniASR模型含蓋了中、英、日、俄等語種,支持8k/16k采樣率,可以滿足開發(fā)者不同場(chǎng)景的開發(fā)需求。

模型鏈接參考文末[3]。

信號(hào)處理也是語音處理的一個(gè)重要的技術(shù)組成分支,達(dá)摩院開源了基于深度學(xué)習(xí)的回聲殘余抑制算法。

模型名:DFSMN回聲消除-單麥單參考-16k

模型鏈接參考文末[4]。

讓我們先來看一看這個(gè)模型的回聲消除算法的效果,下面兩段音頻分別是近講及遠(yuǎn)講采集的語音信號(hào):

下面的音頻是使用回聲消除模型的結(jié)果:

從用戶體驗(yàn)角度,一個(gè)理想的回聲消除算法要達(dá)到以下效果:遠(yuǎn)端單講(far end single talk)時(shí)零回聲泄露;近端單講(near end single talk)時(shí)語音無損;雙端同時(shí)講話時(shí)可以互相聽清,也即雙講(double talk)通透。目前在開源的信號(hào)處理算法當(dāng)中,雙講時(shí)的效果都比較差強(qiáng)人意。這是因?yàn)槟壳暗拈_源信號(hào)處理算法無法有效區(qū)分錄音信號(hào)中的回聲信號(hào)和近端語音信號(hào),而且真實(shí)通話中雙講出現(xiàn)的時(shí)間一般較短、時(shí)間占比也很低,所以從策略上為了確保零回聲泄露,只好犧牲雙講時(shí)的效果。

達(dá)摩院這個(gè)模型能夠進(jìn)一步提升雙講通話效果,滿足用戶對(duì)語音通信時(shí)的音質(zhì)要求,已在阿里內(nèi)部音視頻項(xiàng)目上完成了工業(yè)化部署。大家如果現(xiàn)在使用釘釘視頻會(huì)議,會(huì)發(fā)現(xiàn)了多一個(gè)較為方便的對(duì)講功能。這次模型開源,希望能對(duì)從事webRTC的研究者與開發(fā)者有所幫助,歡迎大家基于這個(gè)模型進(jìn)行應(yīng)用開發(fā),在NoteBook中只需要5行代碼就可以得到回聲消除結(jié)果。

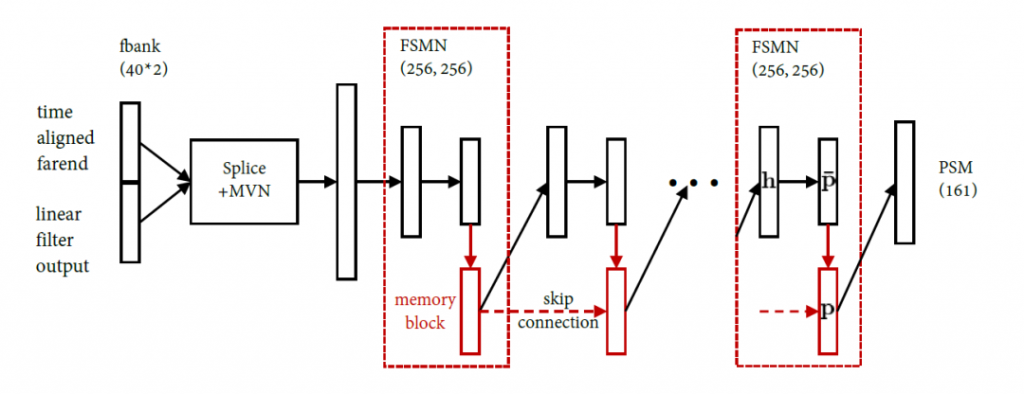

該模型的技術(shù)創(chuàng)新點(diǎn)在于借鑒了智能降噪的解決思路:數(shù)據(jù)模擬->模型優(yōu)化->模型推理。

具體而言,我們結(jié)合回聲殘余抑制的任務(wù)特點(diǎn),在輸入特征上,拼接了線性濾波器的輸出信號(hào)和時(shí)延對(duì)齊的回采信號(hào),并提取FBank進(jìn)行均值方差歸一化。在輸出目標(biāo)上,選擇了相位感知的掩蔽值(Phase-Sensitive Mask, PSM)。在模型推理階段,對(duì)PSM與線性輸出的信號(hào)頻譜逐點(diǎn)相乘后再進(jìn)行IFFT (inverse Fast Fourier Transform)獲得近端語音。

在過去的語音 AI 探索當(dāng)中,達(dá)摩院完整實(shí)現(xiàn)了從研到發(fā),從模型創(chuàng)新到提供API的全鏈條。但是隨著近年來語音AI的飛速發(fā)展,開發(fā)者角色變得多元化、各方面需求也變得越來越豐富,傳統(tǒng)的“包打天下”的模式已不再合適。面向未來,我們希望通過魔搭這樣的開放、開源的社區(qū)來推進(jìn)語音AI的研究和應(yīng)用,促進(jìn)語音AI生態(tài)的活躍和繁榮。

魔搭社區(qū)官網(wǎng)請(qǐng)點(diǎn)擊閱讀原文查看。參考鏈接:

[1]https://modelscope.cn/models/speech_tts/speech_sambert-hifigan_tts_zh-cn_multisp_pretrain_16k/summary

[2]https://modelscope.cn/models/damo/speech_paraformer_asr_nat-zh-cn-16k-common-vocab8358-tensorflow1/summary

[3]https://modelscope.cn/models/damo/speech_UniASR-large_asr_2pass-zh-cn-16k-common-vocab8358-tensorflow1-offline/summary

[4]https://modelscope.cn/models/damo/speech_dfsmn_aec_psm_16k/summary

文章轉(zhuǎn)自微信公眾號(hào)@阿里云開發(fā)者

鍵.png)

GraphRAG:基于PolarDB+通義千問api+LangChain的知識(shí)圖譜定制實(shí)踐

使用Node.js、Express和MySQL構(gòu)建REST API

天氣API推薦:精準(zhǔn)獲取氣象數(shù)據(jù)的首選

基于自定義數(shù)據(jù)集的微調(diào):Alpaca與LLaMA模型的訓(xùn)練

OAuth和OpenID Connect圖解指南

有哪些新聞媒體提供Open API?

現(xiàn)在做大模型,還有靠譜且免費(fèi)的API接口嗎?

如何運(yùn)用AI提高自己的工作效率?

區(qū)塊鏈API推薦,快速開發(fā)去中心化應(yīng)用

對(duì)比大模型API的內(nèi)容創(chuàng)意新穎性、情感共鳴力、商業(yè)轉(zhuǎn)化潛力

一鍵對(duì)比試用API 限時(shí)免費(fèi)