openai.chatcompletion.create用法和圖片鏈接詳解

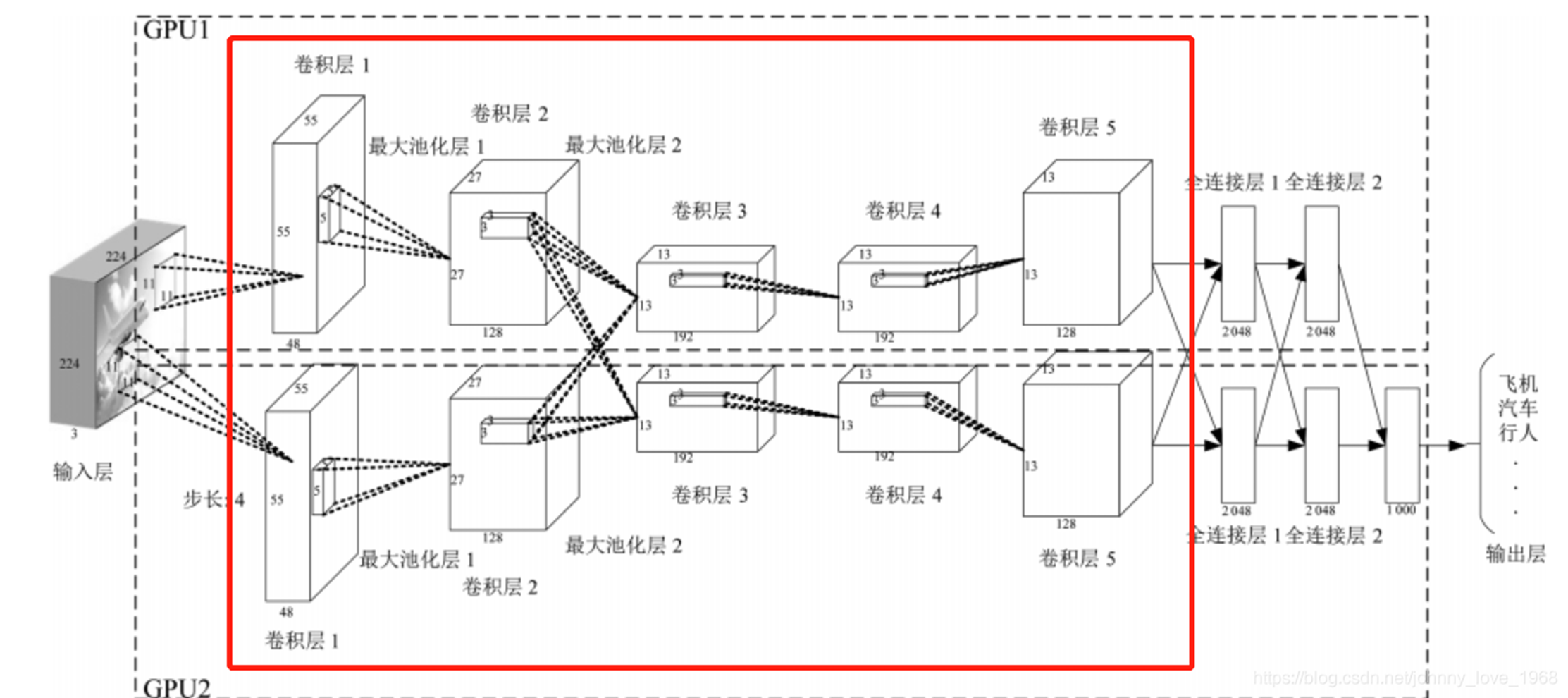

CNN由多個層次的網絡模塊構成,每個模塊具有特定的功能和作用。

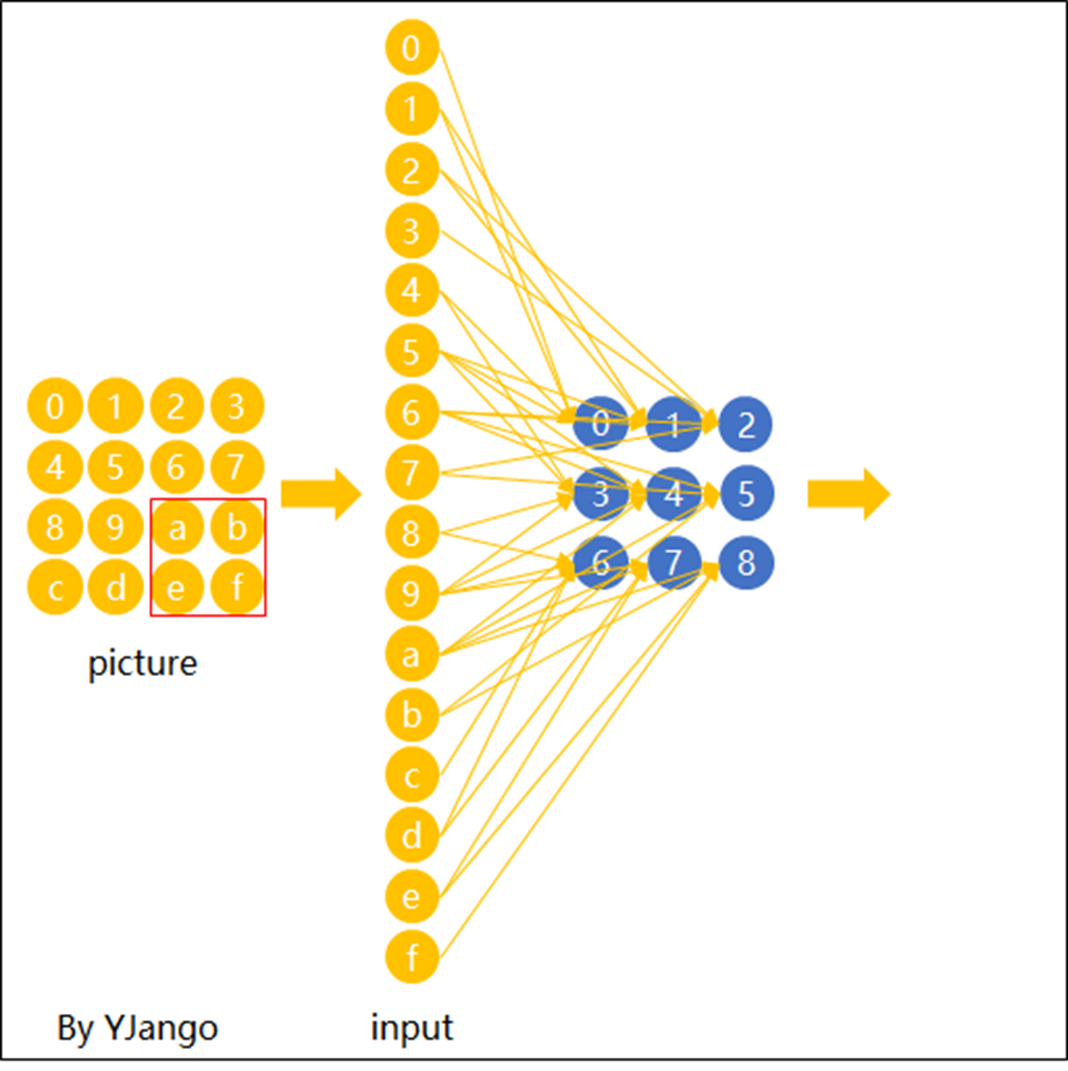

輸入層接收圖像數據,通常以RGB三通道的形式輸入到網絡中,形成一個二維矩陣。

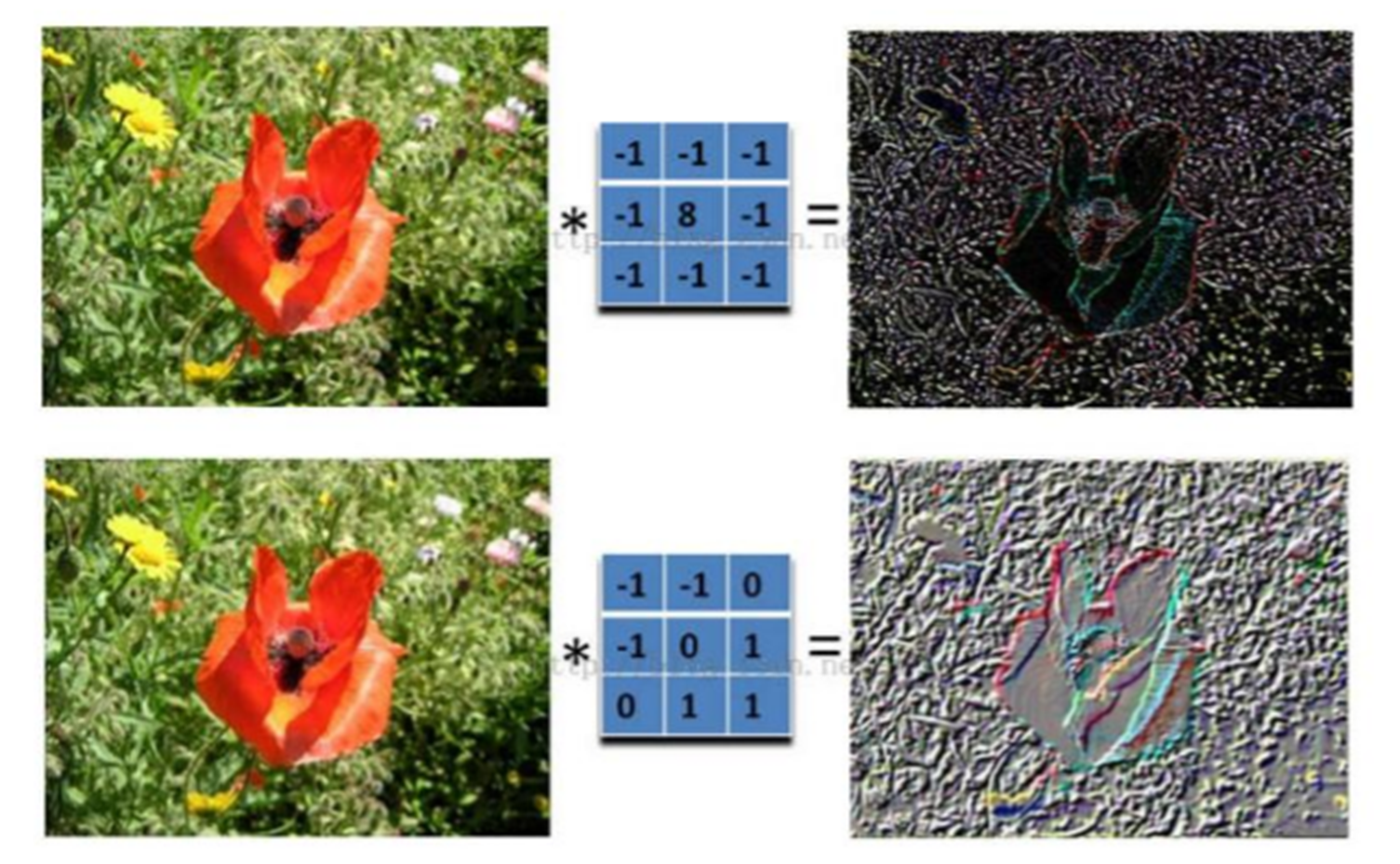

卷積層通過卷積核提取特征,并應用激活函數如ReLU來增加非線性能力,從而提高模型的表達能力。

池化層通過縮小特征圖的尺寸降低計算復雜度,并保留重要的特征信息。

實踐是理解CNN的最佳方式,下面我們來動手實現一個簡單的CNN模型。

在Keras中,我們可以通過Sequential API定義CNN的結構,包括卷積層、池化層和全連接層。

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)),

MaxPooling2D(pool_size=(2, 2)),

Flatten(),

Dense(units=128, activation='relu'),

Dense(units=10, activation='softmax')

])在進行訓練之前,需要對輸入圖像進行標準化處理,以適應模型的輸入要求。

使用訓練數據集對模型進行訓練,并通過測試集評估模型的準確度和泛化能力。

CNN在許多實際項目中得到了廣泛應用,尤其是在計算機視覺領域。

CNN擅長處理圖像分類問題,如識別圖像中的物體類別。

通過結合區域提取算法,CNN可以實現復雜的目標檢測任務。

生成對抗網絡(GAN)利用CNN生成高質量的圖像,廣泛用于圖像增強和修復。

在使用CNN時,可能會遇到一些常見問題,以下是一些優化技巧。

使用正則化技術如dropout可以有效防止模型過擬合,提高泛化能力。

通過減少網絡層數或參數數量來降低模型復雜度,從而提高計算效率。

調整學習率、批量大小等超參數可以幫助模型更好地收斂,提高訓練效果。

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Densemodel = Sequential([

Conv2D(32, (3, 3), activation=’relu’, input_shape=(64, 64, 3)),

MaxPooling2D(pool_size=(2, 2)),

Flatten(),

Dense(units=128, activation=’relu’),

Dense(units=10, activation=’softmax’)

])

### 問:在使用CNN時如何應對過擬合問題?

- 答:使用正則化技術如dropout可以有效防止模型過擬合,提高泛化能力。此外,調整學習率、批量大小等超參數也可以幫助模型更好地收斂,提高訓練效果。