AI聊天無敏感詞:技術原理與應用實踐

Transformer模型由Google在2017年推出,其獨特的架構設計在性能上具有顯著優勢,迅速成為NLP領域的明星架構。Transformer模型的核心在于自注意力機制,它使得模型能夠并行處理序列數據,有效捕捉序列中的長距離依賴關系。

自注意力機制是Transformer模型中的關鍵創新之一。它允許模型在序列的任意位置間直接建立依賴關系,不受距離限制。這種機制使得模型在處理長序列時更加高效和準確。

由于自注意力機制的引入,Transformer模型能夠實現并行處理,極大地提高了模型的訓練效率。這對于大規模數據集和復雜模型尤為重要。

GPT系列模型由OpenAI團隊開發,從GPT-1到GPT-4o,每個版本的發布都標志著AI技術的重大進步。

2018年,OpenAI發布了GPT-1模型,這是首次將Transformer架構應用于生成式預訓練模型。GPT-1采用了僅有解碼器的Transformer模型,專注于預測下一個詞元。

GPT-2模型將參數規模擴大到15億,使用大規模網頁數據集WebText進行預訓練。GPT-2的研究重點在于多任務學習,通過一種通用的概率形式來刻畫不同任務的輸出預測。

2020年,OpenAI推出了具有里程碑意義的GPT-3模型,其模型參數規模擴展到了175B,相較于GPT-2提升了100余倍。GPT-3首次提出了“上下文學習”概念,允許大語言模型通過少樣本學習解決各種任務。

GPT-4模型首次將輸入模態從單一文本擴展到圖文雙模態,顯著增強了模型的視覺能力和安全性。GPT-4在解決復雜任務方面的能力顯著強于GPT-3.5。

GPT-4o是一個多模態大模型,支持文本、音頻和圖像的任意組合輸入,并能生成文本、音頻和圖像的任意組合輸出。GPT-4o在視覺和音頻理解方面尤其出色,展現了AI技術的全新發展方向。

大模型技術如自然語言處理和圖像識別正在推動人工智能的新發展階段。通過學習大模型課程,可以掌握設計和實現基于大模型的應用系統所需的基本原理和技術。

學習大模型課程能夠極大地促進個人在人工智能領域的專業發展。大模型技術在多個行業中的應用日益增加,掌握這一技術將有助于提高就業競爭力。

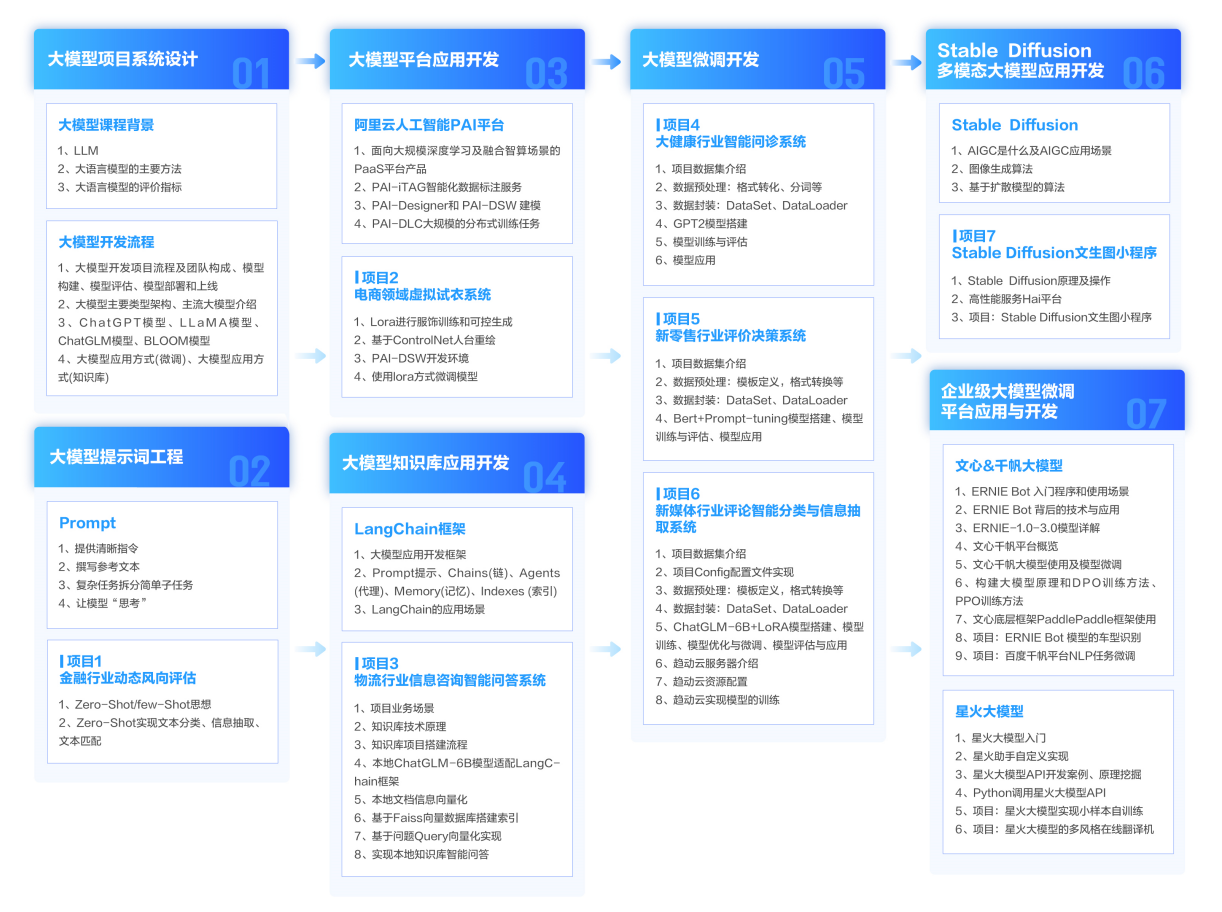

整個學習分為7個階段,從基礎理論到實戰案例,涵蓋AI大模型的各個方面。

從入門到進階,跟著老師學習事半功倍。