如何調(diào)用 Minimax 的 API

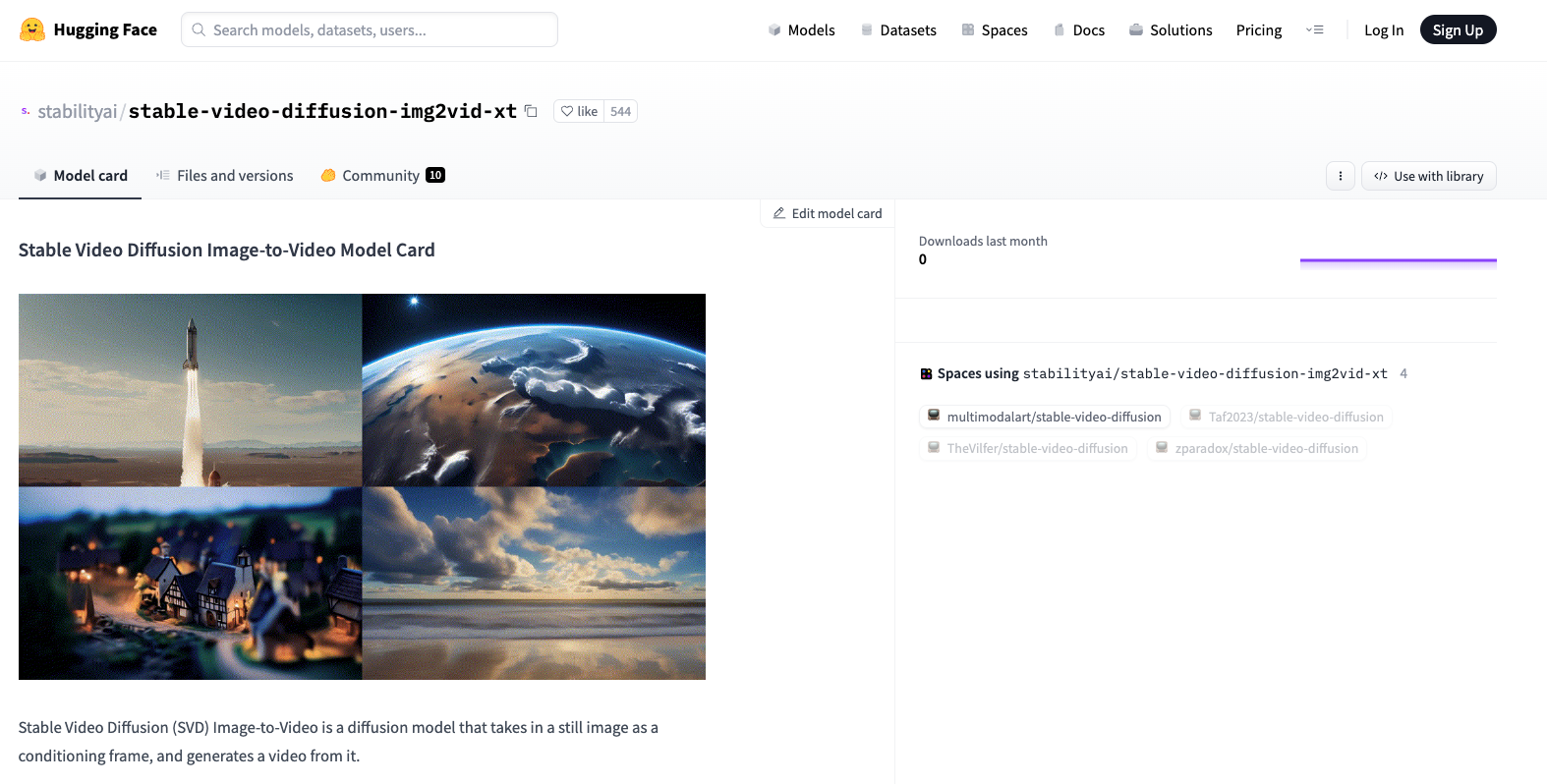

Stability AI 的這一開創(chuàng)性工作不僅為開發(fā)者提供了靈活的開發(fā)環(huán)境,還計(jì)劃圍繞該基礎(chǔ)模型建立一個(gè)完整的生態(tài)系統(tǒng),使其能夠適應(yīng)多種下游任務(wù)。根據(jù)外部評(píng)估,Stable Video Diffusion 的模型 SVD 和 SVD-XT 在用戶偏好研究中表現(xiàn)優(yōu)于其他同類產(chǎn)品。

Stable Video Diffusion 依賴于擴(kuò)散模型(DMs)和無分類器引導(dǎo),并結(jié)合專門設(shè)計(jì)的視頻生成基礎(chǔ)模型架構(gòu)。這一復(fù)雜的技術(shù)架構(gòu)使得模型能夠?qū)⑽谋竞蛨D像輸入轉(zhuǎn)化為生動(dòng)的視頻場(chǎng)景。

擴(kuò)散模型在生成過程中起到關(guān)鍵作用,通過逐步改進(jìn)和細(xì)化輸入數(shù)據(jù),使得輸出視頻更加自然和逼真。該模型能夠生成 14 幀和 25 幀的視頻,幀速率在 3 到 30 幀每秒之間可調(diào)。

無分類器引導(dǎo)是另一項(xiàng)關(guān)鍵技術(shù),它通過避免使用分類器來減少可能的偏差,從而提高生成視頻的質(zhì)量和一致性。

Stable Video Diffusion 可廣泛應(yīng)用于媒體、娛樂、教育和營(yíng)銷等領(lǐng)域。其核心功能包括:

這些功能使得用戶能夠快速生成高質(zhì)量的短視頻,滿足各種應(yīng)用場(chǎng)景的需求。

在媒體和娛樂領(lǐng)域,Stable Video Diffusion 可以用于生成動(dòng)畫短片、影視特效等,提高創(chuàng)作效率和作品質(zhì)量。

在教育和營(yíng)銷領(lǐng)域,該模型可以用于制作生動(dòng)的教學(xué)視頻和廣告片段,提升信息傳達(dá)的效果和用戶體驗(yàn)。

雖然 Stable Video Diffusion 提供了許多創(chuàng)新功能,但在使用過程中仍存在一些局限性。Stability AI 強(qiáng)調(diào),目前該模型還不適用于實(shí)際或商業(yè)應(yīng)用,且網(wǎng)頁體驗(yàn)尚未向所有人開放。

該模型的推出主要是為了研究目的,以便在不斷的實(shí)踐中改進(jìn)和優(yōu)化其性能。

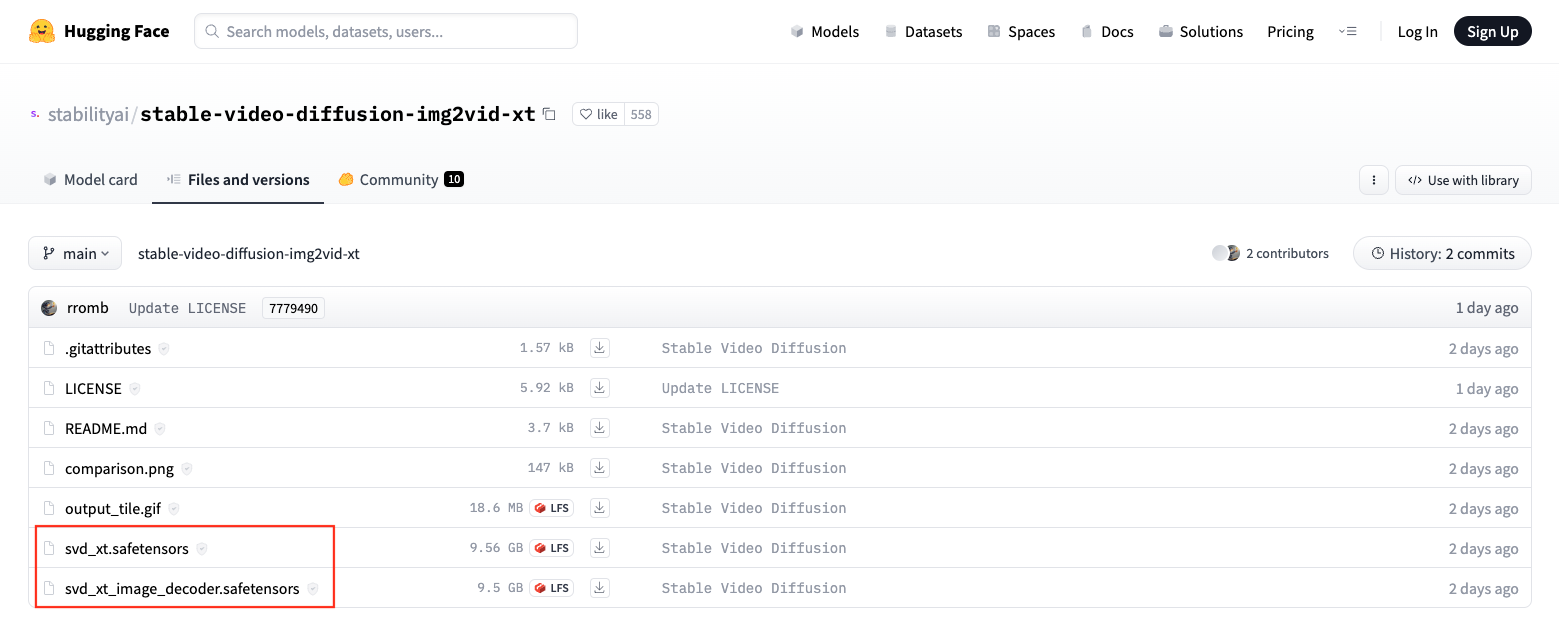

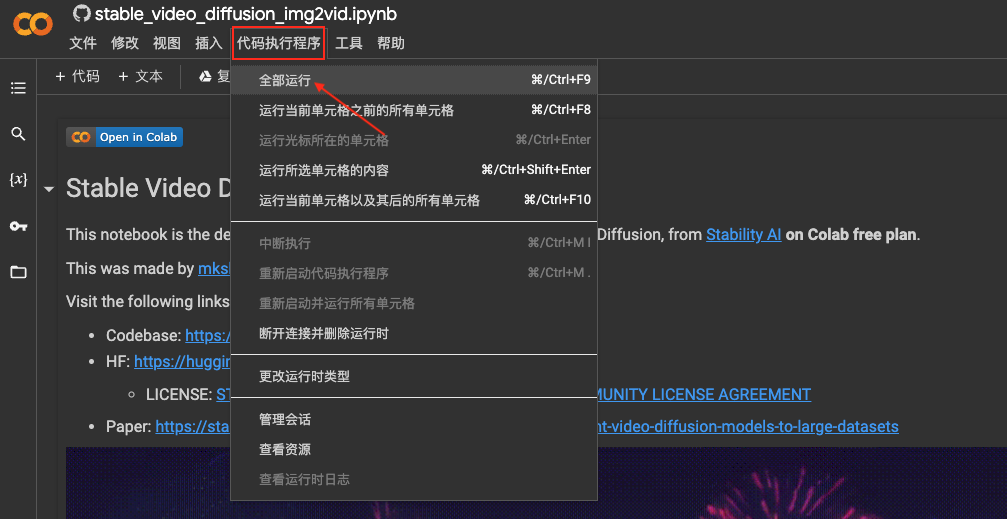

用戶可以通過 Hugging Face 的體驗(yàn)鏈接訪問 Stable Video Diffusion。雖然目前訪問存在一些限制,但感興趣的用戶仍可通過申請(qǐng)候補(bǔ)來體驗(yàn)該模型。

隨著技術(shù)的進(jìn)步,Stable Video Diffusion 未來可能會(huì)在以下幾個(gè)方面進(jìn)行改進(jìn):

通過不斷優(yōu)化模型架構(gòu)和算法,提升視頻質(zhì)量和生成速度。

開發(fā)更多應(yīng)用場(chǎng)景,使其在商業(yè)廣告、影視制作等領(lǐng)域發(fā)揮更大作用。

訪問以下鏈接了解更多 Stable Video Diffusion 的相關(guān)信息和技術(shù)細(xì)節(jié):

問:Stable Video Diffusion 可以用于商業(yè)項(xiàng)目嗎?

問:如何提高生成視頻的質(zhì)量?

問:Stable Video Diffusion 的視頻生成速度如何?

通過這篇文章,希望讀者對(duì) Stable Video Diffusion 的開源版本有一個(gè)全面的了解,并對(duì)其在不同領(lǐng)域的應(yīng)用潛力有更深入的認(rèn)識(shí)。

對(duì)比大模型API的內(nèi)容創(chuàng)意新穎性、情感共鳴力、商業(yè)轉(zhuǎn)化潛力

一鍵對(duì)比試用API 限時(shí)免費(fèi)