如何調用 Minimax 的 API

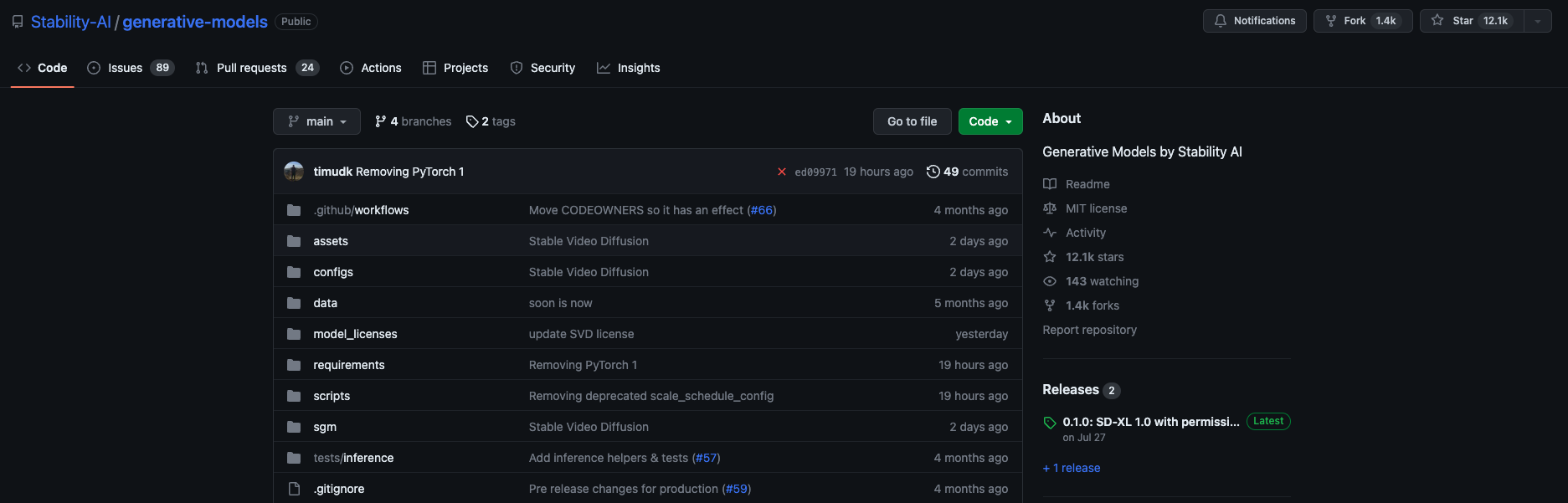

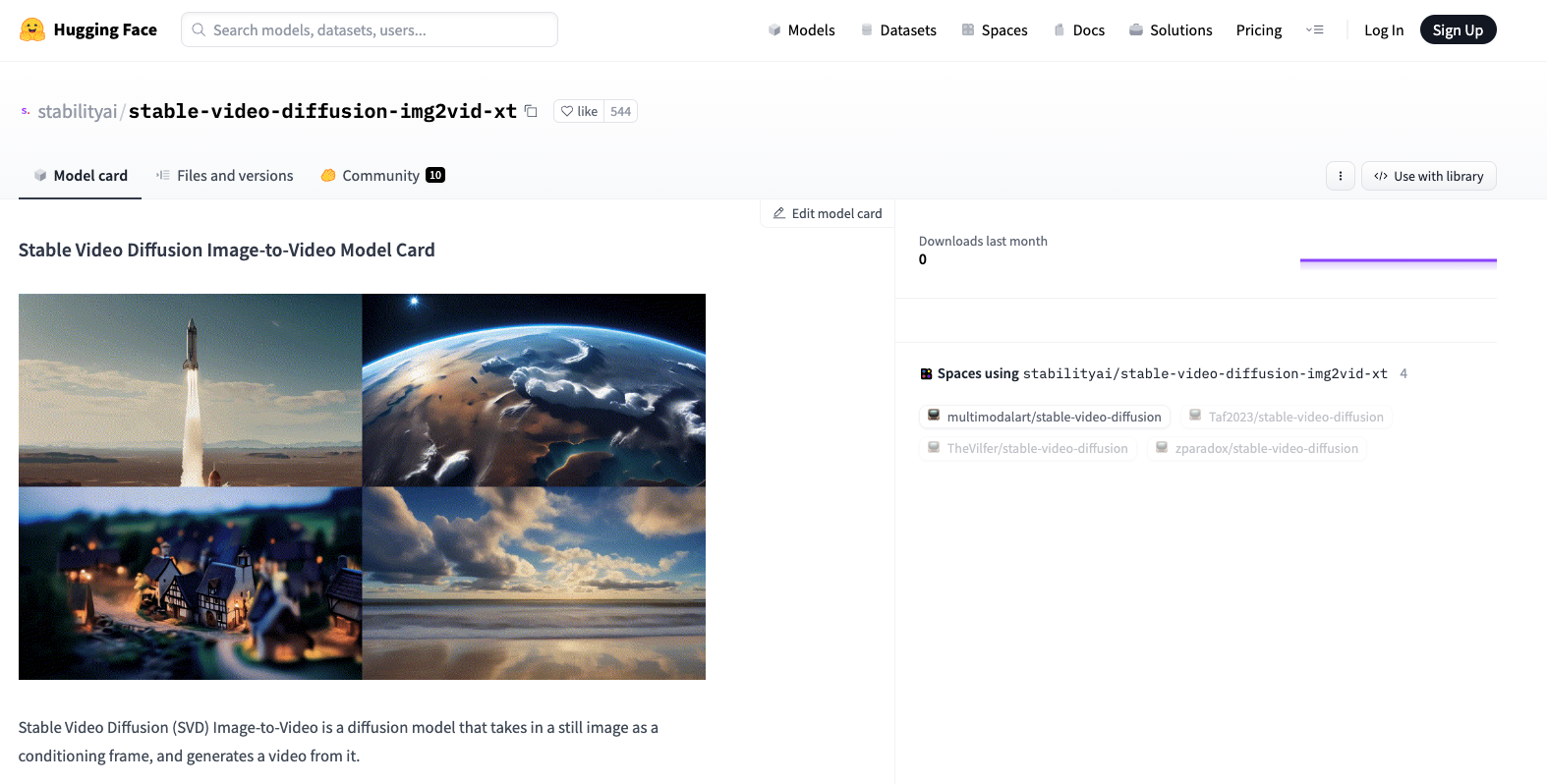

Stability AI 已經在 GitHub 上開源了該技術的代碼,并在 Hugging Face 提供了模型的權重文件。這使得開發者可以在本地機器上運行并優化模型,進一步滿足個性化需求。

在當今快速發展的數字化環境中,API 的申請和使用變得越來越重要。Stable Video Diffusion API 的推出,為開發者和企業提供了便捷的接口來訪問其強大的視頻生成功能,簡化了從圖片到視頻的轉換過程。

其背后的技術依托于深度學習和擴散模型,通過逐步噪聲添加和去除的方法,模型能夠從靜態圖像生成動態視頻。這種轉換不僅為創作者提供了新的表達方式,也為商業應用提供了更多可能。

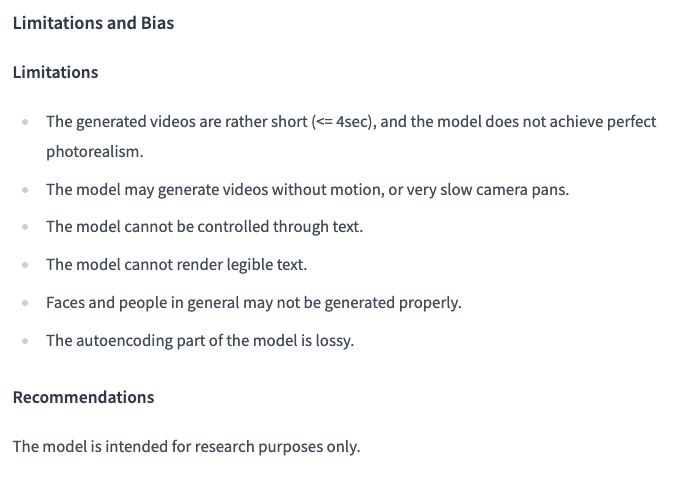

盡管該技術在視頻生成領域取得了顯著進展,但仍然存在一些局限性需要注意:

這些局限性部分是由于模型自編碼時的損耗引起的,未來的版本可能會通過優化算法和增加數據集來改善這些問題。

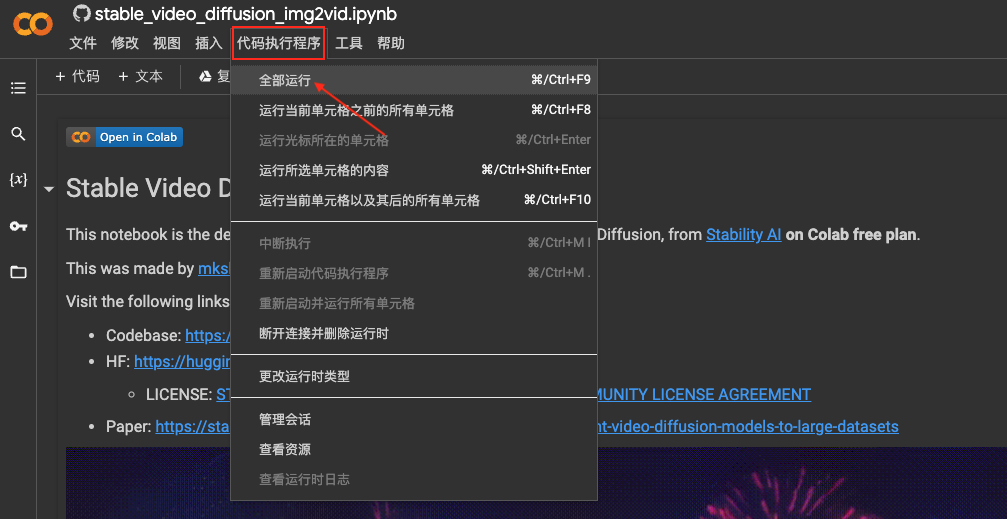

申請 Stable Video Diffusion API 的過程相對簡單,開發者可以通過訪問 Stability AI 的官方網站提交申請,并獲得相應的 API 密鑰。以下是使用 API 的基本步驟:

pip install torch torchvision訪問 Stability AI 官網申請 API 密鑰。擁有密鑰后,開發者可以在 API 請求中使用它來驗證身份。

import requests

url = 'https://api.stability.ai/v1/video'

headers = {'Authorization': 'Bearer YOUR_API_KEY'}

files = {'file': open('image.jpg', 'rb')}

response = requests.post(url, headers=headers, files=files)

video_output = response.json()['video_url']

Stable Video Diffusion 的應用范圍廣泛,從創意設計到企業廣告,它都能發揮重要作用。例如,通過將風景圖片轉換為視頻,可以為旅游宣傳提供生動的視覺素材。

假設我們有一張美麗的山景圖片,使用 Stable Video Diffusion,可以將其轉換為一個動態的視頻片段,展示云層和陽光的變化。

python generate_video.py --input_folder input_images --output_video output_video.mp4Stable Video Diffusion 技術的未來發展方向包括提升視頻的清晰度、增加生成長度以及改善文本控制等功能。這需要不斷優化模型算法和擴展數據集以滿足日益增長的市場需求。

答:可以嘗試增加輸入圖片的分辨率,并調整生成參數中的噪聲水平來優化視頻的清晰度。

答:目前 API 支持批量處理,但具體性能可能會受限于服務器資源。

答:確保 API 請求中包含正確的 API 密鑰,并檢查密鑰的有效期和權限范圍。

答:目前,Stable Video Diffusion 主要用于研究目的,商業化應用需獲得 Stability AI 的授權。

答:可以使用更高性能的計算設備,或者通過優化輸入數據和參數配置來提升生成速度。

通過以上內容,我們詳細探討了 Stable Video Diffusion 的申請、使用及其在視頻生成領域的應用潛力。相信隨著技術的不斷進步,它將在更多領域展現出其強大的影響力。