Stable Diffusion Agent 開發:技術解析與應用前景

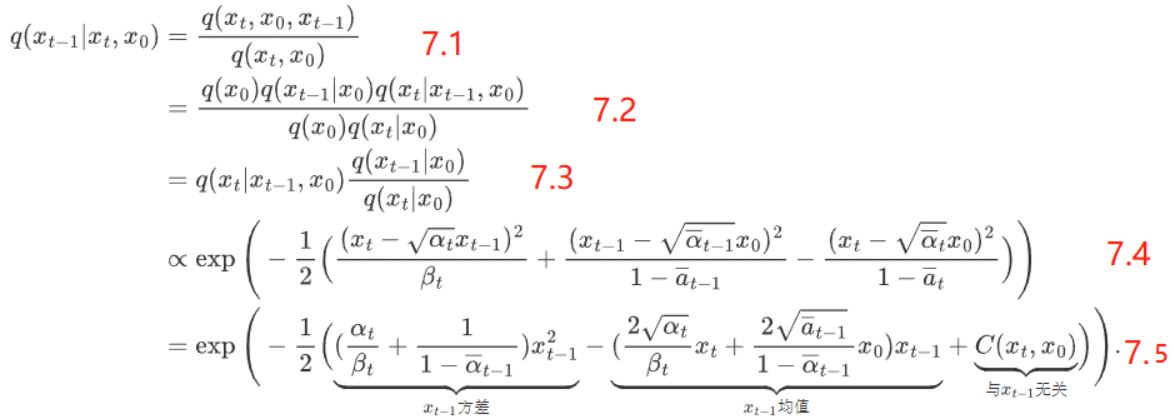

逆向過程的目標是從給定的噪聲狀態恢復到清晰的初始圖像。利用貝葉斯公式,通過迭代地減少噪聲,模型能夠逐步得到更接近原圖的表示。逆向過程的實現需要精確的噪聲預測和去噪算法。

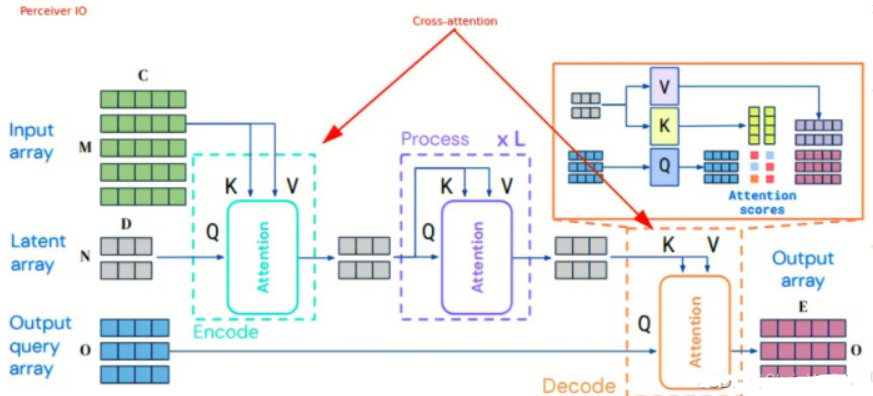

Unet 中引入 Cross Attention 機制,通過結合文本和圖像的多模態信息,增強模型生成的準確性。在這一過程中,模型將文本特征和潛在圖像特征進行交叉注意力處理,實現了不同模態之間的信息融合。

Stable Diffusion 的訓練過程涉及多個階段,核心包括以下幾個步驟:

推理階段,模型通過輸入文本描述生成圖像,過程如下:

在開始使用Stable Diffusion的代碼之前,需要安裝相關的Python包,如 transformers 和 diffusers:

!pip install --upgrade diffusers transformers確保安裝的版本符合項目要求,以避免兼容性問題。

Stable Diffusion 的實現涉及多個模塊,以下是關鍵代碼段的解析:

import torch

from diffusers import UNet2DConditionModel, PNDMScheduler, AutoencoderKL

from transformers import CLIPTokenizer, CLIPTextModel

text_tokenizer = CLIPTokenizer.from_pretrained(model_path)

text_encoder = CLIPTextModel.from_pretrained(model_path)

unet = UNet2DConditionModel.from_pretrained(model_path)

vae = AutoencoderKL.from_pretrained(model_path)

text_inputs = text_tokenizer(prompt, return_tensors='pt')

text_embeddings = text_encoder(text_inputs.input_ids)[0]

scheduler = PNDMScheduler()

scheduler.set_timesteps(num_timesteps)

latents = torch.randn((batch_size, latent_dim), generator=generator)

for t in scheduler.timesteps:

latents = scheduler.step(latents, t, text_embeddings)

image = vae.decode(latents)在實際應用中,可以根據需要對模型和代碼進行擴展和優化,如調整擴散步數、優化推理速度等。此外,通過結合其他視覺模型或增強技術,可以進一步提升生成效果。

Stable Diffusion 作為一種創新的文本到圖像生成技術,展現了其在計算機視覺領域的巨大潛力。通過對其核心組件和實現過程的詳細解析,我們可以更好地理解其工作原理,并應用于實際項目。本文提供的代碼示例和FAQ也為讀者在使用過程中提供了實用的指導。

問:Stable Diffusion 適用于哪些應用場景?

問:如何提高Stable Diffusion模型的生成質量?

問:Stable Diffusion 與其他生成模型有何不同?

問:是否需要高性能硬件來運行Stable Diffusion?

問:如何在Stable Diffusion中加入自定義的文本描述?