PixverseAI互動功能(HUG)在AI擁抱視頻生成中的應用

Qwen2.5-Max 是一個稠密的 decoder-only 模型,支持多達 128K tokens 的輸入,能夠生成最多 8K tokens 的內容。這一特性使其在處理長文本和復雜數據結構時,表現尤為突出。與其前身 Qwen2 相比,Qwen2.5-Max 不僅在編程能力和數學能力上超越前者,還在指令執行和結構化數據理解方面取得了顯著改進。

Qwen2.5-Max 專為編程應用設計,能夠有效執行編程相關任務。模型在 5.5 T tokens 的編程數據上進行訓練,使其在 HumanEval 基準測試中表現優異,甚至可以媲美某些大型語言模型。

Qwen2.5-Max 也在數學領域表現出色,其數學模型通過整合多種推理方法,包括 Chain of Thought(CoT)、Program of Thought(PoT)和 Tool-Integrated Reasoning(TIR),在處理數學問題時展現出卓越的能力。

除了開源模型,Qwen2.5-Max 還提供了通過 API 使用的便捷途徑。用戶可以通過阿里云百煉平臺訪問這些 API,實現多樣化的應用場景。API 服務提供了不同版本的模型供選擇,用戶可以根據需求選擇適合的模型,如 Qwen-Plus 或 Qwen-Turbo,以滿足不同的性能和響應速度要求。

API 的定價是基于輸入和輸出 tokens 的數量來計算的,這為用戶提供了靈活的選擇。對于需要高級推理和深刻理解的復雜任務,Qwen-Plus 是一個理想的選擇,而 Qwen-Turbo 則在提供快速響應的同時,保持了較高的準確度,非常適合實時應用。

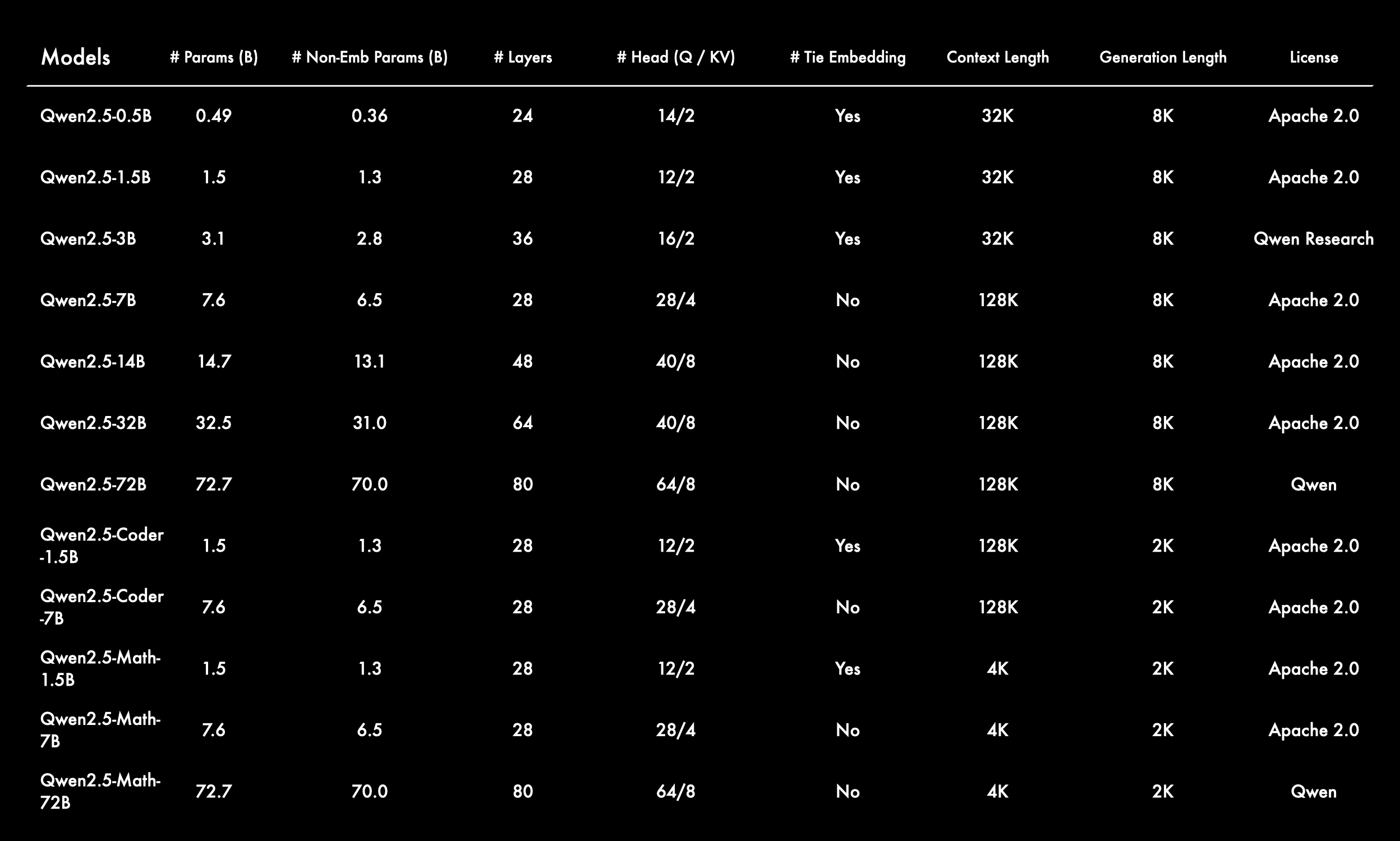

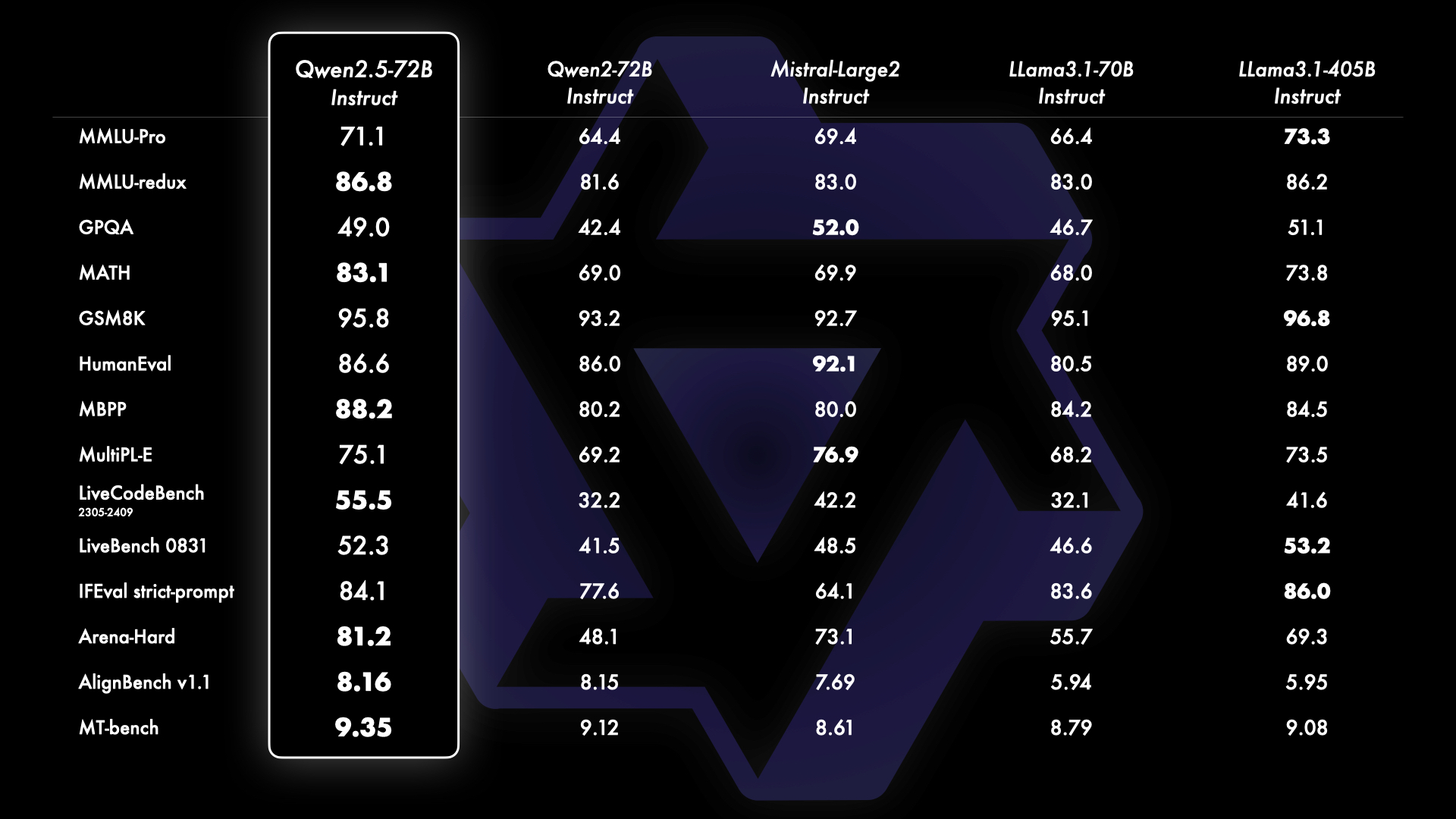

Qwen2.5-Max 在多個基準測試中表現出色。以 Qwen2.5-72B 為例,這個擁有 720 億參數的模型在與其他領先開源模型的對比中,展現了其強大的能力。基于指令調優的版本在任務執行和人類偏好方面均取得了優異的成績。

近年來,小型語言模型(SLMs)的性能逐漸逼近大型語言模型(LLMs),Qwen2.5-3B 模型在僅有 30 億參數下取得了顯著的成果,展示了該系列模型的高效性和強大能力。

Qwen2.5-Max 可以通過多種方式使用,包括直接調用 Hugging Face Transformers 庫或通過 vLLM 開啟與 OpenAI API 兼容的服務。用戶可以使用 Python 代碼與模型進行交互,或通過 vLLM 的內置工具調用功能,方便地集成到現有的工作流中。

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen2.5-7B-Instruct"

model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto", device_map="auto")

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompt = "Give me a short introduction to large language model."

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=512)

generated_ids = [output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)]

response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0]Qwen 團隊不斷推動技術進步,未來將繼續專注于整合多模態信息處理能力。隨著強化學習和推理計算的進一步發展,Qwen2.5-Max 將在更多領域展現其潛力。我們期待與開源社區合作,共同推動語言模型的革新與應用。

問:Qwen2.5-Max 的主要優勢是什么?

問:如何通過 API 使用 Qwen2.5-Max?

問:Qwen2.5-Max 在小型語言模型中表現如何?

問:如何優化 Qwen2.5-Max 的使用?

問:Qwen2.5-Max 支持哪些語言?