Node.js 后端開發指南:搭建、優化與部署

在設計上,PyTorch 引入了動態計算圖(Dynamic Computation Graph),與 TensorFlow 的靜態計算圖形成鮮明對比。這一特性使得研究人員可以在運行時動態調整模型結構,從而更靈活地處理復雜任務。

PyTorch 提供了以下幾個核心特性,使其在深度學習領域獨樹一幟:

PyTorch 被廣泛應用于許多深度學習任務,包括但不限于:

Tensor 是 PyTorch 的核心數據結構,與 NumPy 的數組類似,但支持 GPU 加速。以下是一些常見的 Tensor 創建方法:

import torch

# 創建一個未初始化的 5x3 矩陣

x = torch.empty(5, 3)

print(x)

# 創建一個隨機初始化的 5x3 矩陣

x = torch.rand(5, 3)

print(x)

# 創建一個 5x3 的零矩陣

x = torch.zeros(5, 3, dtype=torch.long)

print(x)Tensor 支持的操作包括索引、切片、矩陣運算等,用戶可以方便地在 CPU 和 GPU 之間切換。

PyTorch 的自動求導機制通過 torch.autograd 模塊實現。下面是一個簡單的示例:

# 創建一個 Tensor 并啟用梯度計算

x = torch.ones(2, 2, requires_grad=True)

y = x + 2

z = y * y * 3

out = z.mean()

# 反向傳播

out.backward()

print(x.grad) # 輸出梯度此機制使得用戶無需手動計算復雜的梯度,極大地簡化了深度學習的實現。

PyTorch 提供了豐富的 Tensor 運算,包括矩陣乘法、轉置、求逆等。例如:

# 矩陣乘法

x = torch.randn(3, 3)

y = torch.randn(3, 3)

z = torch.mm(x, y)

print(z)這些操作對于構建復雜的神經網絡模型至關重要。

在使用 GPU 加速時,首先需要檢查系統是否支持 GPU:

import torch

if torch.cuda.is_available():

print("GPU 可用")

else:

print("GPU 不可用")將 Tensor 和模型移動到 GPU 上的操作非常簡單:

# 將 Tensor 移動到 GPU

x = torch.randn(3, 3)

x = x.to('cuda')

# 將模型移動到 GPU

model = torch.nn.Linear(10, 1)

model = model.to('cuda')

使用 GPU 進行深度學習訓練可以顯著縮短訓練時間。例如,在 CIFAR10 數據集上訓練 ResNet 模型時,GPU 的訓練速度遠遠快于 CPU。以下是一個對比示例:

# 在 GPU 上訓練模型

for epoch in range(10):

inputs, labels = inputs.to('cuda'), labels.to('cuda')

outputs = model(inputs)通過合理利用 GPU 資源,可以極大地提高模型訓練的效率。

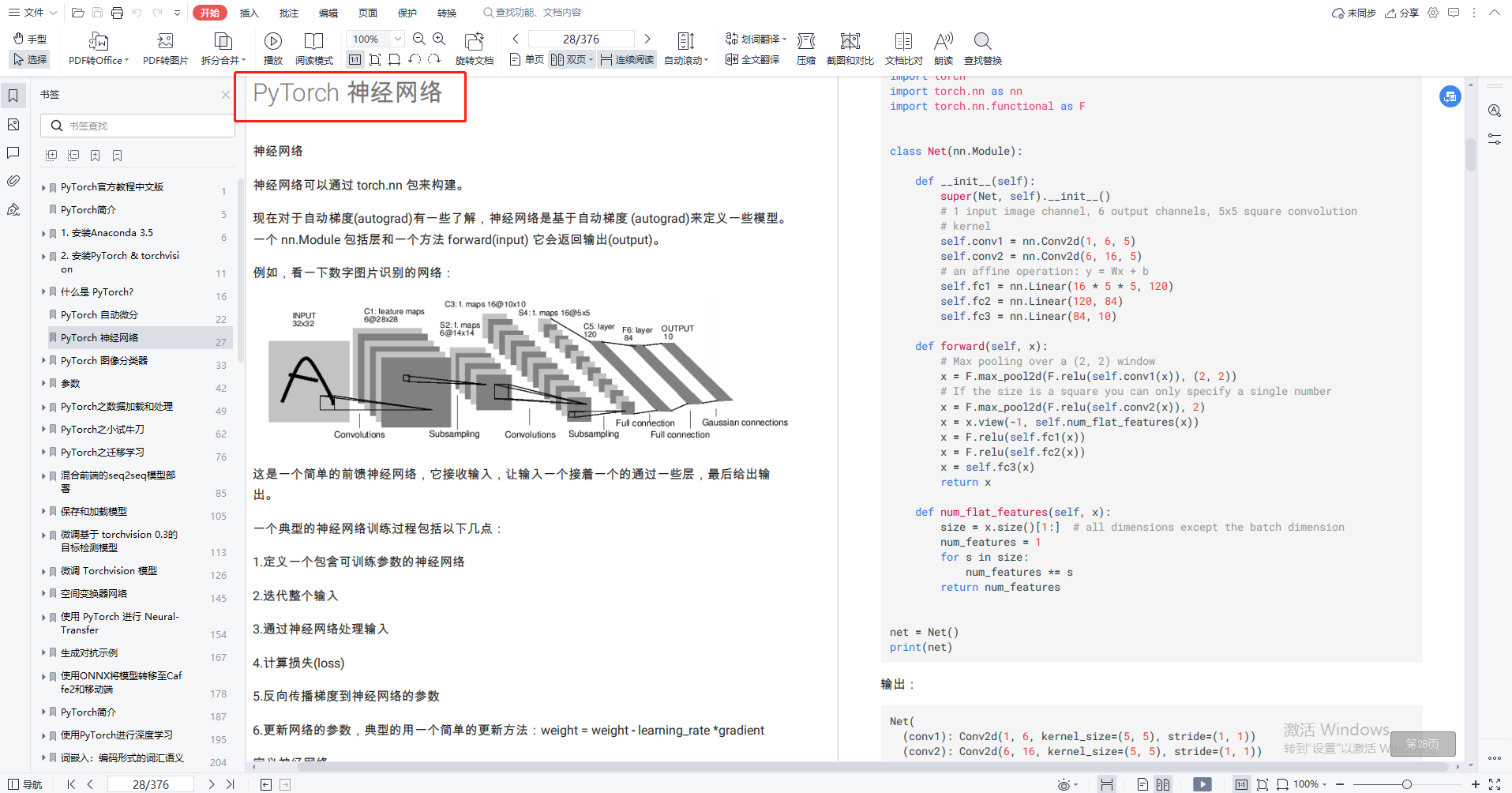

PyTorch 提供了 torch.nn 模塊,用于構建神經網絡。以下是一個簡單的神經網絡示例:

import torch.nn as nn

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.conv1 = nn.Conv2d(1, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.fc1 = nn.Linear(6 * 14 * 14, 120)

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = x.view(-1, 6 * 14 * 14)

x = F.relu(self.fc1(x))

return x

net = Net()PyTorch 提供了 torch.utils.data 模塊,用于高效地加載和處理數據。例如:

from torchvision import datasets, transforms

transform = transforms.Compose([

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))

])

dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

data_loader = torch.utils.data.DataLoader(dataset, batch_size=64, shuffle=True)數據增強可以提高模型的泛化能力。常用的方法包括隨機裁剪、翻轉等:

transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.RandomCrop(32, padding=4),

transforms.ToTensor()

])

訓練模型的過程包括前向傳播、損失計算、反向傳播和參數更新:

for epoch in range(2):

for data in data_loader:

inputs, labels = data

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()在測試集中評估模型性能:

correct = 0

total = 0

with torch.no_grad():

for data in test_loader:

images, labels = data

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy: {100 * correct / total}%')

PyTorch 支持保存模型參數或整個模型結構:

# 保存模型參數

torch.save(model.state_dict(), 'model.pth')

# 保存整個模型

torch.save(model, 'entire_model.pth')加載模型時,需要使用與保存時一致的模型結構:

# 加載模型參數

model.load_state_dict(torch.load('model.pth'))

# 加載整個模型

model = torch.load('entire_model.pth')加載模型后,切換到評估模式:

model.eval()

from torchvision import datasets, transforms

transform = transforms.Compose([

transforms.RandomHorizontalFlip(),

transforms.RandomCrop(32, padding=4),

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))

])

train_set = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

train_loader = torch.utils.data.DataLoader(train_set, batch_size=64, shuffle=True)class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 32, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

self.fc1 = nn.Linear(64 * 8 * 8, 512)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = F.relu(self.conv1(x))

x = F.max_pool2d(x, 2)

x = F.relu(self.conv2(x))

x = F.max_pool2d(x, 2)

x = x.view(-1, 64 * 8 * 8)

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

model = SimpleCNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

for epoch in range(10):

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()torch.cuda.is_available() 來檢測 GPU 的可用性,并使用 to('cuda') 方法將 Tensor 和模型移動到 GPU。