Docker 運行 Ollama

Docker 是一種輕量級的虛擬化技術,可以用于快速部署和運行 Ollama。用戶可以通過以下命令在 Docker 中運行 Ollama:

docker run -d --gpus=all -v ollama:/root/.ollama -p 11434

此命令會在后臺啟動一個 Ollama 容器,并通過 11434 端口提供服務。用戶需要確保 Docker 已正確安裝并支持 GPU 加速,以充分利用 AI 模型的性能。

Ollama AI 模型的下載和運行

用戶可以通過 Ollama 提供的命令行工具下載和運行 AI 模型。首先,訪問 Ollama 模型庫,選擇所需的模型并運行以下命令進行下載:

ollama run llama3.1

下載完成后,用戶可以通過 API 接口進行問答和其他任務。為了提供 API 服務,用戶需要安裝代理服務并配置相應的環境。

安裝代理服務

在提供 API 服務之前,用戶需要安裝代理服務。首先,創建一個新的虛擬環境并激活它:

python -m venv D:/ollama

ollama/Scripts/activate.bat

接下來,安裝必要的 Python 包:

(ollama)> pip install litellm

pip install litellm[proxy]

運行模型并提供服務

在安裝完代理服務后,用戶可以使用以下命令運行模型并提供服務:

litellm --model ollama/llama3.1

此時,Ollama 模型已在本地服務器上運行,用戶可以通過 API 接口進行交互。

Ollama 的環境變量配置

在使用 Ollama 提供服務時,合理配置環境變量可以大大提升其性能和可用性。以下是一些常用的環境變量設置:

OLLAMA_HOST:設置 Ollama 服務監聽的網絡地址,默認是 127.0.0.1。若需對外提供服務,可設置為 0.0.0.0。OLLAMA_PORT:指定 Ollama 服務監聽的端口,默認是 11434。若有沖突,可修改為其他端口。OLLAMA_KEEP_ALIVE:指定模型加載到內存中后的存活時間。建議設置為 24h 提高訪問速度。OLLAMA_MAX_LOADED_MODELS:限制同時加載到內存中的模型數量,默認是 1。

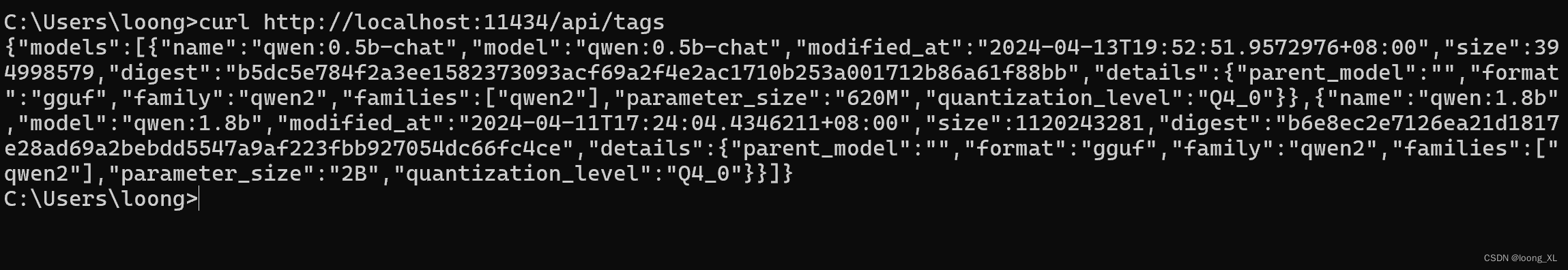

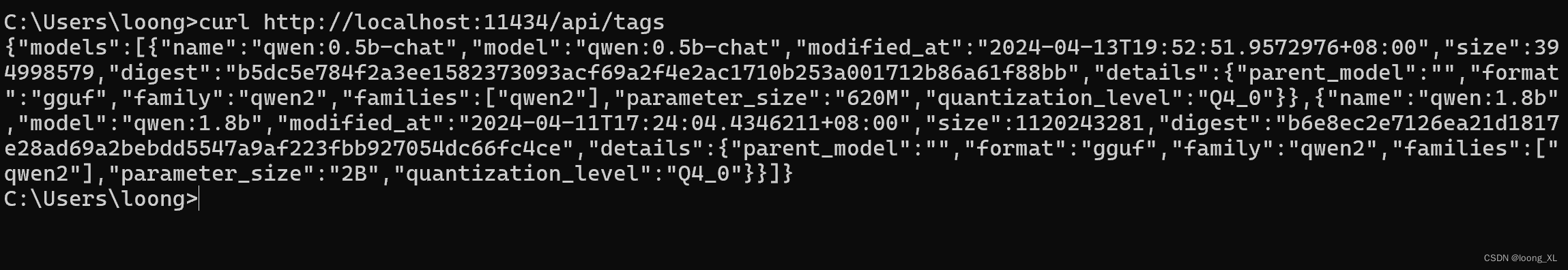

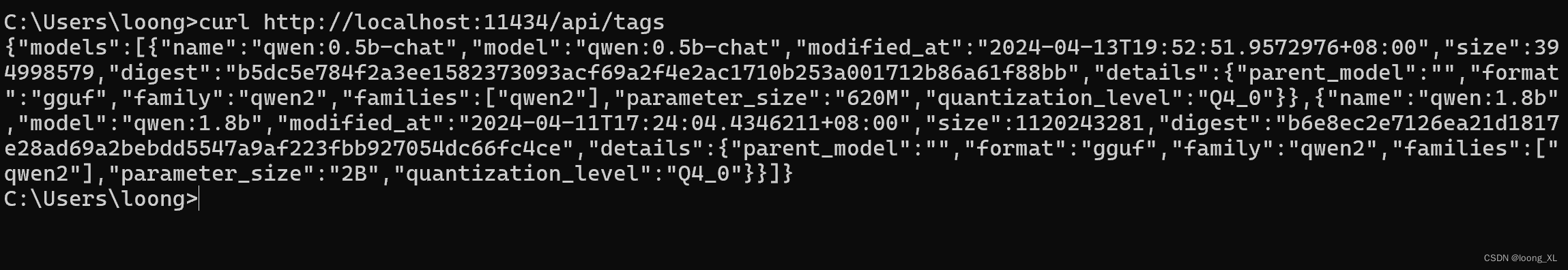

Ollama 的 API 調用

Ollama 提供兩種主要的 API 接口:/api/generate 和 /api/chat。前者用于生成單個文本片段,而后者則支持對話式的多輪交互。

API 生成示例

用戶可以通過以下代碼片段調用 Ollama 的 API 進行文本生成:

import requests

import json

def generate_text(model, prompt):

url = 'http://localhost:11434/api/generate'

data = {

"model": model,

"prompt": prompt,

}

response = requests.post(url, headers={'Content-Type': 'application/json'}, data=json.dumps(data))

if response.status_code == 200:

result = response.json().get('response', '')

print(result)

else:

print(f"Error: {response.status_code}")generate_text('llama3.1', '你好')

流式聊天示例

以下是使用 Ollama chat API 的示例代碼:

import requests

import json

def chat_with_model(model, messages):

url = 'http://localhost:11434/api/chat'

data = {

"model": model,

"messages": messages,

"stream": True

}

response = requests.post(url, headers={'Content-Type': 'application/json'}, json=data)

for line in response.iter_lines():

if line:

print(json.loads(line)['content'])chat_with_model('qwen2:latest', [{'role': 'user', 'content': '你好'}])

FAQ

什么是 Ollama?

Ollama 是一個支持多種 AI 模型的平臺,用戶可以通過它下載和運行模型,并通過 API 提供智能服務。

如何修改 Ollama 的模型存儲位置?

用戶可以通過設置環境變量 OLLAMA_MODELS 來修改模型的存儲路徑。例如,在 Windows 系統中,可以設置為 E:ollamamodels。

Ollama 支持哪些類型的 API?

Ollama 提供 /api/generate 和 /api/chat 兩種 API。前者用于生成文本片段,后者用于支持對話的交互。

如何運行 Ollama 的模型?

用戶可以使用命令 ollama run <model_name> 下載并運行模型。在 Docker 中運行 Ollama 則需要使用 docker run 命令。

環境變量 OLLAMA_KEEP_ALIVE 有什么作用?

OLLAMA_KEEP_ALIVE 用于設置模型在內存中的存活時間。設置較長的時間可以提高訪問速度,避免頻繁加載模型。

熱門推薦

一個賬號試用1000+ API

助力AI無縫鏈接物理世界 · 無需多次注冊

3000+提示詞助力AI大模型

和專業工程師共享工作效率翻倍的秘密

国内精品久久久久影院日本,日本中文字幕视频,99久久精品99999久久,又粗又大又黄又硬又爽毛片

精品国产网站在线观看|

中文字幕乱码久久午夜不卡|

麻豆精品一区二区综合av|

国产精品高清亚洲|

亚洲最大成人综合|

日本在线不卡视频|

高清成人在线观看|

日本高清不卡一区|

日韩亚洲欧美综合|

欧美性一二三区|

3d动漫精品啪啪|

国产精品久久福利|

国产真实乱对白精彩久久|

欧美视频日韩视频|

亚洲色图制服诱惑|

成人av中文字幕|

久久精品网站免费观看|

日韩高清不卡在线|

精品亚洲免费视频|

欧美一级一级性生活免费录像|

中文字幕在线一区|

91免费看`日韩一区二区|

精品日韩在线一区|

激情文学综合丁香|

精品国产一区二区三区四区四|

欧美一区二区三区在线看|

秋霞影院一区二区|

久久久精品人体av艺术|

国产精品18久久久久久久网站|

国产精品无圣光一区二区|

国产.欧美.日韩|

亚洲影视在线观看|

精品乱人伦一区二区三区|

国产欧美日韩在线|

懂色av一区二区三区免费观看|

国产欧美一区二区精品忘忧草|

av一二三不卡影片|

日韩1区2区日韩1区2区|

国产精品久久久久毛片软件|

色老综合老女人久久久|

久久精品国产亚洲aⅴ

|

乱中年女人伦av一区二区|

欧美精品丝袜中出|

国产一本一道久久香蕉|

91精品国产欧美日韩|

丁香激情综合国产|

亚洲精品久久久蜜桃|

国产女人aaa级久久久级|

狠狠狠色丁香婷婷综合久久五月|

国产欧美日本一区视频|

精品国产自在久精品国产|

精品乱人伦小说|

精品亚洲免费视频|

日韩欧美国产三级|

欧美日韩免费高清一区色橹橹

|

精品一区二区三区不卡

|

91在线国产福利|

蜜臀国产一区二区三区在线播放

|

精品剧情在线观看|

欧美大片在线观看一区二区|

欧洲精品一区二区三区在线观看|

国产成人免费视频一区|

国产在线精品一区在线观看麻豆|

天天影视涩香欲综合网|

日韩 欧美一区二区三区|

麻豆91在线观看|

亚洲影院在线观看|

日本系列欧美系列|

国产成人在线观看|

99久久99精品久久久久久|

91丝袜美腿高跟国产极品老师

|

欧美四级电影在线观看|

91一区二区三区在线观看|

色综合久久中文综合久久97|

国产伦精品一区二区三区视频青涩|

粉嫩绯色av一区二区在线观看

|

欧美成人高清电影在线|

午夜在线成人av|

日本精品免费观看高清观看|

久久蜜桃一区二区|

国产一区二区在线观看视频|

欧美日韩aaaaaa|

日本一区二区三区久久久久久久久不|

青青草成人在线观看|

欧美日韩国产首页在线观看|

中文字幕一区二区三区视频|

国产精品 日产精品 欧美精品|

欧美电影免费观看高清完整版在线|

国产日韩精品一区|

成人av第一页|

《视频一区视频二区|

日韩av午夜在线观看|

日韩欧美国产麻豆|

国产一区二区三区观看|

欧美日韩国产高清一区二区三区

|

在线欧美日韩精品|

天堂成人国产精品一区|

91精品国产综合久久久久久久久久

|

日本高清视频一区二区|

亚洲欧洲另类国产综合|

91一区一区三区|

日韩成人免费电影|

国产网站一区二区|

99re这里只有精品视频首页|

亚洲欧美日韩中文字幕一区二区三区|

欧洲中文字幕精品|

日本一不卡视频|

欧美tickling网站挠脚心|

亚洲精品国产精华液|

色婷婷综合久久久久中文

|

亚洲电影中文字幕在线观看|

久久精品一区二区|

久久色.com|

www.亚洲激情.com|

国产一区二区电影|

免费欧美在线视频|

精品国产一区二区三区久久久蜜月

|

欧美日韩夫妻久久|

久久疯狂做爰流白浆xx|

一区二区三区欧美视频|

国产精品美女视频|

亚洲午夜激情av|

久久99久久99小草精品免视看|

亚洲精品乱码久久久久久|

欧美一级片在线观看|

91精品一区二区三区久久久久久|

欧美日韩一区中文字幕|

精品成人一区二区|

国产精品无人区|

中文字幕一区二区三区精华液|

国产精品女人毛片|

一区二区在线免费观看|

亚洲成人www|

国产在线看一区|

91亚洲国产成人精品一区二三|

欧美日韩另类一区|

亚洲人成精品久久久久久|

国产中文字幕精品|

在线综合视频播放|

中文字幕一区二区三区在线不卡

|

69堂亚洲精品首页|

中文字幕日韩一区|

国产精品中文字幕一区二区三区|

色视频成人在线观看免|

国产成人av电影在线|

欧美v亚洲v综合ⅴ国产v|

亚洲精品乱码久久久久|

www.欧美.com|

亚洲欧美日韩一区|

一本色道久久综合亚洲aⅴ蜜桃|

精品国产一区二区三区久久影院|

亚洲成人动漫av|

日韩一二三区不卡|

国产美女精品在线|

欧美精选一区二区|

免费av成人在线|

国产精品美女久久久久久|

国产成人日日夜夜|

亚洲黄色av一区|

高清国产一区二区|

国产精品久久久久久久久快鸭|

99国产精品视频免费观看|

亚洲综合999|

日韩写真欧美这视频|

国产综合久久久久影院|

亚洲人吸女人奶水|

欧洲一区二区三区免费视频|

国产精品久久久一本精品

|

欧美色精品在线视频|

久久99精品网久久|

日韩一区在线播放|

久久综合资源网|

91精品国产91综合久久蜜臀|

狠狠色丁香婷婷综合久久片|

亚洲精品国产一区二区精华液

|

青青青爽久久午夜综合久久午夜|

欧美性欧美巨大黑白大战|

激情六月婷婷久久|

理论电影国产精品|

日本免费新一区视频

|

欧美手机在线视频|

欧美亚男人的天堂|

国产iv一区二区三区|

久久久久久久久99精品|

精品久久99ma|

欧美群妇大交群中文字幕|

一本久久a久久免费精品不卡|

国产成人综合精品三级|

xvideos.蜜桃一区二区|

国产视频一区在线观看|

91成人国产精品|

欧美三级视频在线|

久久午夜免费电影|

亚洲蜜臀av乱码久久精品蜜桃|

精品成人在线观看|

国产目拍亚洲精品99久久精品|

一区二区三区免费看视频|

亚洲一区国产视频|

高清不卡一二三区|

国产精品一品视频|