文心一言寫代碼:代碼生成力的探索

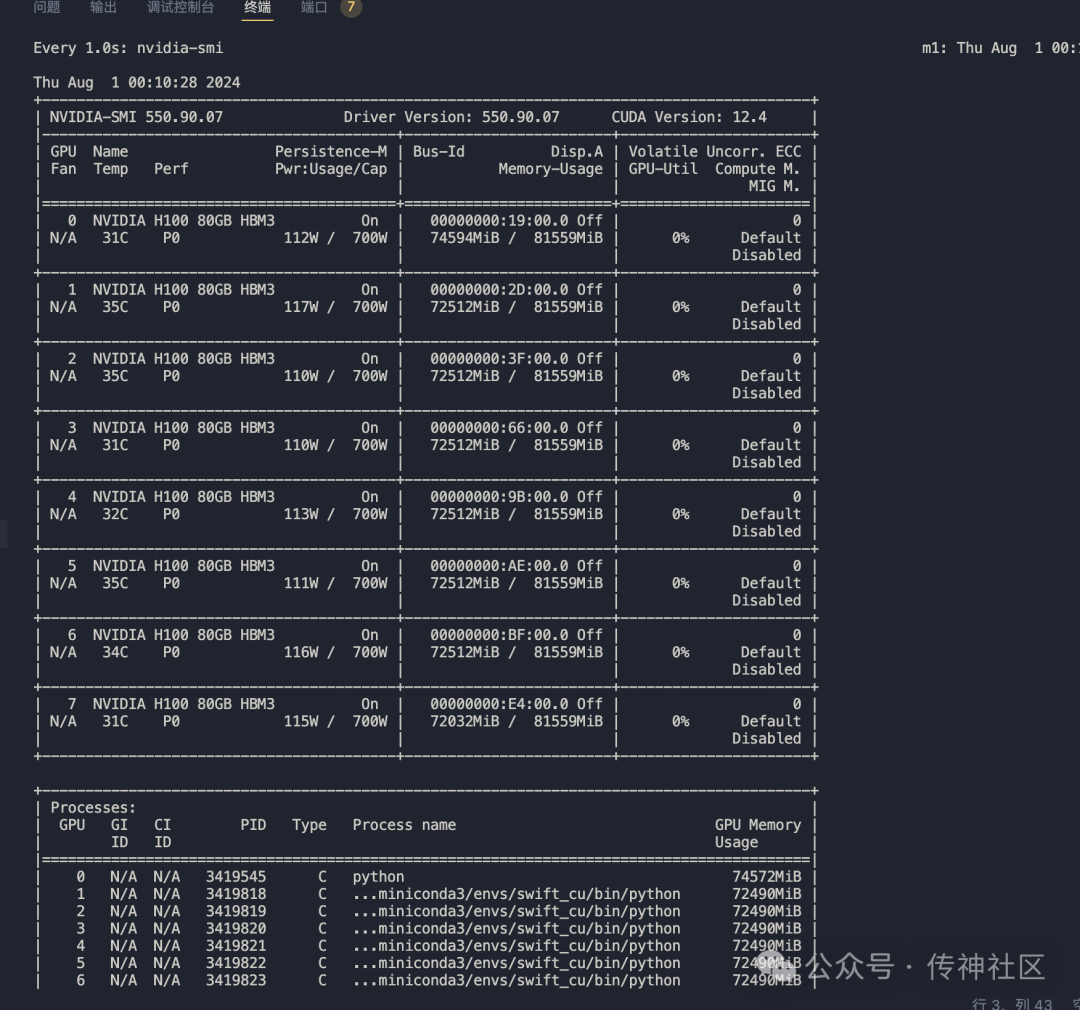

在部署 Mistral-Large-Instruct-2407 時,推薦的硬件配置是使用4張A800顯卡,以確保模型能夠充分發揮其潛力。以下是部署該模型的詳細步驟:

CUDA_VISIBLE_DEVICES=0,1,2,3 python -m vllm.entrypoints.openai.api_server

--model /data/models/Mistral-Large-Instruct-2407/

--served-model-name aaa

--trust-remote-code

--tensor-parallel-size 4

--port 8000部署成功后,可以通過標準的OpenAI接口來訪問此模型。這種部署方式不僅提高了模型的可用性,還使得在不同系統上的集成變得更加便捷。

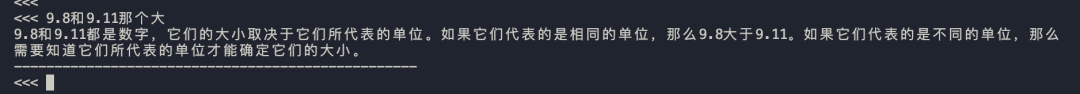

為了測試 Mistral-Large-Instruct-2407 的性能,我們使用了一個經典的問題:“9.11和9.9哪個大?為什么?”。以下是模型的回復:

9.11 比 9.9 大。

原因如下:

1. 比較整數部分:9.11 和 9.9 的整數部分都是 9,所以它們相等。

2. 比較小數部分:9.11 的小數部分是 0.11,而 9.9 的小數部分是 0.9。

3. 將小數部分轉換為相同的單位進行比較:0.11 = 11 個 0.01,而 0.9 = 90 個 0.01。

4. 比較 11 個 0.01 和 90 個 0.01:顯然,9.11 比 9.9 多了 0.01。盡管模型給出的結論正確,但在推理過程中出現了一些小錯誤,例如“9.11 比 9.9 多了 0.01”的部分。盡管如此,這并不影響模型在其他應用場景中的表現。

Mistral-Large-Instruct-2407 官方宣稱支持最大128k的token,但在實際測試中發現,模型的 config.json 中的參數配置顯示 "max_position_embeddings": 32768。這意味著,目前放出的模型最大token僅支持32k。超出這個限制的請求會導致以下錯誤:

BadRequestError: Error code: 400 - {'object': 'error', 'message': "This model's maximum context length is 32768 tokens. However, you requested 74761 tokens in the messages, Please reduce the length of the messages.", 'type': 'BadRequestError', 'param': None, 'code': 400}這一問題在社區中也引發了廣泛討論,目前官方還未給出明確的解決方案。

盡管 Mistral-Large-Instruct-2407 在函數調用能力上表現優異,但 vllm 部署目前不支持該功能。對此,社區用戶已經向 vllm 官方提交了功能請求,希望能夠在未來的版本中實現此功能。

CSG-Wukong-Chinese-Mistral-Large2-123B 是基于 Mistral-Large-Instruct-2407 的一個重要變種,經過微調后在中文處理任務上表現更為出色。其訓練數據涵蓋了大量高質量的中文文本,使得模型在多種語境下生成自然、流暢的文本。

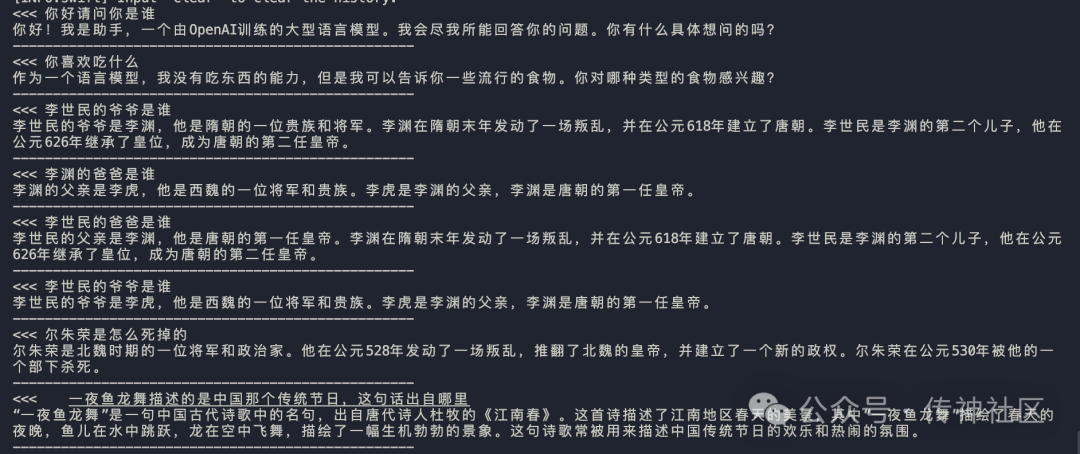

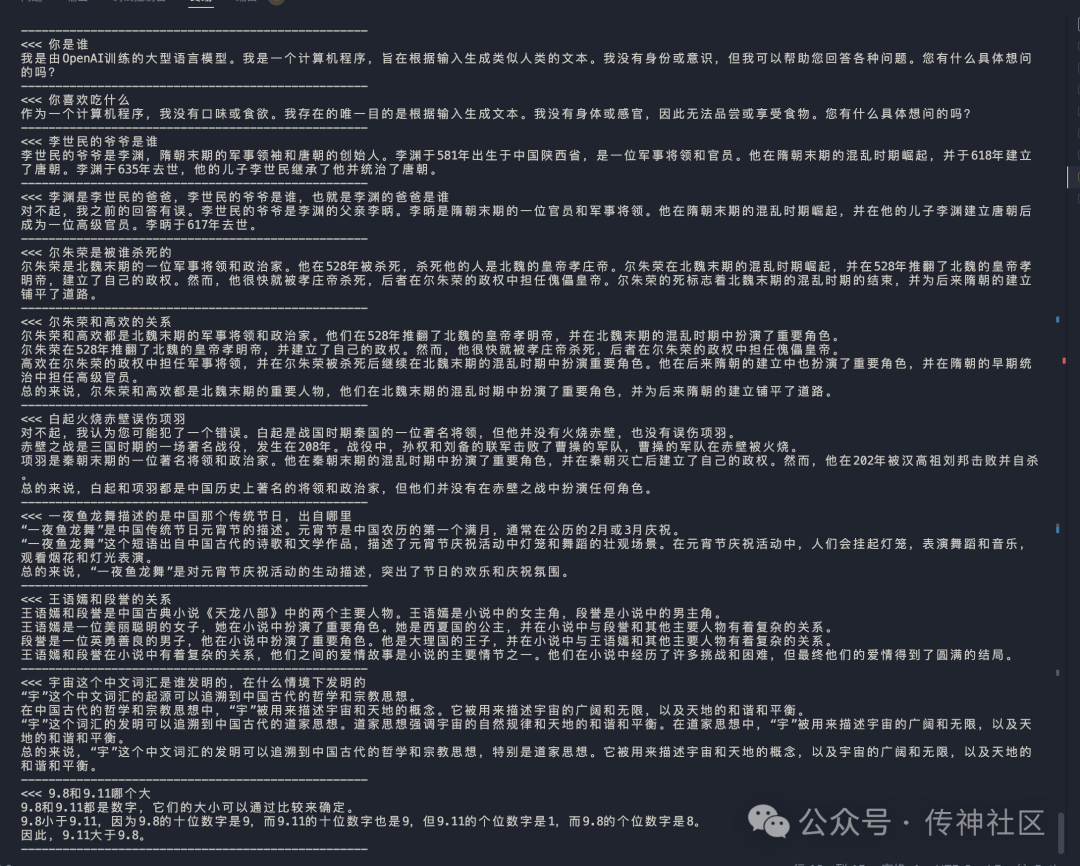

在推理階段,CSG-Wukong-Chinese-Mistral-Large2-123B 展示了卓越的性能和效果。以下是模型在推理過程中生成的對話示例:

通過與 Llama3.1-405B 中文版的對比,我們可以看出,CSG-Wukong-Chinese-Mistral-Large2-123B 在對話生成的流暢性、語義理解的準確性和上下文關聯性方面均表現出色。

通過本次微調,Mistral-Large-Instruct-2407 模型的中文能力得到了顯著提升。開發者和研究人員可以通過以下鏈接下載模型,并加入OpenCSG社區,共同探索大型語言模型的應用和發展。

Github主頁:OpenCSG GitHub

Huggingface主頁:OpenCSG Huggingface

問:Mistral-Large-Instruct-2407 支持多少種語言?

問:如何解決最大token限制的問題?

問:CSG-Wukong-Chinese-Mistral-Large2-123B 的主要優勢是什么?

問:如何參與 OpenCSG 社區?

問:Mistral-Large-Instruct-2407 的應用場景有哪些?