NG是什么意思:深度解析與應用

量化方法主要包括量化訓練(QAT)、動態(tài)離線量化(PTQ Dynamic)和靜態(tài)離線量化(PTQ Static)。這些方法各有優(yōu)劣,通常根據具體應用場景選擇。

llama.cpp是GGML開發(fā)者推出的純C/C++推理引擎,支持多種設備和操作系統(tǒng),能夠在低配硬件上運行量化后的模型。其高效的硬件利用率使得推理速度顯著提升。

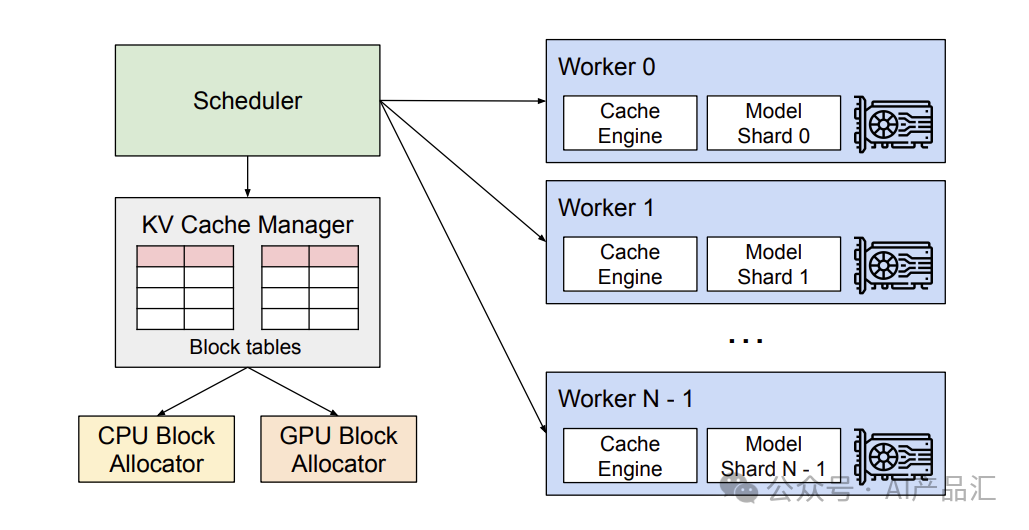

vLLM是加州大學伯克利分校開發(fā)的GPU推理框架,采用PagedAttention管理KV緩存,有效提升了大模型的運行速度。支持多種量化方法,適用于NVIDIA和AMD GPUs。

Xorbits Inference提供了一鍵部署的能力,支持多模態(tài)模型的推理。通過該平臺,可以利用最前沿的AI模型進行創(chuàng)新應用的開發(fā)。

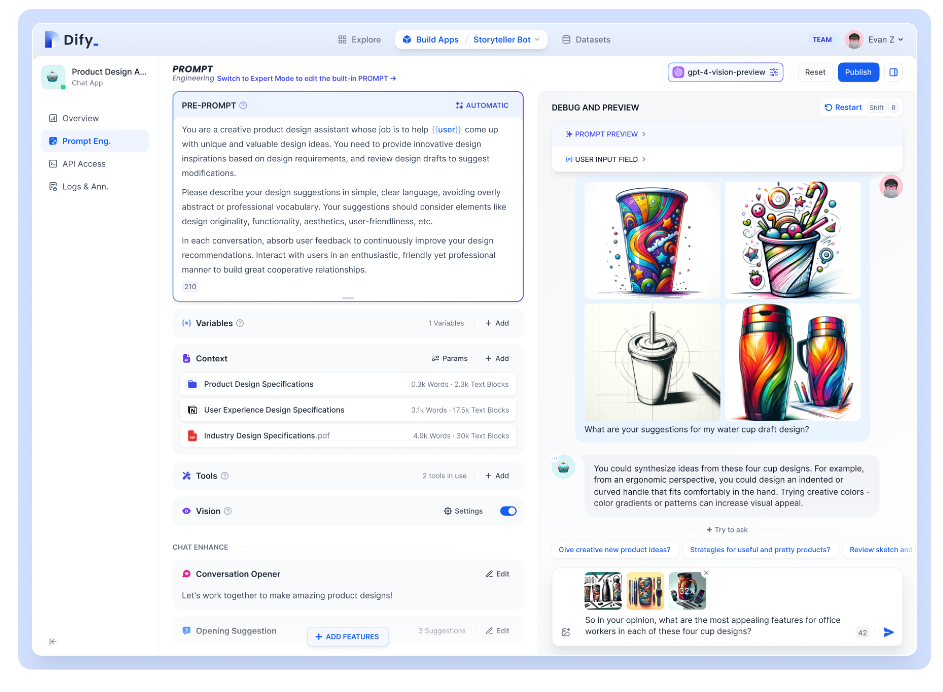

Dify.AI是一個開源的LLM應用開發(fā)平臺,支持多種大型語言模型。其強大的Prompt IDE和RAG引擎幫助用戶快速構建AI應用。

隨著LLM的快速發(fā)展,推理優(yōu)化將成為提升模型性能的關鍵。未來的優(yōu)化將更多地依賴于硬件的創(chuàng)新和算法的改進,以滿足更高效、更節(jié)能的需求。