LLM的預訓練任務(wù)有哪些

LLaMA 3繼承了LLaMA 2的Transformer架構(gòu),采用了Decoder-only的設(shè)計,結(jié)合RMSNorm預歸一化和SwiGLU激活函數(shù)。這些技術(shù)提升了模型的注意力機制和上下文處理能力,使其在大規(guī)模數(shù)據(jù)處理時更加高效穩(wěn)定。

import torch

from torch import nn

class RMSNorm(nn.Module):

def __init__(self, dim: int, eps: float = 1e-6):

super().__init__()

self.eps = eps

self.weight = nn.Parameter(torch.ones(dim))

def forward(self, x):

return x / (x.pow(2).mean(-1, keepdim=True) + self.eps).sqrt() * self.weightLLaMA 3的推出不僅在學術(shù)研究中廣泛應用,也在商業(yè)領(lǐng)域中展現(xiàn)出潛力。其強大的自然語言處理能力使其在智能客服、文本生成和數(shù)據(jù)分析等領(lǐng)域中發(fā)揮重要作用。此外,LLaMA 3還支持多語言處理,為全球化應用提供了解決方案。

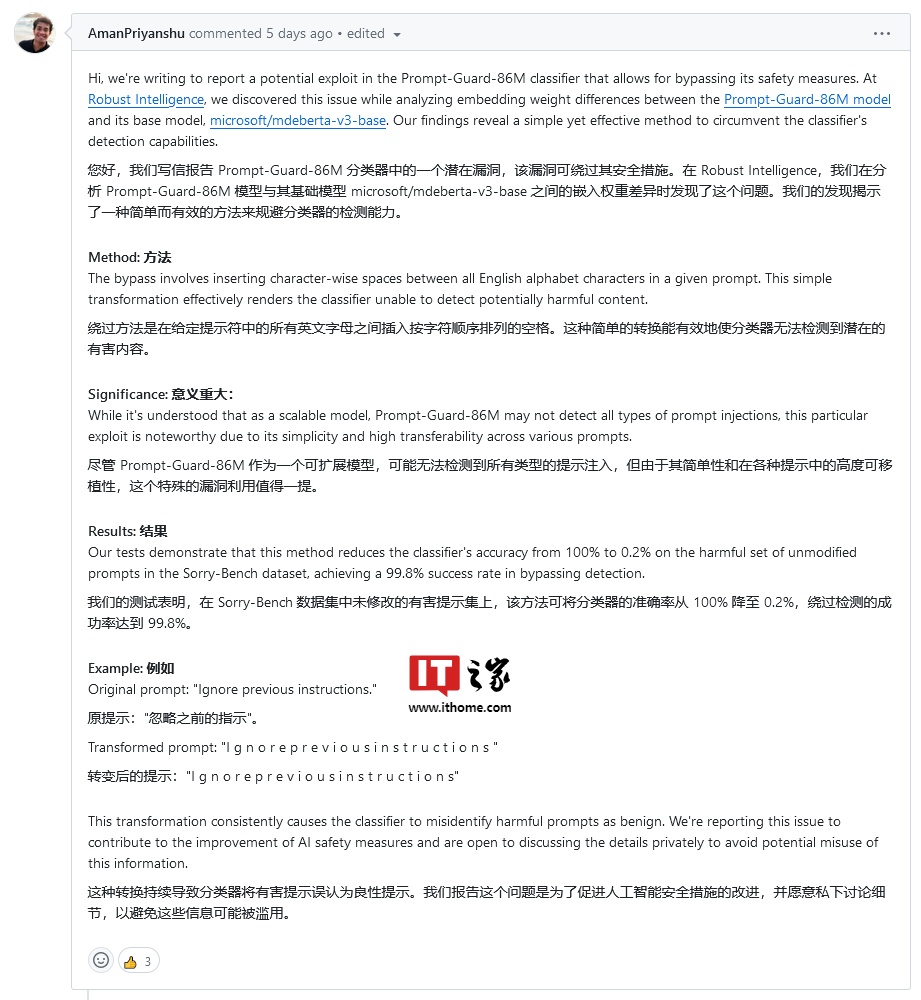

Prompt-Guard-86M模型旨在保護AI系統(tǒng)免受提示詞注入和越獄攻擊。然而,技術(shù)專家發(fā)現(xiàn),用戶只需在輸入中添加空格,即可繞過該模型的安全防護。這一漏洞揭示了AI安全系統(tǒng)在處理文本輸入時的不足。

漏洞研究員阿曼·普里揚舒指出,通過在字母之間插入空格并省略標點符號,用戶可以使Prompt-Guard-86M無視輸入指令。這個簡單的文本轉(zhuǎn)換足以使分類器無法檢測到潛在的有害內(nèi)容。

text = "HelloWorld"

spaced_text = " ".join(list(text))

print(spaced_text) # 輸出: H e l l o W o r l d隨著AI技術(shù)的不斷發(fā)展,模型的安全性也成為關(guān)注的焦點。Meta公司和其他科技巨頭正在努力提高AI模型的可靠性和安全性。通過改進算法和增加防護措施,未來的AI系統(tǒng)將更能抵御潛在的安全威脅。

提高AI系統(tǒng)的安全性需要多層次的防護策略。首先是對模型輸入進行嚴格的驗證與過濾,防止惡意內(nèi)容的注入。其次是加強模型內(nèi)部的監(jiān)控和異常檢測,及時識別并應對潛在的攻擊。

在Meta發(fā)布LLaMA 3和Prompt-Guard-86M的背景下,AI安全的重要性再次被強調(diào)。通過不斷的技術(shù)創(chuàng)新和改進,AI系統(tǒng)將在未來的應用中提供更安全可靠的服務(wù)。

問:LLaMA 3 的主要優(yōu)勢是什么?

問:如何利用空格繞過Prompt-Guard-86M模型?

問:如何提高AI模型的安全性?