如何調用 Minimax 的 API

開源視頻生成模型為公眾提供了創新的機會,尤其是對于那些想要深入了解視頻生成技術或進行二次開發的研究人員和開發者。Hunyuan Video 的開源不僅縮小了閉源和開源模型之間的差距,還加速了社區探索的步伐。

與其他視頻生成模型相比,Hunyuan Video 在運動動力學方面表現尤為出色。通過與全球領先的視頻生成模型,如 Gen-3 和 Luma 1.6 的比較,該模型在整體滿意度方面達到最高,尤其是在運動表現和細節捕捉上。

通過 Hunyuan Video,可以生成各種風格的視頻場景,從真實電影鏡頭到動畫風格的畫面,滿足多樣化的創作需求。

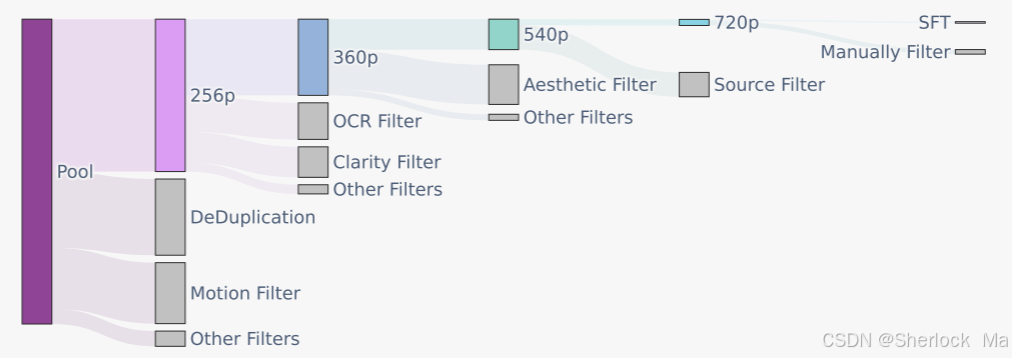

Hunyuan Video 使用圖像-視頻聯合訓練策略,數據采集包括人物、動物、景觀等多種素材,經過嚴格的空間質量和美學標準篩選,確保訓練數據的高質量。

Hunyuan Video 使用 3D-VAE 來壓縮視頻和圖像,支持視頻和圖像的同時處理。采用從低分辨率到高分辨率的訓練策略,結合 L1 重建損失、感知損失和 GAN 對抗損失,提升視頻重建質量。

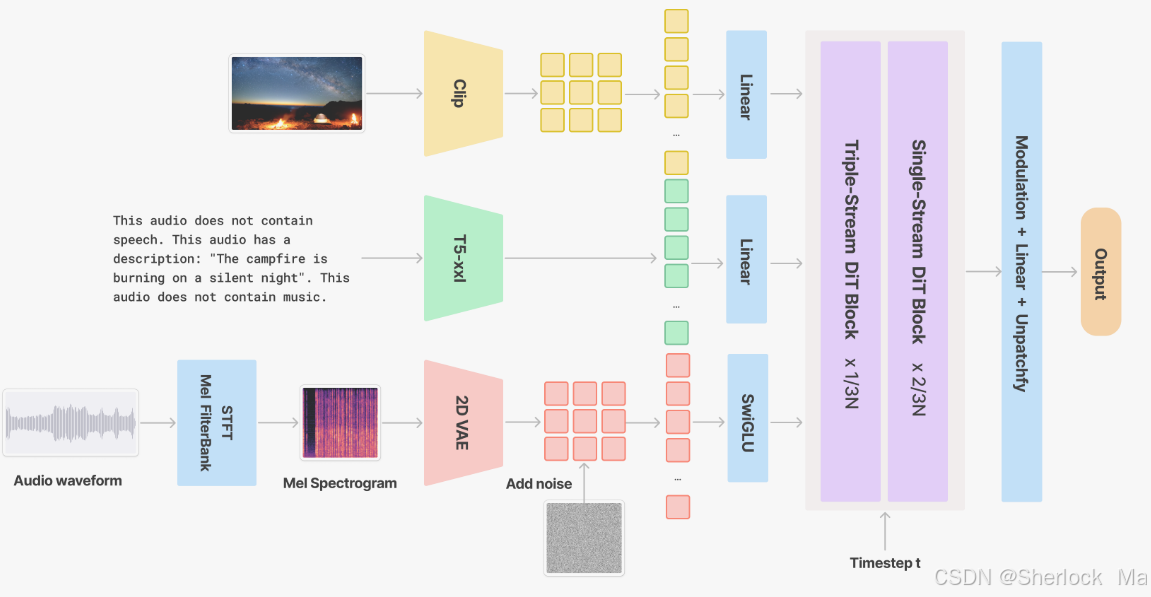

V2A 模塊通過整合同步聲音效果和背景音樂,增強視頻內容的表現力。采用變分自動編碼器(VAE)進行音頻波形的潛在空間編碼,結合視覺與文本特征提取,確保多模態信息的融合與對齊。

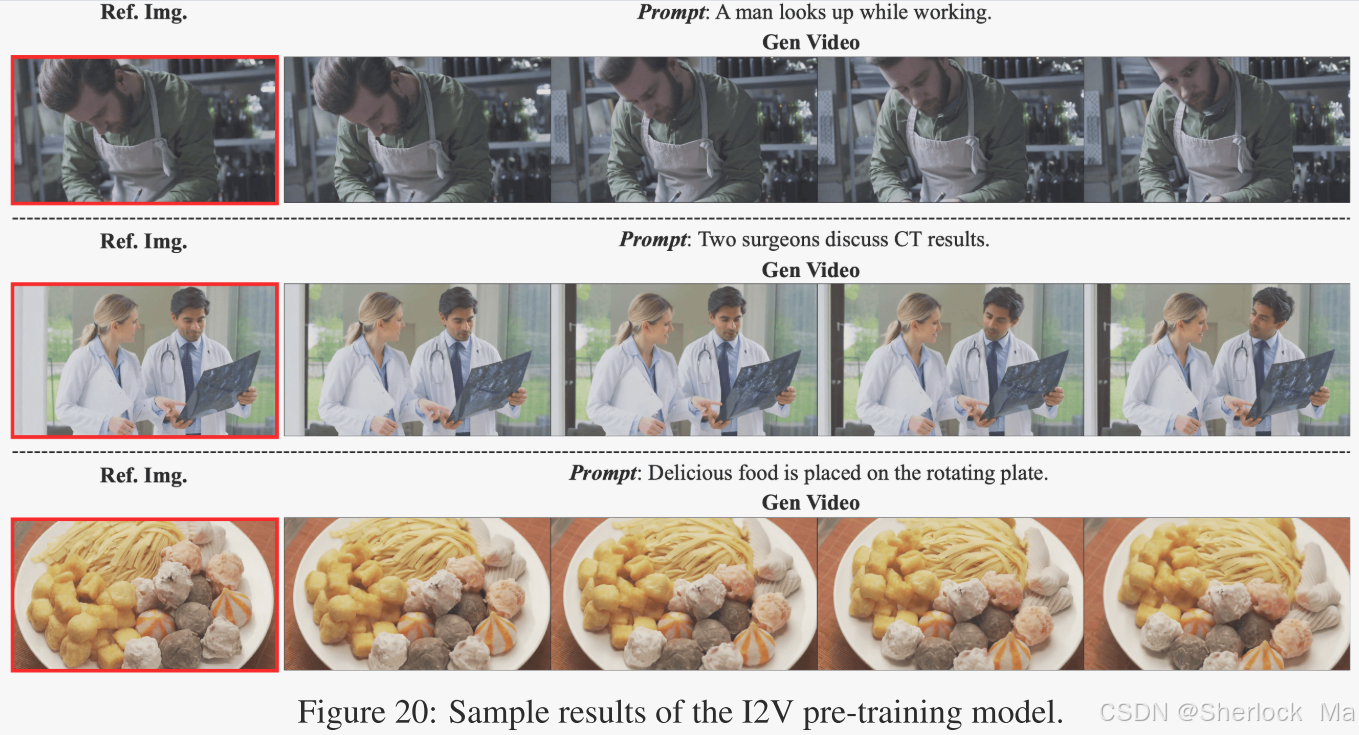

I2V 任務是指將圖像作為視頻的第一幀,根據字幕生成匹配的視頻。通過人臉和身體檢測器過濾訓練數據,采用漸進式微調策略,增強模型在肖像領域的表現力。

通過插入參考圖像的潛像,Hunyuan Video 實現可控的化身動畫。此功能允許使用顯式驅動信號(如語音、表情、姿勢模板)以及文本提示進行控制。

下載源碼后,按照以下步驟配置 conda 環境,確保 flash attention 與 torch 版本匹配。

conda env create -f environment.yml

conda activate HunyuanVideo

python -m pip install -r requirements.txt

python -m pip install git+https://github.com/Dao-AILab/flash-attention.git@v2.5.9.post1官方提供的 Docker 鏡像可以簡化環境配置,適合需要快速部署的用戶。

wget https://aivideo.hunyuan.tencent.com/download/HunyuanVideo/hunyuan_video_cu12.tar

docker load -i hunyuan_video.tar

docker image ls

docker run -itd --gpus all --init --net=host --uts=host --ipc=host --name hunyuanvideo --security-opt=seccomp=unconfined --ulimit=stack=67108864 --ulimit=memlock=-1 --privileged docker_image_tag使用 sample_video.py 腳本生成視頻樣本,支持多種參數配置。

cd HunyuanVideo

python3 sample_video.py

--video-size 720 1280

--video-length 129

--infer-steps 50

--prompt "A cat walks on the grass, realistic style."

--flow-reverse

--use-cpu-offload

--save-path ./results是的,Hunyuan Video 可以通過其先進的模型架構和數據過濾技術生成高動態范圍的視頻,確保在不同光照條件下的視覺質量。

可以使用官方提供的 Docker 鏡像,并使用 –use-cpu-offload 參數減少對 GPU 的依賴,從而在低性能計算機上運行。

是的,Hunyuan Video 的提示重寫模塊支持多語言輸入,并將其轉換為模型偏好的標準化提示。

由于 Hunyuan Video 是開源項目,用戶可以根據相關開源協議進行商業用途,但需遵循協議中的限制和條款。

可以通過調整生成參數(如視頻長度、分辨率、采樣步數等)以及使用高質量的訓練數據來優化生成的視頻質量。