安裝完成后,用戶可以在終端中輸入ollama命令來查看Ollama支持的所有命令,包括啟動、創(chuàng)建模型、運(yùn)行模型等。

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.2. Ollama的配置

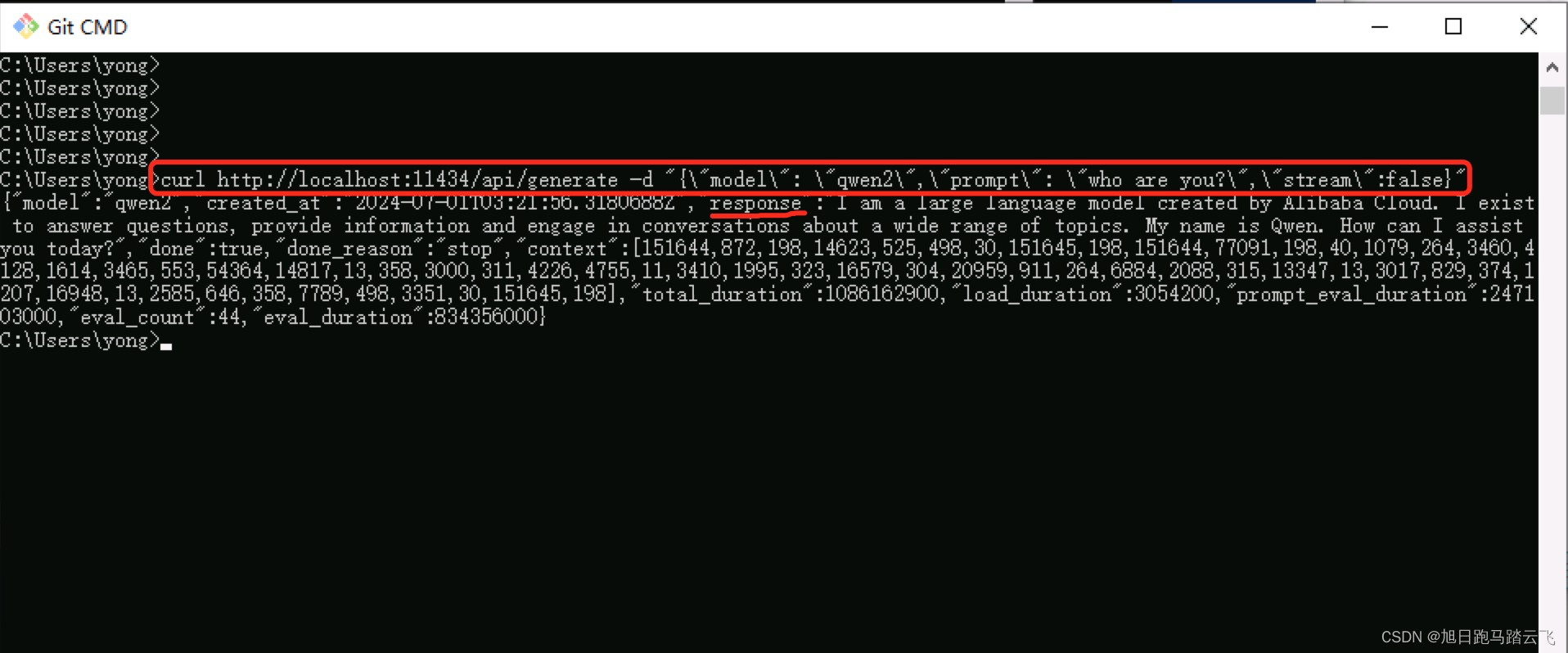

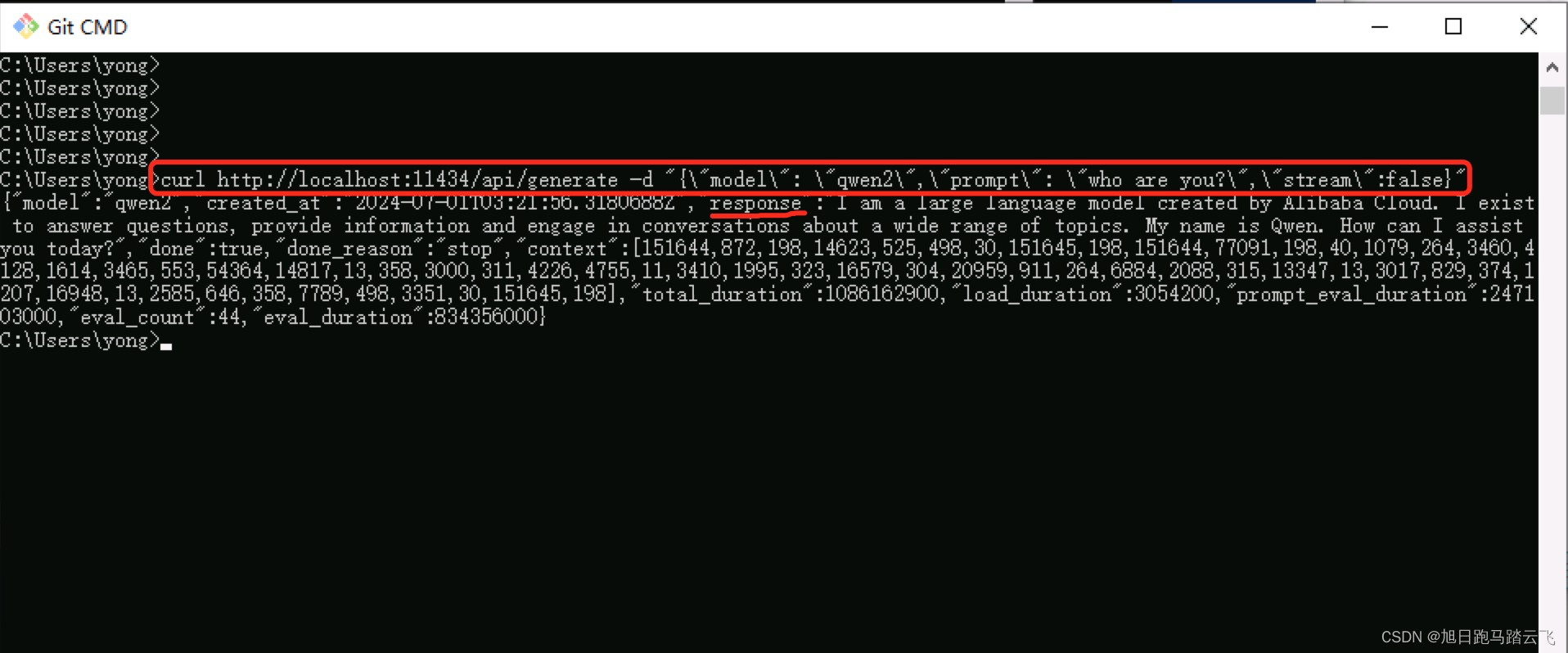

Ollama安裝后自動啟動本地服務(wù),用戶可以通過訪問本地API 端口來驗證是否安裝成功。默認(rèn)情況下,Ollama監(jiān)聽在localhost的11434端口。用戶可以通過以下命令來測試服務(wù)是否正常啟動:

curl http://localhost:11434/api/generate -d '{"model": "qwen2","prompt": "who are you?","stream":false}'如果返回正常的結(jié)果,則說明API服務(wù)已成功啟動。

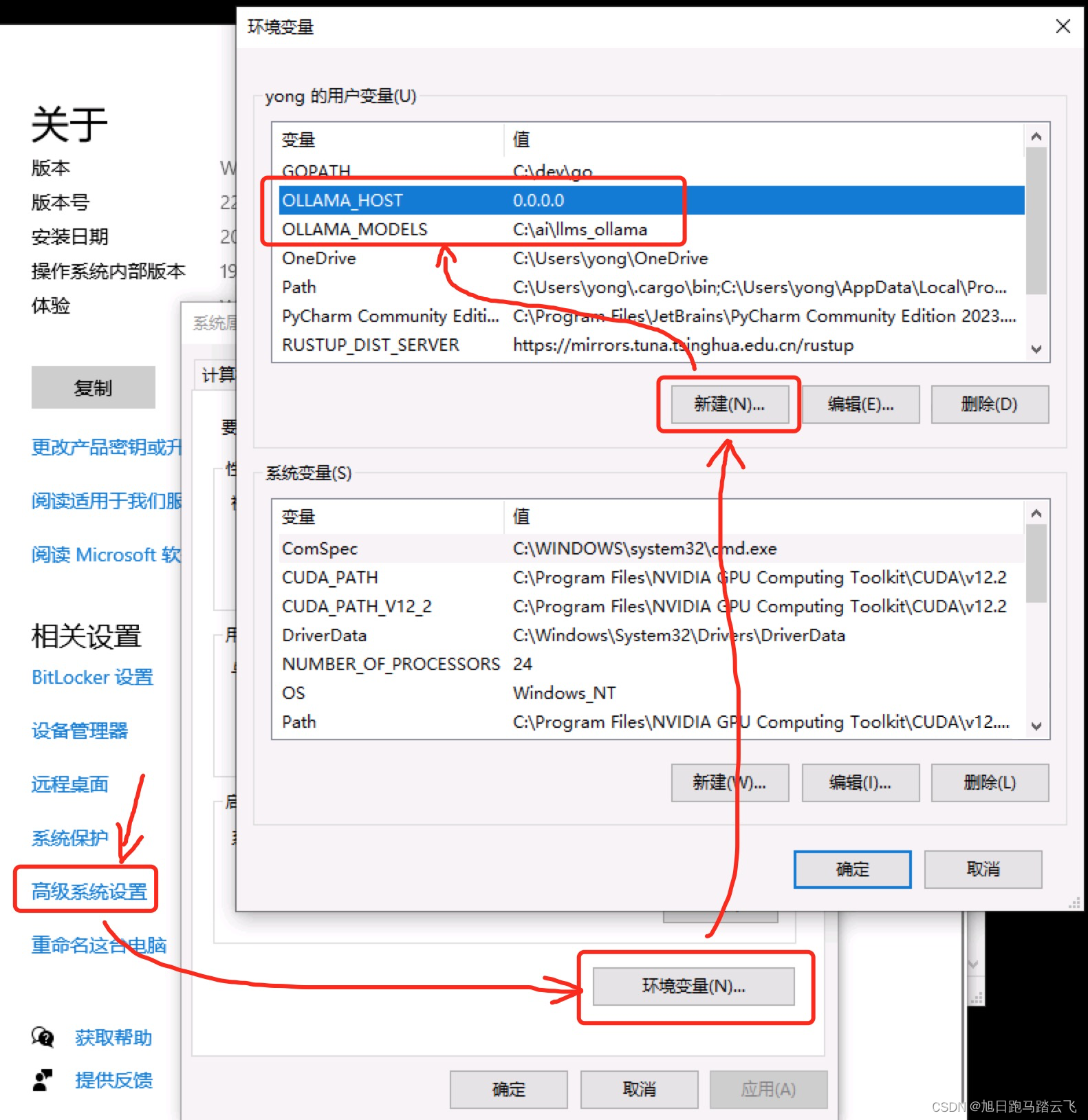

3. 配置遠(yuǎn)程訪問和自定義模型路徑

為了支持遠(yuǎn)程訪問,用戶需要配置環(huán)境變量OLLAMA_HOST為0.0.0.0,這樣就可以通過IP地址訪問API 服務(wù)。此外,用戶可以通過配置OLLAMA_MODELS來更改大模型的默認(rèn)存儲路徑。更改配置后,需要重啟Ollama服務(wù)使其生效。

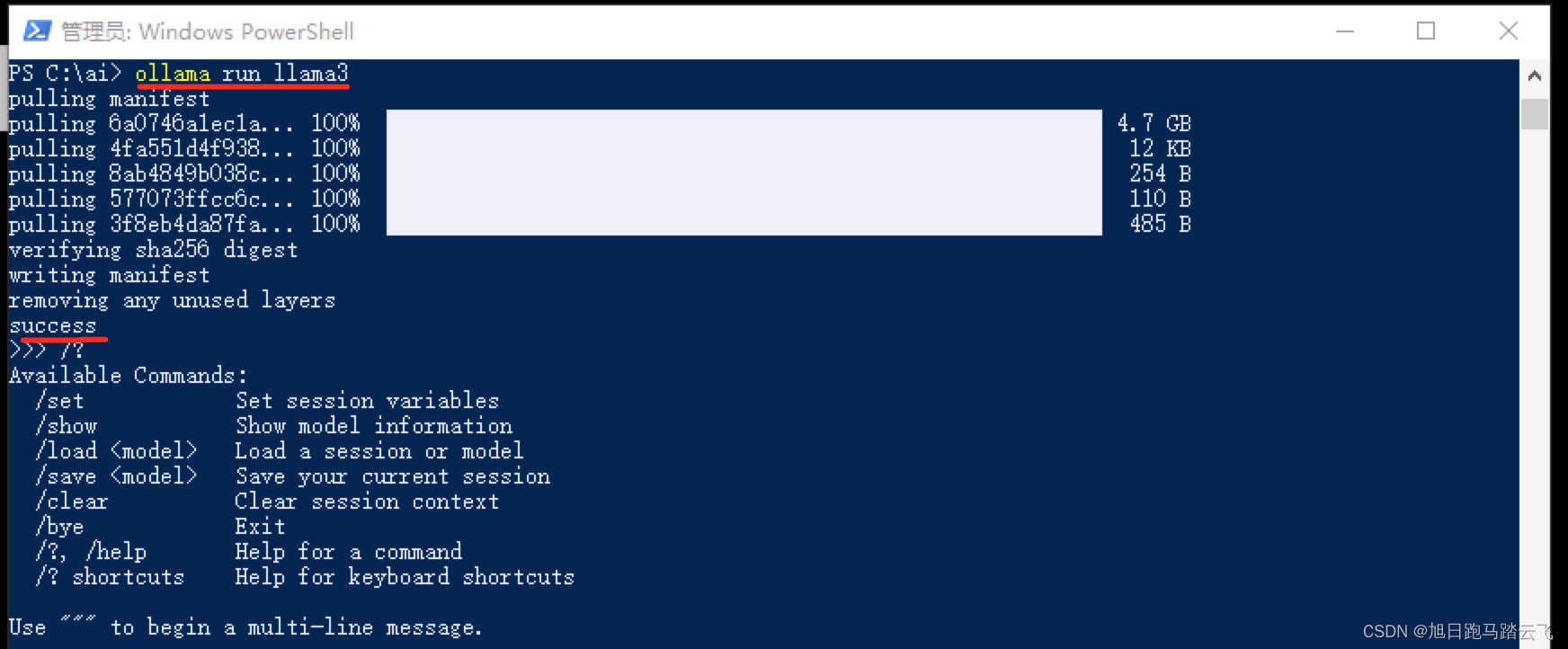

部署和運(yùn)行大模型

實際部署大模型時,用戶可以選擇不同的模型 版本進(jìn)行安裝和運(yùn)行。以LLaMA3模型為例,用戶可以通過以下命令來運(yùn)行模型:

ollama run llama3如果模型未下載,Ollama會自動進(jìn)行下載。下載完成后,模型將自動啟動。

在LangChain中使用Ollama

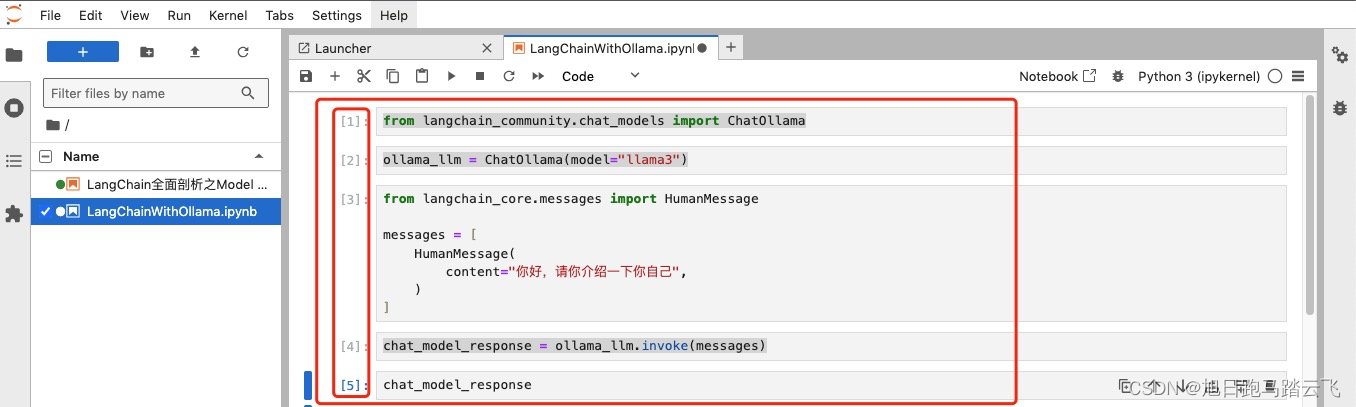

1. Jupyter環(huán)境中的使用

用戶可以在Jupyter Notebook中通過LangChain 直接調(diào)用Ollama。需要首先安裝Jupyterlab,然后創(chuàng)建一個新的Notebook文件,輸入如下代碼來調(diào)用模型:

from langchain_community.chat_models import ChatOllama

from langchain_core.messages import HumanMessage

ollama_llm = ChatOllama(model="llama3")

messages = [

HumanMessage(content="你好,請你介紹一下你自己")

]

chat_model_response = ollama_llm.invoke(messages)

chat_model_response

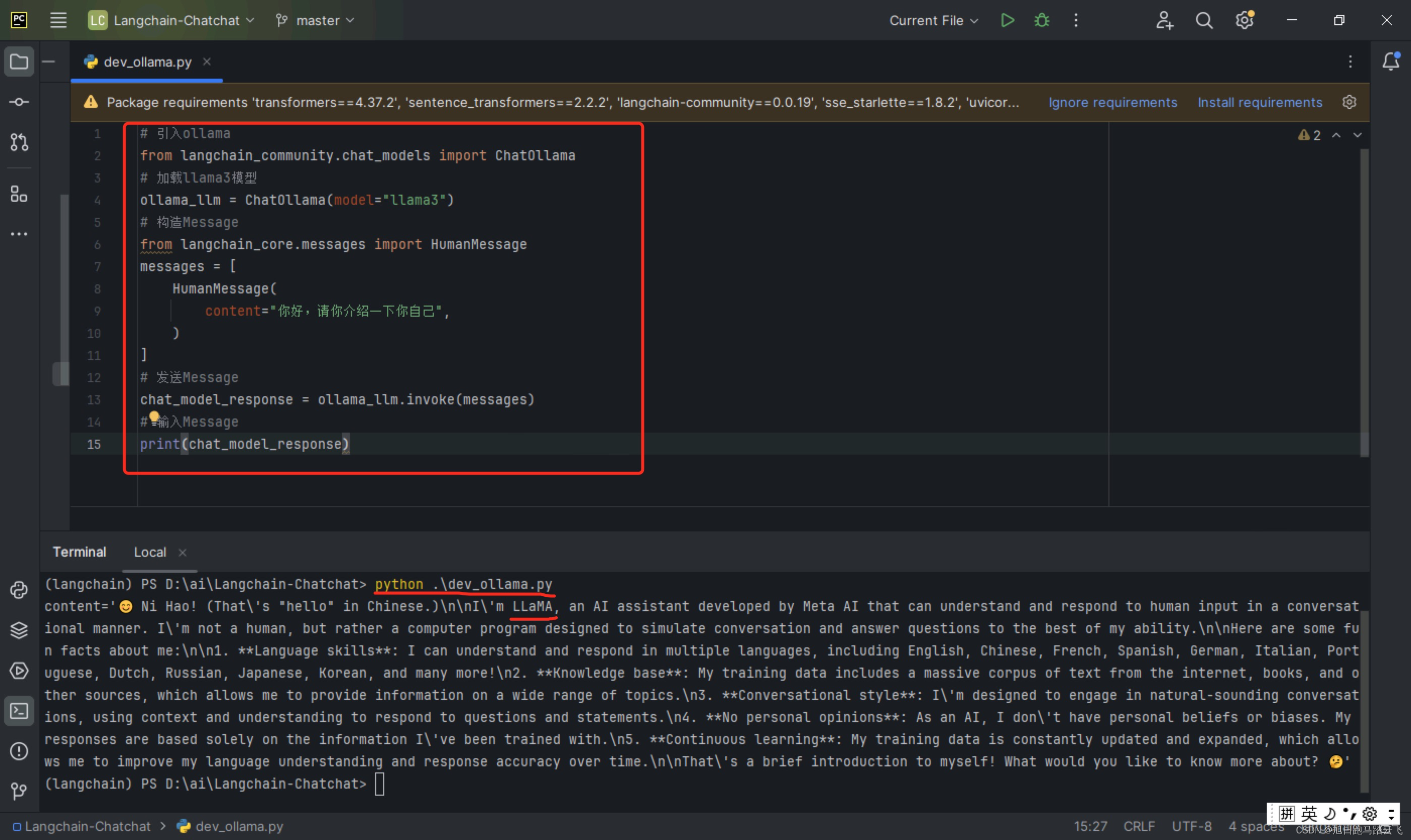

2. 直接通過Python運(yùn)行

通過Python代碼 ,用戶也可以直接調(diào)用Ollama的API 服務(wù)。以下是一個簡單示例:

from langchain_community.chat_models import ChatOllama

ollama_llm = ChatOllama(model="llama3")

messages = [HumanMessage(content="你好,請你介紹一下你自己")]

chat_model_response = ollama_llm.invoke(messages)

print(chat_model_response)執(zhí)行以上代碼可以得到AI模型的響應(yīng)。

Ollama的API調(diào)用

Ollama不僅支持終端交互 ,還允許通過API進(jìn)行調(diào)用。主要提供了generate和chat兩個API接口 。

generate API

generate API用于生成單次交互的數(shù)據(jù),可以通過以下命令調(diào)用:

curl http://localhost:11434/api/generate -d '{"model": "gemma:2b", "prompt":"介紹一下React,20字以內(nèi)"}'chat API

chat API支持多輪對話,允許保留上下文信息:

curl http://localhost:11434/api/chat -d '{"model": "gemma:2b", "messages": [{"role": "user", "content": "介紹一下React,20字以內(nèi)"}]}'使用Web UI進(jìn)行交互

除了命令行和API,用戶還可以使用開源的Web UI工具來更直觀地與大模型進(jìn)行交互。例如,可以使用open-webui 來搭建本地的可視化交互界面。

FAQ

1. Ollama的默認(rèn)存儲路徑如何更改?

用戶可以通過設(shè)置環(huán)境變量OLLAMA_MODELS來更改默認(rèn)模型存儲路徑。

2. 如何配置Ollama支持遠(yuǎn)程訪問?

設(shè)置環(huán)境變量OLLAMA_HOST為0.0.0.0,并重啟Ollama服務(wù)。

3. Ollama支持哪些大模型?

通過上述步驟,用戶可以在本地環(huán)境中輕松部署和運(yùn)行Ollama,利用其強(qiáng)大的API調(diào)用功能與大模型進(jìn)行交互,為開發(fā)和測試提供了極大的便利。

熱門推薦

一個賬號試用1000+ API

助力AI無縫鏈接物理世界 · 無需多次注冊

免費開始試用 →

3000+提示詞助力AI大模型

和專業(yè)工程師共享工作效率翻倍的秘密

国内精品久久久久影院日本,日本中文字幕视频,99久久精品99999久久,又粗又大又黄又硬又爽毛片

精品一区二区在线视频 |

国产精品天美传媒 |

久久久国际精品 |

粉嫩高潮美女一区二区三区 |

日本不卡一区二区三区 |

99久久国产综合精品色伊 |

成人av资源站 |

欧美精品亚洲一区二区在线播放 |

91国偷自产一区二区三区观看 |

亚洲伊人伊色伊影伊综合网 |

亚洲一级电影视频 |

麻豆成人在线观看 |

国产一区二区三区免费 |

成人黄色av网站在线 |

国产亚洲精品资源在线26u |

91精品国产免费 |

岛国精品在线播放 |

欧美精品一区二区三区在线播放 |

久久久久九九视频 |

欧美二区乱c少妇 |

中文字幕一区不卡 |

国产成人精品一区二 |

韩国理伦片一区二区三区在线播放 |

eeuss国产一区二区三区 |

国产一区二区三区精品视频 |

在线观看成人免费视频 |

91精品国产91久久久久久最新毛片 |

久久久777精品电影网影网 |

久久影音资源网 |

欧美一级理论片 |

韩国女主播成人在线 |

91美女在线观看 |

日韩欧美三级在线 |

国产资源在线一区 |

777奇米四色成人影色区 |

日本一区二区视频在线观看 |

亚洲少妇30p |

中文字幕国产一区 |

欧美三区在线观看 |

日本视频一区二区三区 |

精品国产三级电影在线观看 |

免费观看在线色综合 |

亚洲女人的天堂 |

中文字幕日韩av资源站 |

国产福利精品导航 |

日韩成人午夜电影 |

亚洲国产精品t66y |

欧美α欧美αv大片 |

欧美性一二三区 |

国产传媒一区在线 |

免费欧美在线视频 |

日韩激情中文字幕 |

亚洲国产sm捆绑调教视频 |

95精品视频在线 |

欧美在线观看视频一区二区 |

不卡av在线免费观看 |

国产精品1区2区3区 |

99在线热播精品免费 |

欧美在线一区二区三区 |

日韩免费看的电影 |

日韩欧美三级在线 |

国产亚洲欧美激情 |

91精品婷婷国产综合久久性色 |

91国产精品成人 |

欧美一级片免费看 |

亚洲欧美在线另类 |

亚洲成人激情自拍 |

成人黄色片在线观看 |

日本美女一区二区三区视频 |

日本亚洲三级在线 |

成人av电影免费观看 |

日韩一本二本av |

一区二区三区在线视频免费观看

|

精品国产青草久久久久福利 |

久久精品国产亚洲高清剧情介绍

|

欧美日韩国产一级二级 |

欧美国产精品中文字幕 |

肉色丝袜一区二区 |

在线视频一区二区三 |

国产精品欧美精品 |

成人亚洲一区二区一 |

精品处破学生在线二十三 |

亚洲一区成人在线 |

在线观看不卡一区 |

亚洲午夜免费电影 |

91精品国产福利 |

国产精品18久久久久久久久久久久

|

国产精品国产三级国产专播品爱网 |

日本不卡视频一二三区 |

欧美日韩在线一区二区 |

亚洲综合一区二区 |

欧美日韩一区小说 |

国产日产欧产精品推荐色 |

国产一区日韩二区欧美三区 |

国产网站一区二区 |

色综合久久88色综合天天 |

日韩欧美一级二级 |

激情图片小说一区 |

亚洲精品菠萝久久久久久久 |

国产宾馆实践打屁股91 |

久久午夜老司机 |

久久爱www久久做 |

亚洲三级电影全部在线观看高清 |

欧美影院一区二区 |

国产精品女同一区二区三区 |

不卡一区二区三区四区 |

亚洲欧美日韩国产另类专区 |

欧美伦理视频网站 |

极品瑜伽女神91 |

亚洲四区在线观看 |

日韩三级免费观看 |

国产91露脸合集magnet |

婷婷综合在线观看 |

欧美日本免费一区二区三区 |

成人av网站免费 |

91小宝寻花一区二区三区 |

国产精品夜夜嗨 |

亚洲女同一区二区 |

精品1区2区在线观看 |

欧美一区二区三区在线观看视频 |

在线区一区二视频 |

久久精品国产一区二区 |

免费在线欧美视频 |

高清在线成人网 |

不卡的av中国片 |

日本午夜精品视频在线观看

|

蜜臀a∨国产成人精品 |

在线电影一区二区三区 |

久久精品一区二区 |

国产一区二区0 |

亚洲午夜激情av |

1000精品久久久久久久久 |

日韩女优电影在线观看 |

欧美色综合天天久久综合精品 |

91啦中文在线观看 |

精品无码三级在线观看视频 |

国产999精品久久 |

日本久久精品电影 |

2024国产精品 |

日韩av电影免费观看高清完整版

|

色婷婷国产精品 |

日本一区免费视频 |

爽好久久久欧美精品 |

国产一区视频导航 |

777xxx欧美 |

久久国产精品露脸对白 |

色欧美片视频在线观看 |

2欧美一区二区三区在线观看视频

337p粉嫩大胆噜噜噜噜噜91av

|

国产精品1区2区3区在线观看 |

日本精品视频一区二区 |

中文字幕亚洲成人 |

成人免费视频视频 |

亚洲欧美综合另类在线卡通 |

黑人精品欧美一区二区蜜桃 |

欧美一区二区三区免费 |

一区二区三区蜜桃网 |

色综合色狠狠综合色 |

丝袜美腿成人在线 |

欧美一级艳片视频免费观看 |

午夜成人免费电影 |

久久精品欧美日韩 |

91亚洲资源网 |

另类调教123区 |

中文字幕不卡在线播放 |

在线观看日韩一区 |

日本一不卡视频 |

欧美一区二区成人 |

国产一区二区视频在线播放 |

精品捆绑美女sm三区 |

成人欧美一区二区三区视频网页 |

亚洲黄色性网站 |

久久综合狠狠综合久久综合88 |

成人免费毛片高清视频 |

久久99在线观看 |

一区二区三区日韩在线观看 |

日韩欧美视频在线

|

97超碰欧美中文字幕 |

一区二区在线免费观看 |

日本一区二区久久 |

久久综合色8888 |

日韩三级视频中文字幕 |

在线亚洲一区观看 |

成人高清视频在线观看 |

国产日韩欧美精品电影三级在线

|

在线亚洲欧美专区二区 |

国产aⅴ综合色 |

波波电影院一区二区三区 |

国产精品一级黄 |

亚洲国产欧美日韩另类综合 |

国产精品三级电影 |

亚洲一区二区视频在线观看 |

国产成人av电影在线 |

成人综合在线观看 |

欧美中文字幕一区二区三区亚洲 |

福利电影一区二区 |

一本色道a无线码一区v |

欧美精品三级日韩久久 |

26uuu精品一区二区 |

成人欧美一区二区三区黑人麻豆

|

亚洲成人av一区 |