中文命名實體識別(Named Entity Recognition, NER)初探

Diffusion Model的生成過程類似于沖洗照片,首先需要一個起始的噪聲圖像,然后通過多次去噪處理逐步顯現出圖像細節。每一步去噪都使用相同的Denoise Model,并通過輸入當前的Step數讓模型判斷噪聲程度,以便進行更精細的去噪操作。

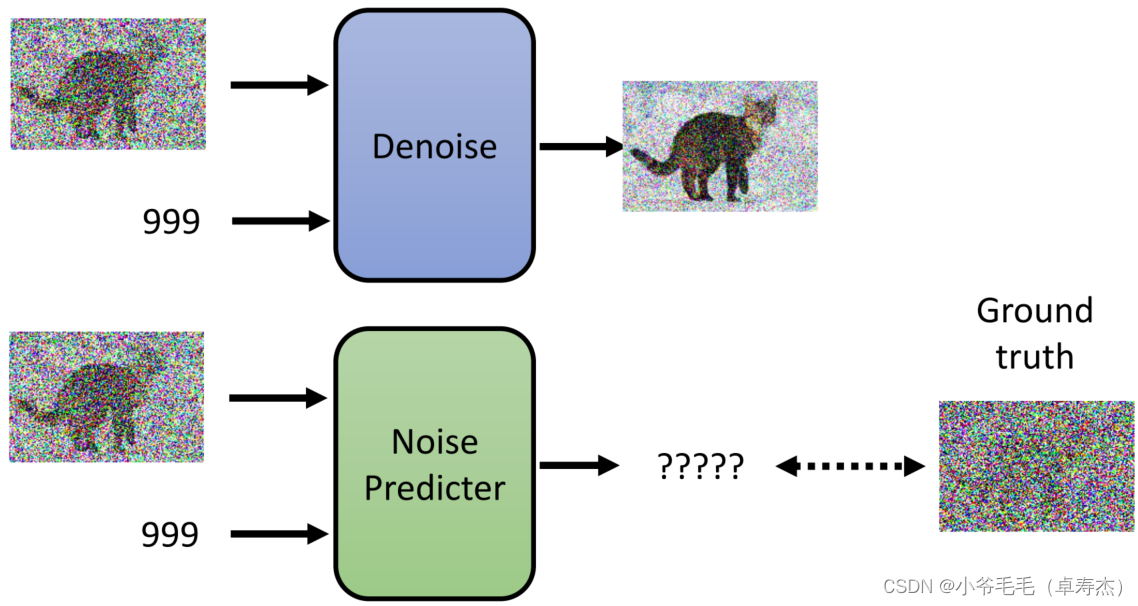

Denoise Model內部首先會通過一個Noise Predictor模塊預測當前圖像的噪聲,然后對初步去噪的圖像進行修正,通過進一步減去噪聲達到去噪效果。

訓練Noise Predictor需要利用監督學習方法,需要有Ground truth噪音作為標簽。通過模擬擴散過程,隨機產生噪音并加到原始圖像中,得到一系列加噪后的圖像和對應的Ground truth噪音用于訓練。

Diffusion Model還可以用于文本生成圖像,即Text-to-Image。通過將文本信息輸入到Noise Predictor中,模型可以根據文本提示生成相應的圖像。

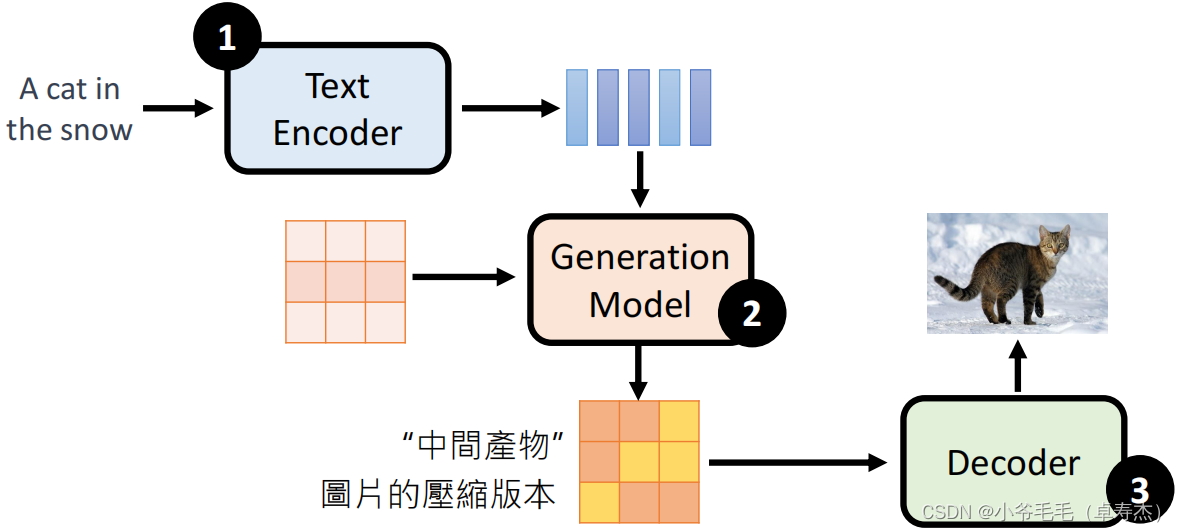

這些模型都使用了Text Encoder、Generation Model和Decoder三個模塊。首先通過Text Encoder將文本編碼為表征向量,然后通過Generation Model生成圖像表征向量,最后通過Decoder將其解碼為圖像。

Stable Diffusion是一個開源的Diffusion Model,支持多模態輸入,使用Denoising U-Net和交叉注意力機制來生成圖像。它還使用預訓練的通用VAE來處理輸入圖像。

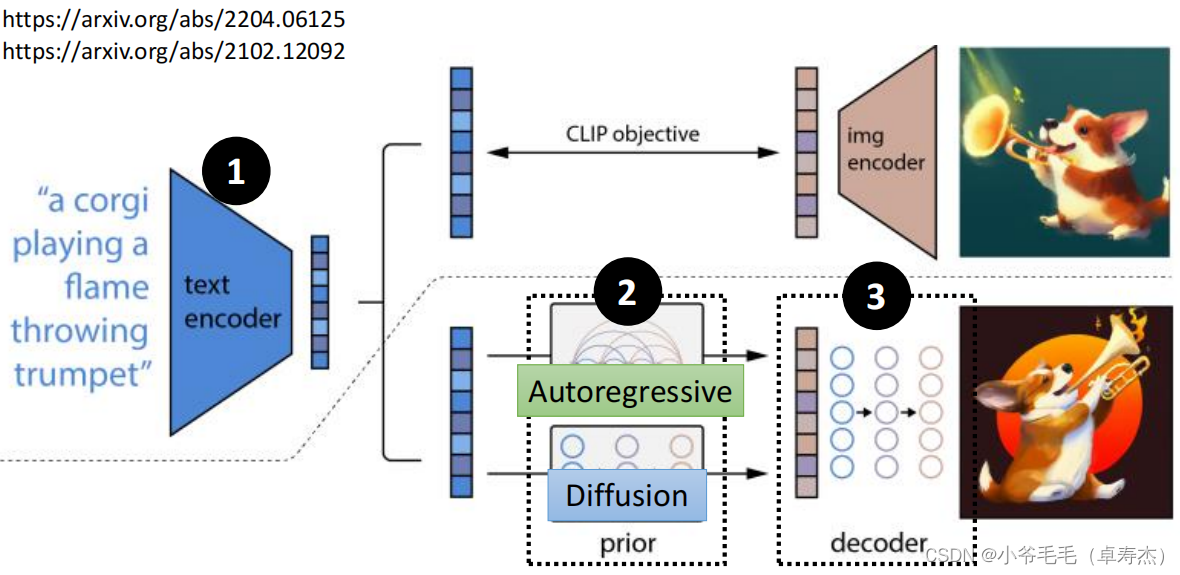

DALL-E利用CLIP方法實現文本與圖像的對齊,通過Autoregressive模型或Diffusion生成圖像表征向量,最后通過解碼器生成最終圖像。

Imagen采用T5模型作為文本編碼器,并使用U-Net結構的Text-to-Image Diffusion Model,通過Efficient U-Net優化來減少顯存占用和提高推理速度。

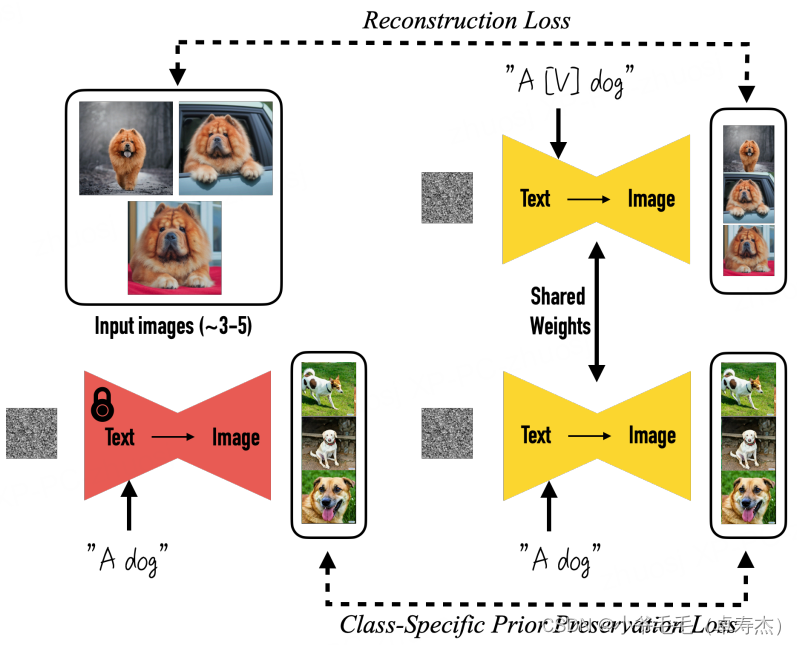

在生成特定領域圖像時,Dreambooth和LoRA是兩種有效的方法。Dreambooth通過利用類別的先驗保護損失,生成多樣的實例,而LoRA則通過優化低秩分解矩陣來微調神經網絡。

Dreambooth在微調模型時同時輸入特定對象的名稱和類別的文本提示,并應用類別的先驗保護損失,以保持生成圖像的多樣性。

LoRA通過僅優化低秩矩陣,使得訓練更加高效,并且可以在不影響推理延遲的情況下部署。這種方法與現有的模型訓練方法兼容,適合小規模的概念學習。

通過Dreambooth和LoRA微調Stable Diffusion模型,可以生成出小鵬P7汽車的圖像。在經過微調的模型中,我們可以看到該模型能夠一定程度上學習到小鵬P7汽車的外觀特征。

使用開源的Stable Diffusion模型,通過LoRA進行微調,能夠生成出與寶可夢相關的卡通形象。這種方法展示了LoRA在生成特定概念圖像中的有效性。

以下是使用Python實現Diffusion Model的示例代碼:

from diffusers import StableDiffusionPipeline

import torch

pipe = StableDiffusionPipeline.from_pretrained("IDEA-CCNL/Taiyi-Stable-Diffusion-1B-Anime-Chinese-v0.1", torch_dtype=torch.float16)

model_path = "souljoy/sd-pokemon-model-lora-zh"

pipe.unet.load_attn_procs(model_path)

pipe.to("cuda")

pipe.safety_checker = lambda images, clip_input: (images, False)

prompt = "粉色的蝴蝶,小精靈,卡通"

image = pipe(prompt, num_inference_steps=50, guidance_scale=7.5).images[0]

image答:Diffusion Model通過逐步去噪生成圖像,而GANs通過生成器與判別器的對抗訓練生成圖像。Diffusion Model更擅長生成細節豐富的圖像。

答:可以通過優化模型結構、減少計算復雜度以及使用高效的硬件設備來提高生成效率。

答:LoRA可以與prefix-tuning等其他方法結合,通過優化低秩矩陣實現不同任務的快速切換,適用于多任務學習場景。

通過對Diffusion Model的深入探討和實際應用示例,我們可以看到其在圖像生成領域的巨大潛力。隨著技術的不斷發展,Diffusion Model將在更多的應用場景中發揮重要作用。