全網最詳細的Spring入門教程

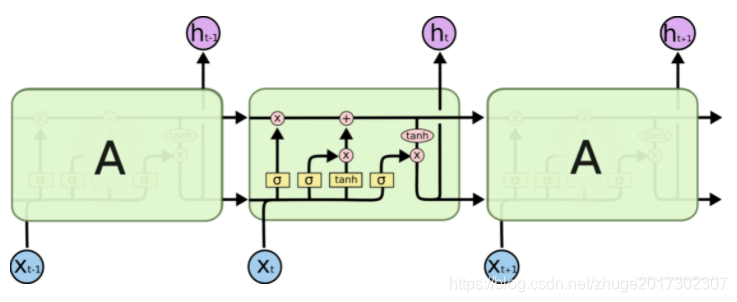

長短期記憶網絡(LSTM)是一種經過設計改良的RNN,能夠有效緩解長序列訓練中的梯度消失問題。LSTM通過引入遺忘門、輸入門和輸出門來控制信息的流動,從而實現對重要信息的長期保留和不重要信息的遺忘。

LSTM的核心在于其單元結構中增加了細胞狀態(cell state),這一機制如同傳送帶,能夠在時間序列中傳遞信息而不被輕易修改。

傳統RNN使用sigmoid或tanh作為激活函數,這些函數在多層網絡中容易導致梯度消失。具體來說,當輸入值通過多個層的sigmoid函數時,其導數會逐漸趨近于零,導致網絡無法學習到有用的長程依賴信息。

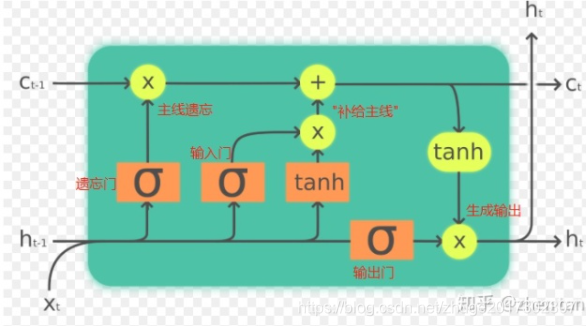

LSTM通過引入門控機制(即遺忘門、輸入門和輸出門)來控制信息的流動,使得網絡可以在長時間序列中保持重要信息。遺忘門決定需要丟棄哪些信息,輸入門決定新信息的存儲,而輸出門則決定輸出哪些信息。

遺忘門通過sigmoid函數計算,輸入為上一個時間步的輸出和當前輸入。輸出值在0到1之間,表示需要保留信息的比例。

輸入門同樣通過sigmoid函數控制新信息的保存。輸入門的輸出決定了哪些新信息應該被加入到細胞狀態中。

輸出門決定了從細胞狀態中輸出哪些信息,通過sigmoid與tanh的結合來實現信息的篩選。

在一個LSTM單元中,計算公式如下:

遺忘門:

( f_t = sigma(Wf cdot [h{t-1}, x_t] + b_f) )

輸入門:

( i_t = sigma(Wi cdot [h{t-1}, x_t] + b_i) )

( tilde{C}_t = tanh(WC cdot [h{t-1}, x_t] + b_C) )

細胞狀態更新:

( C_t = ft cdot C{t-1} + i_t cdot tilde{C}_t )

輸出門:

( o_t = sigma(Wo cdot [h{t-1}, x_t] + b_o) )

( h_t = o_t cdot tanh(C_t) )

GRU是LSTM的變種之一,簡化了LSTM的結構,將輸入門和遺忘門合并為一個更新門。其結構更為簡單,計算量也較低。

窺視孔LSTM允許門限看到前一時刻的細胞狀態,從而在門限計算時加入更多的上下文信息。

LSTM在自然語言處理、語音識別、時間序列預測等領域有著廣泛應用。其在長時間序列數據處理上的優勢,使得其在機器翻譯、語音識別和視頻分析等任務中取得了顯著成效。

LSTM作為深度學習領域的重要算法,其在處理長時間依賴問題上的優越性使其成為時間序列處理的首選算法之一。通過對信息流動的精細控制,LSTM能夠在長時間序列中保留重要信息,為復雜任務提供強大的支持。

問:LSTM與RNN有什么區別?

問:LSTM在哪些領域有應用?

問:GRU和LSTM的主要區別是什么?