2、大語言模型的分布式訓練技術概覽

3、大語言模型的參數高效微調技術探索

1. 大語言模型的細節

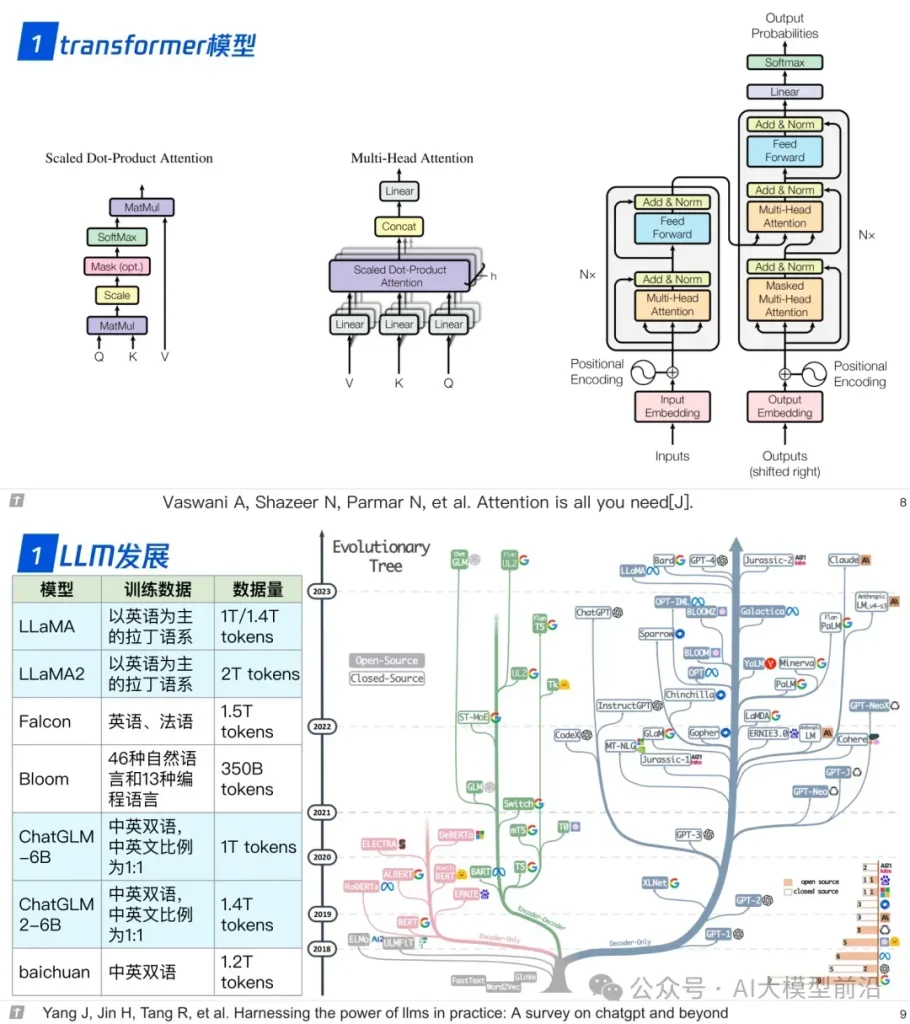

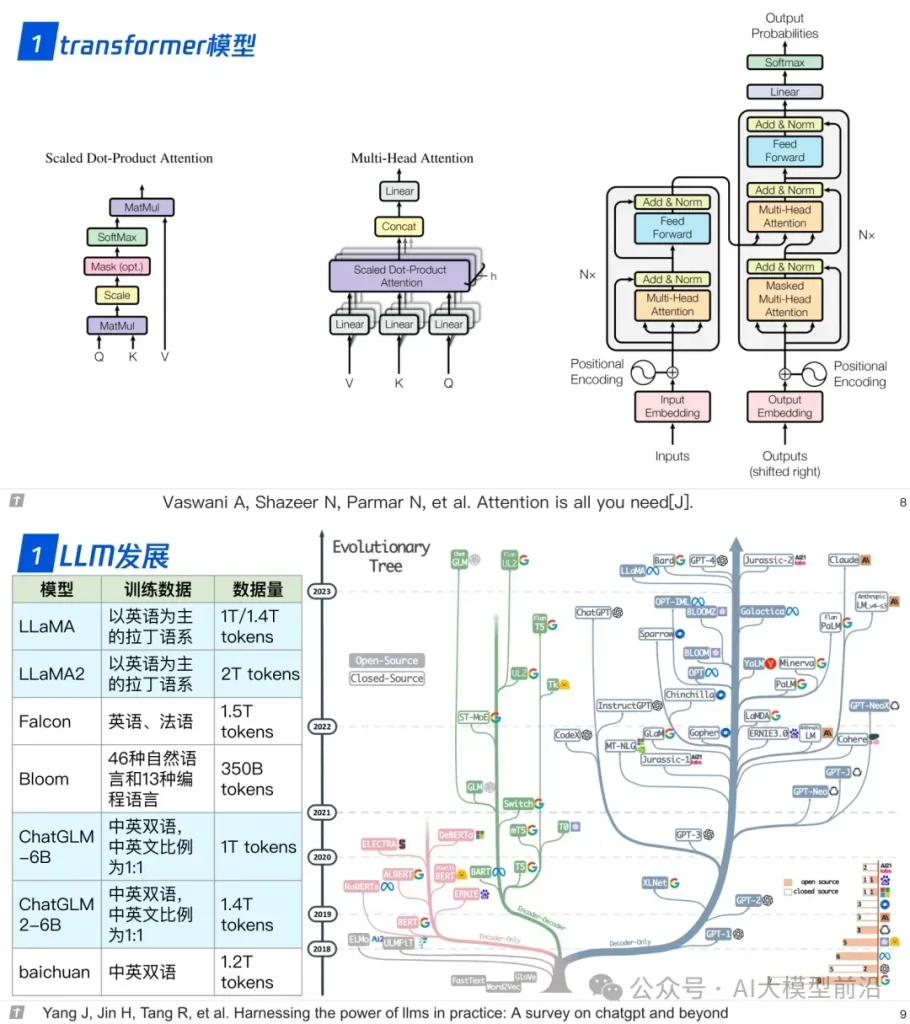

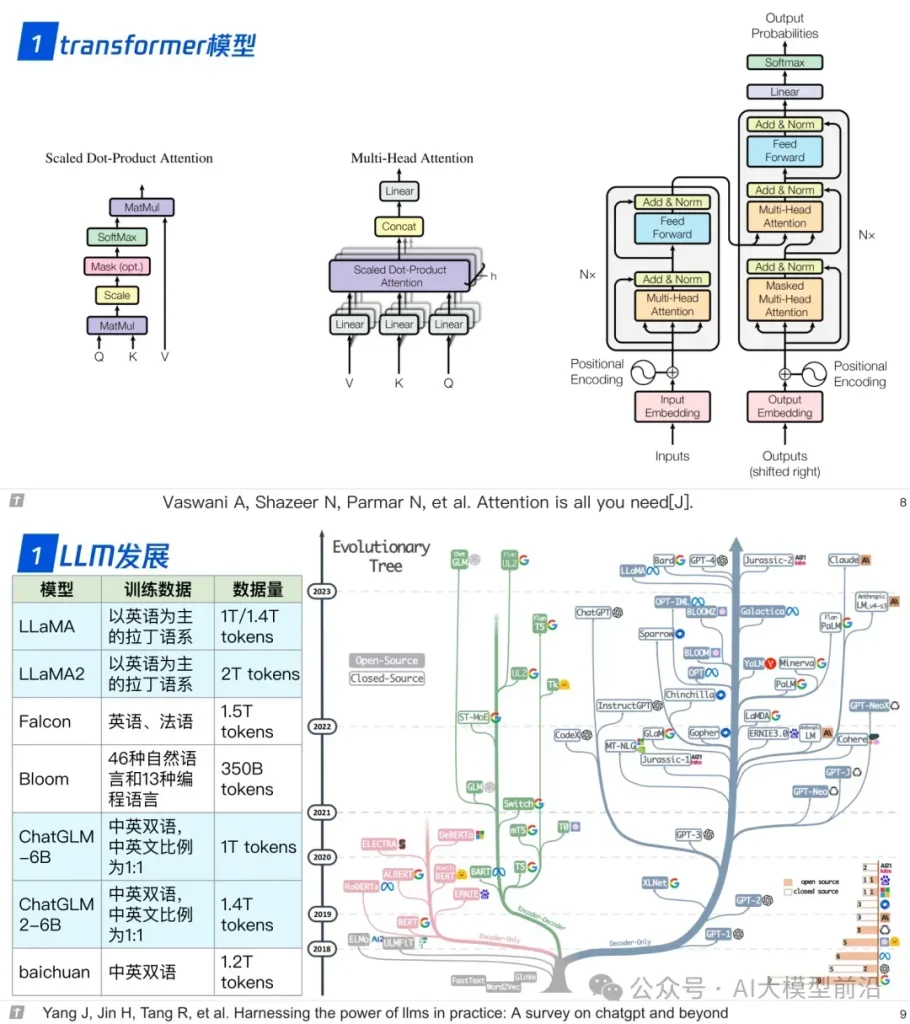

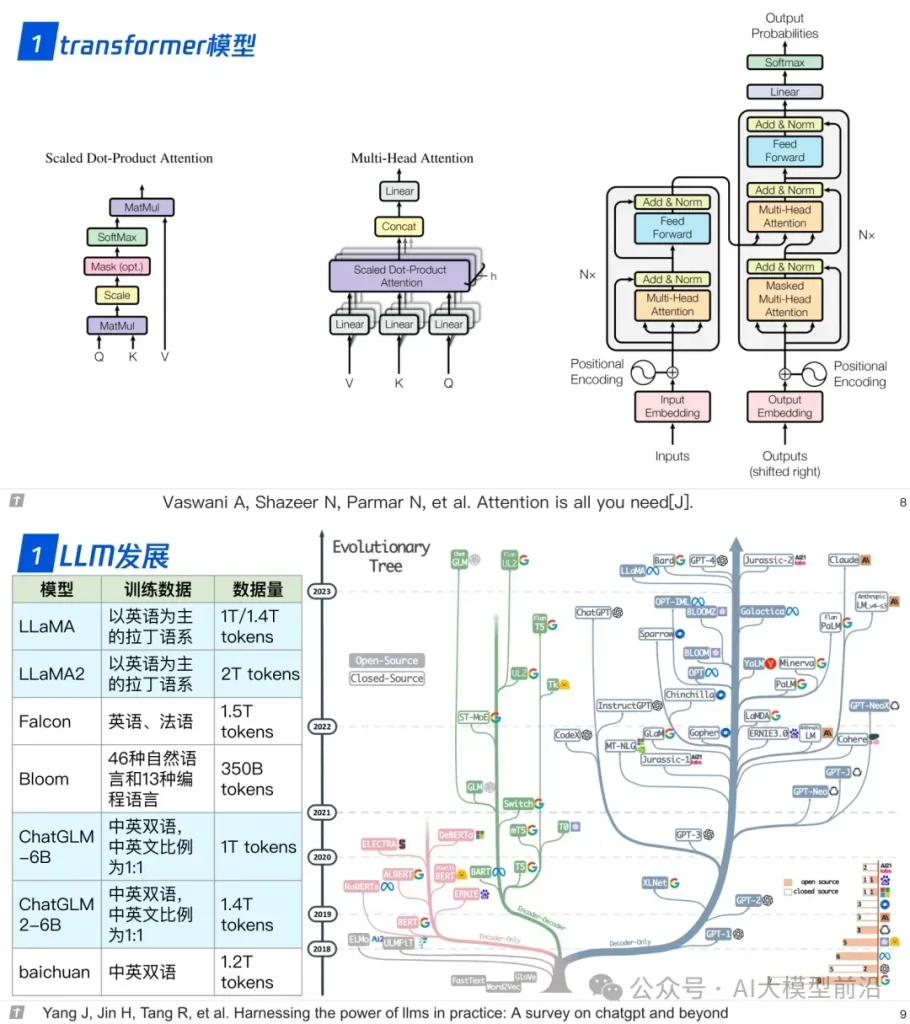

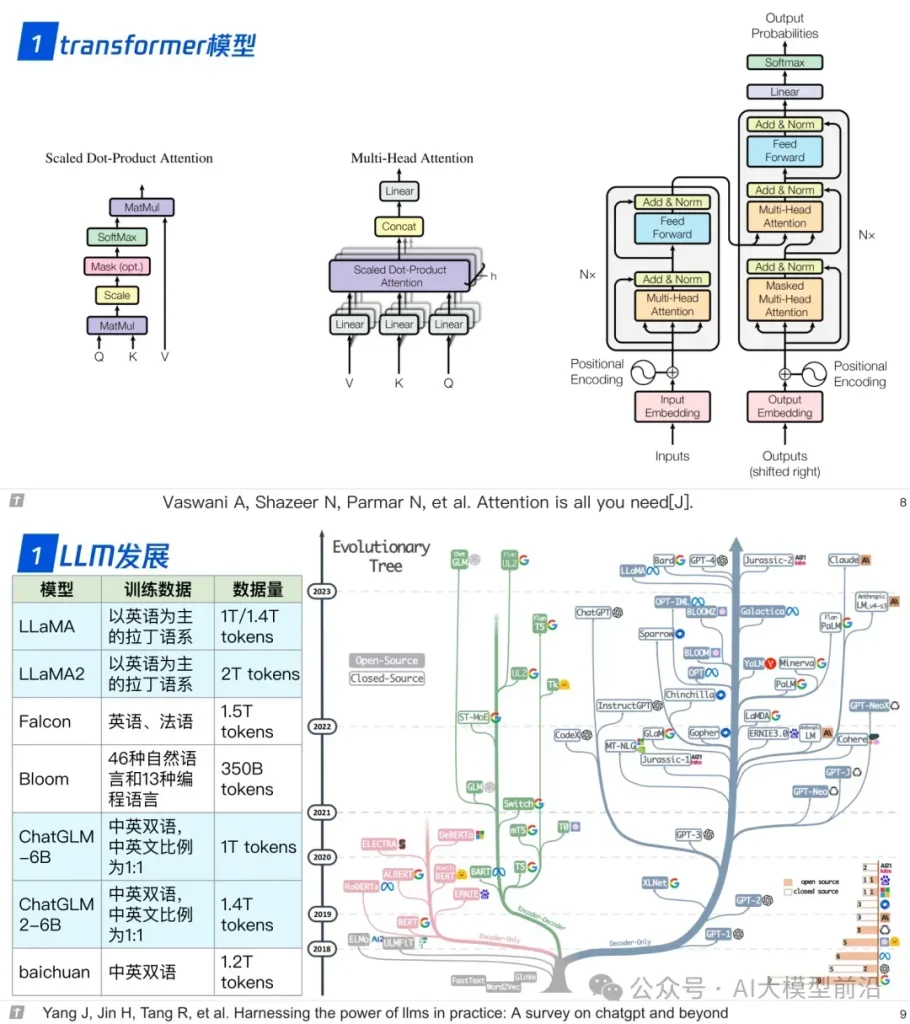

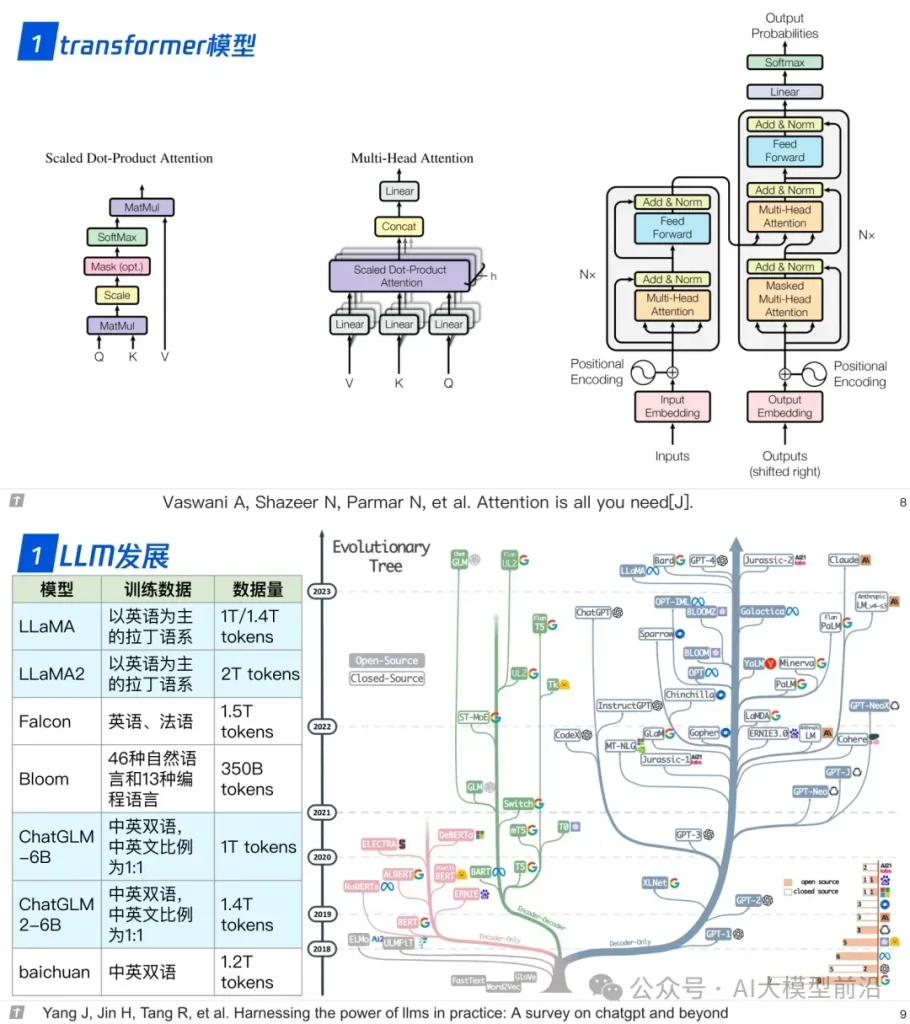

1.0 transformer 與 LLM

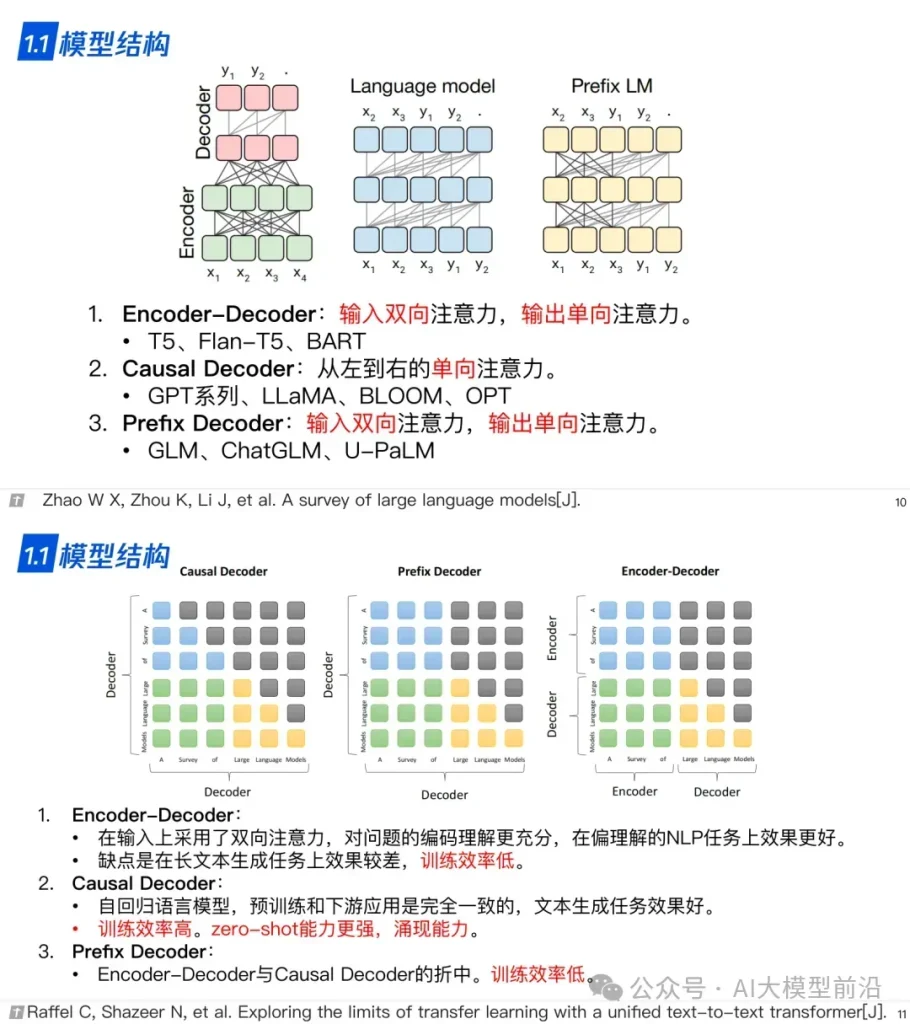

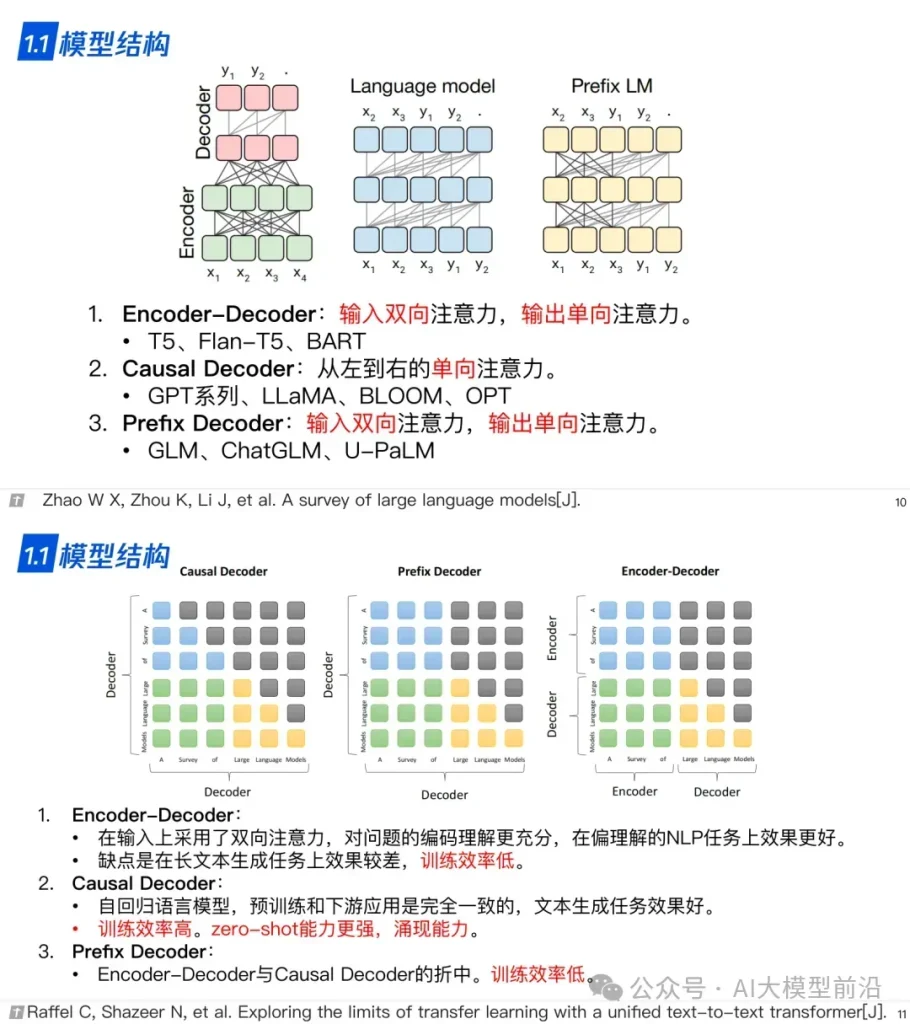

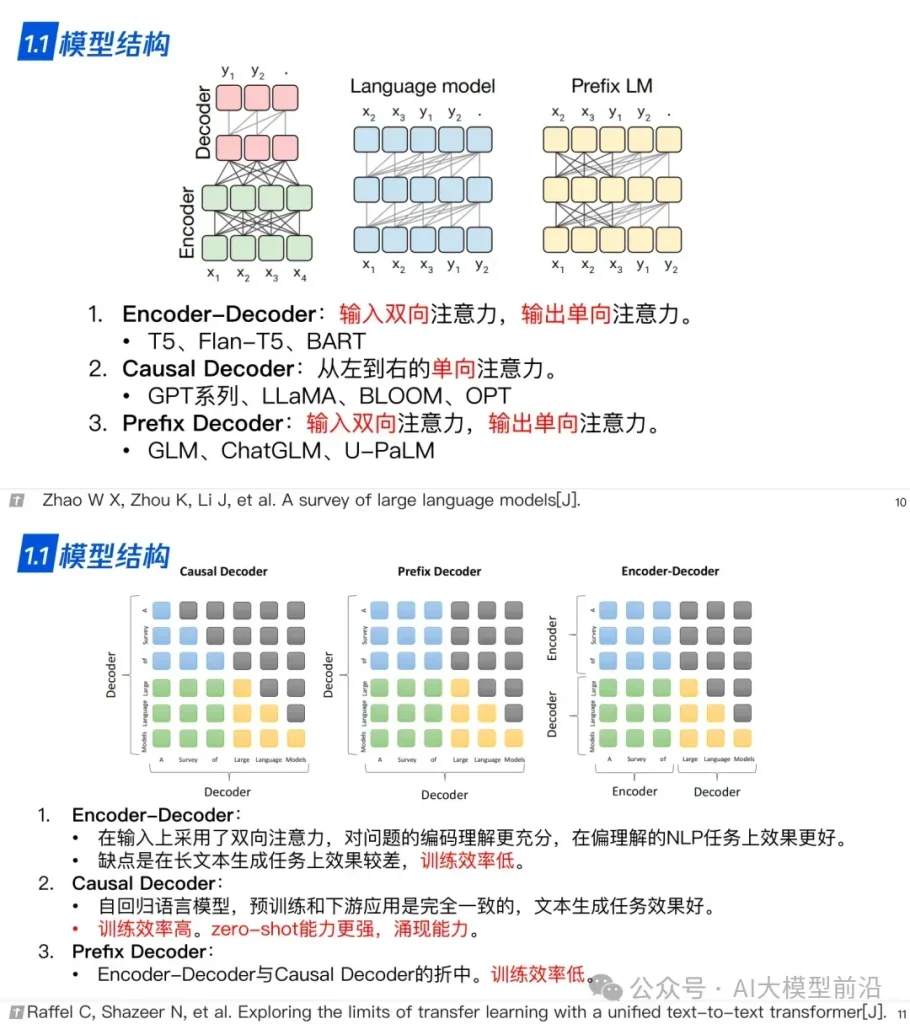

1.1 模型結構

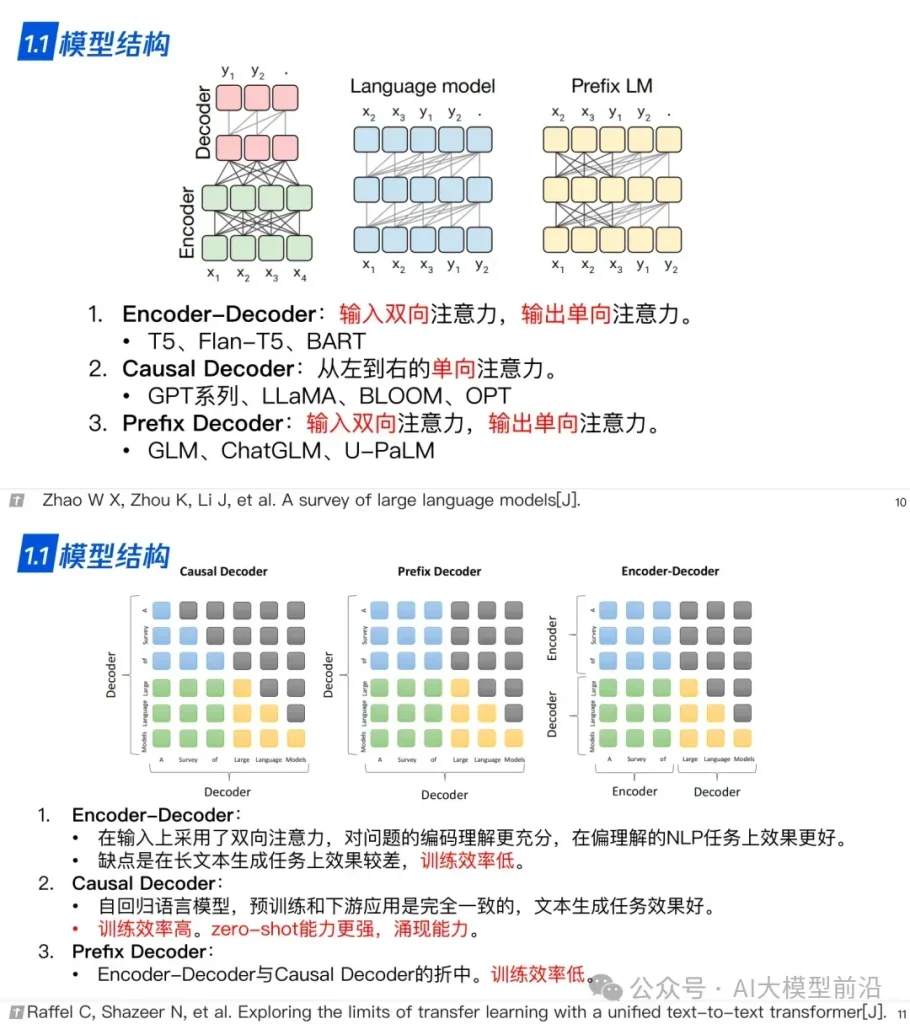

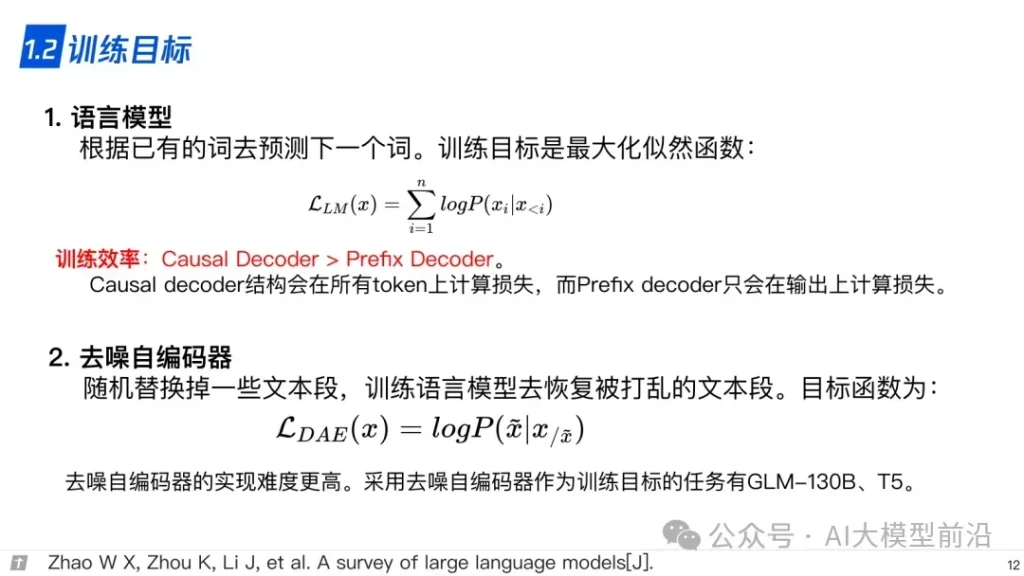

1.2 訓練目標

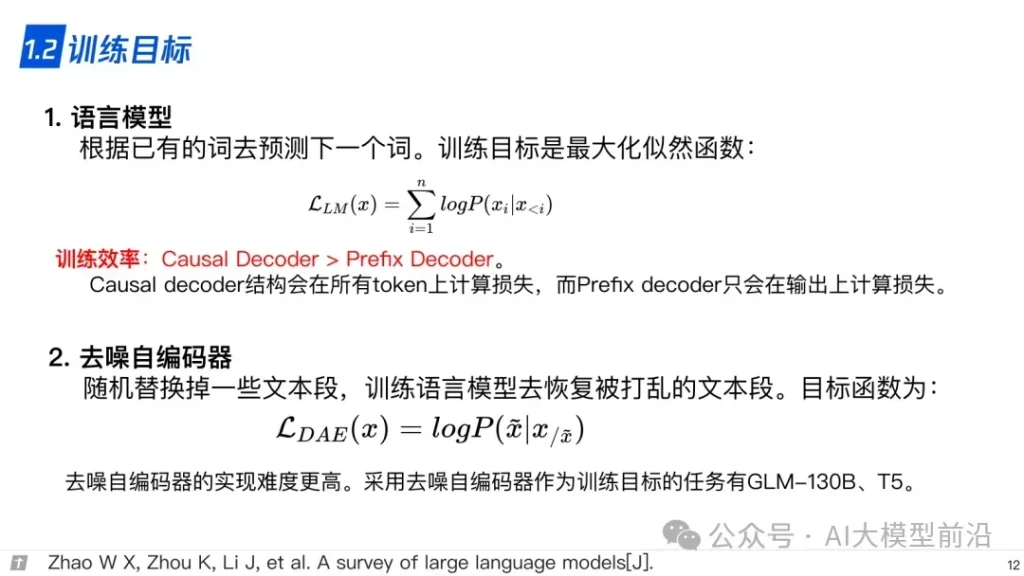

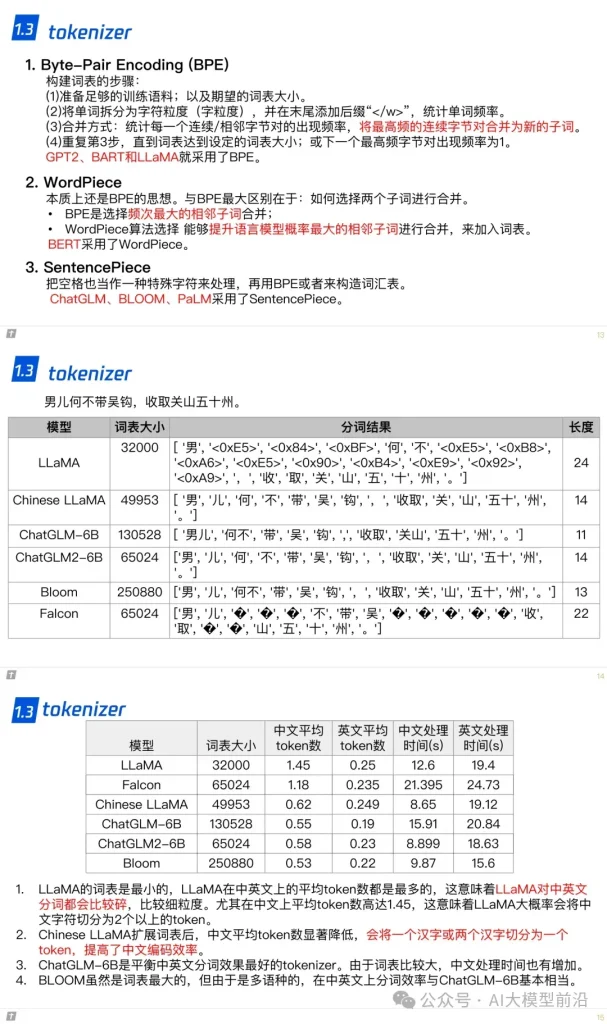

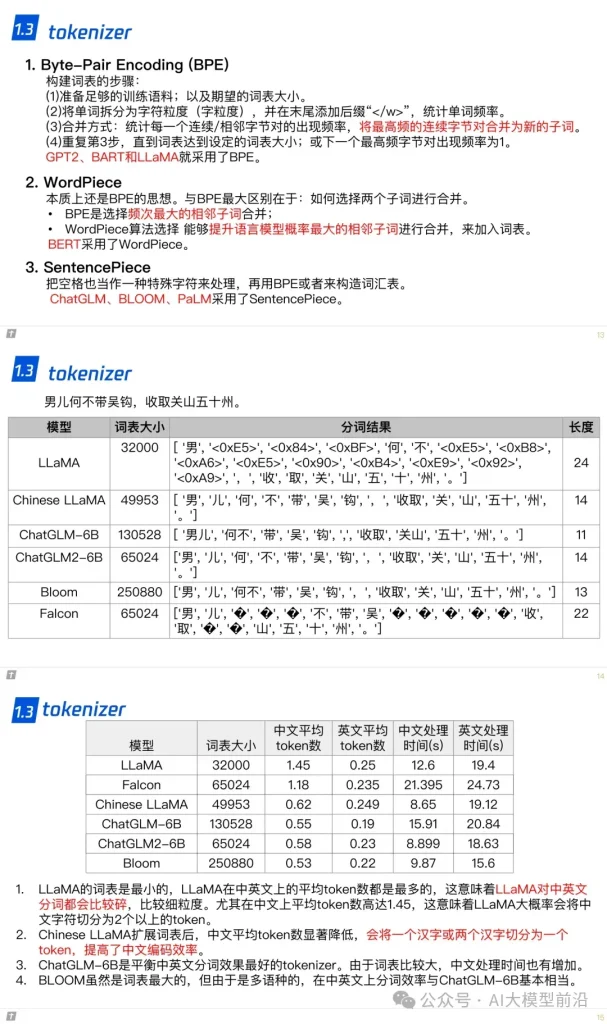

1.3 tokenizer

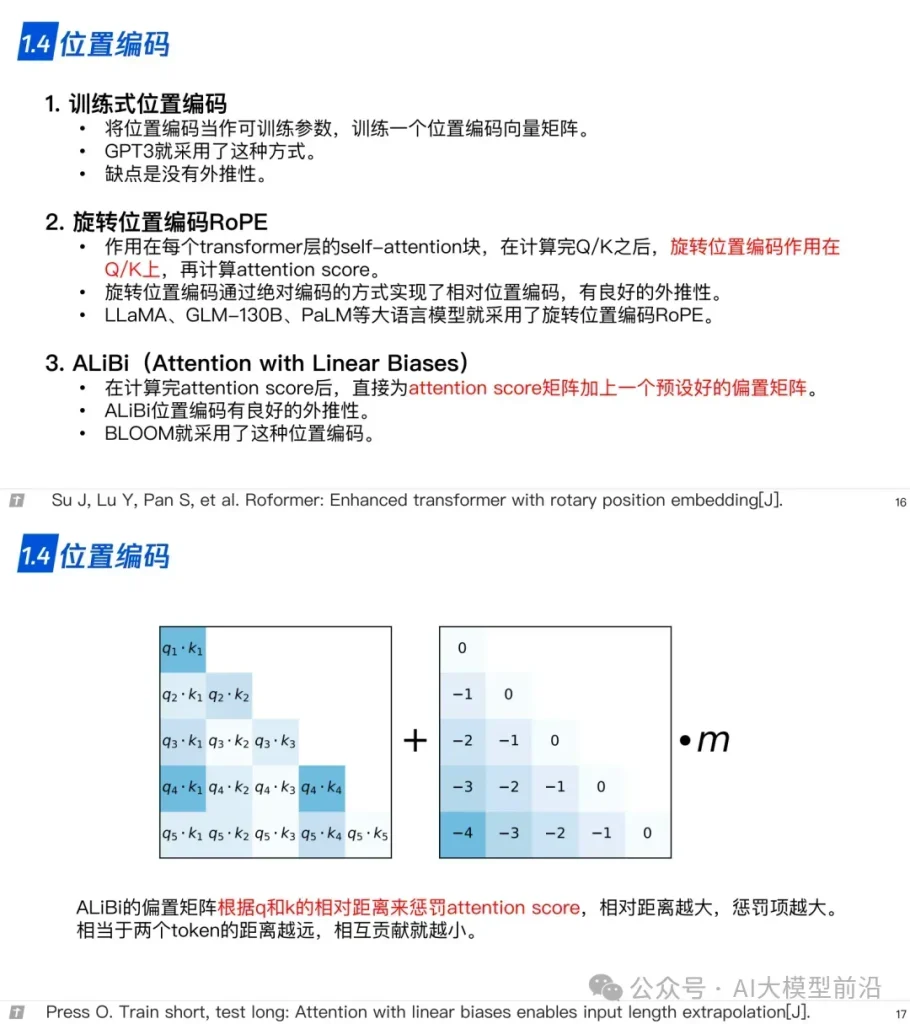

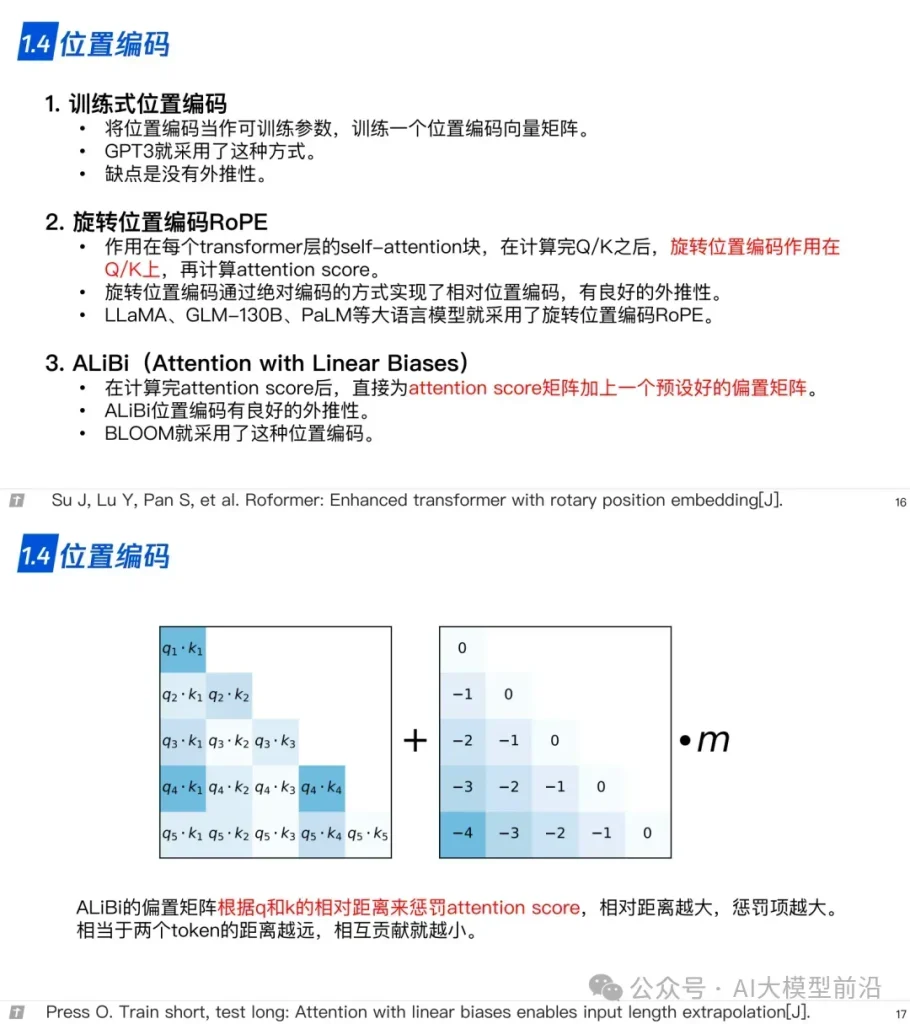

1.4 位置編碼

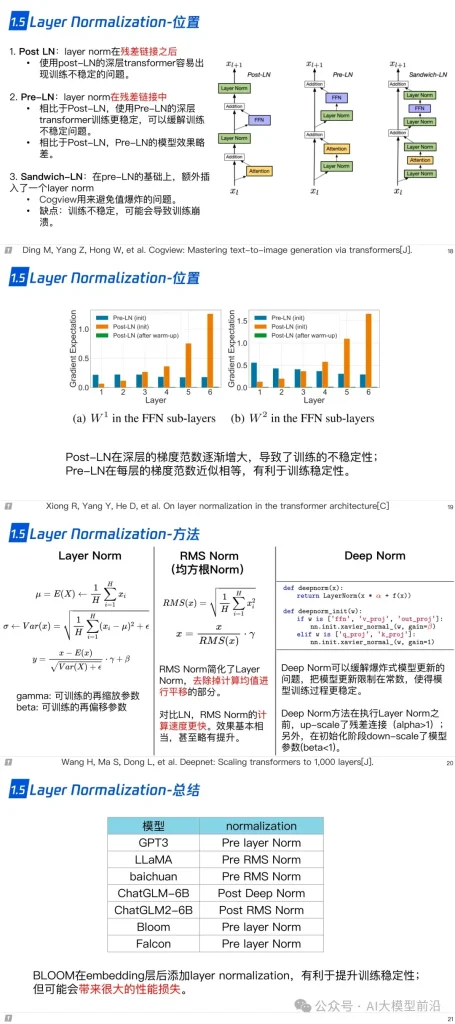

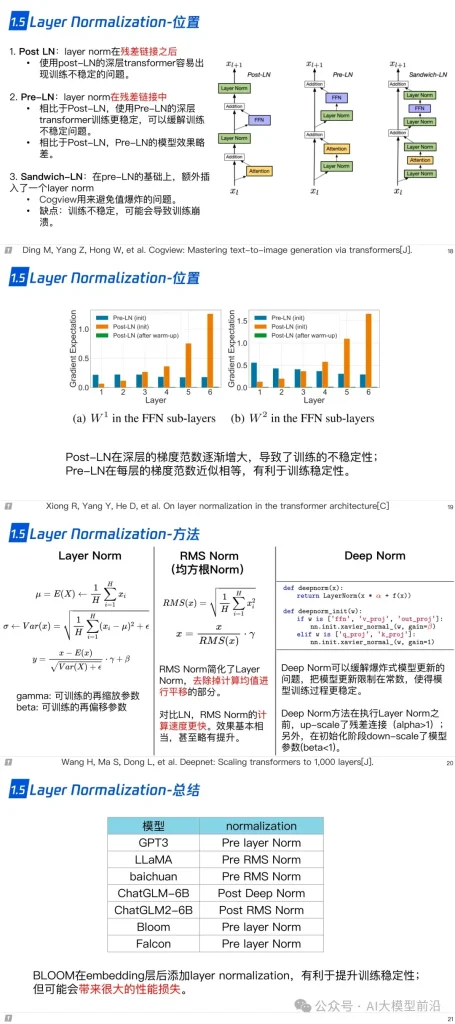

1.5 層歸一化

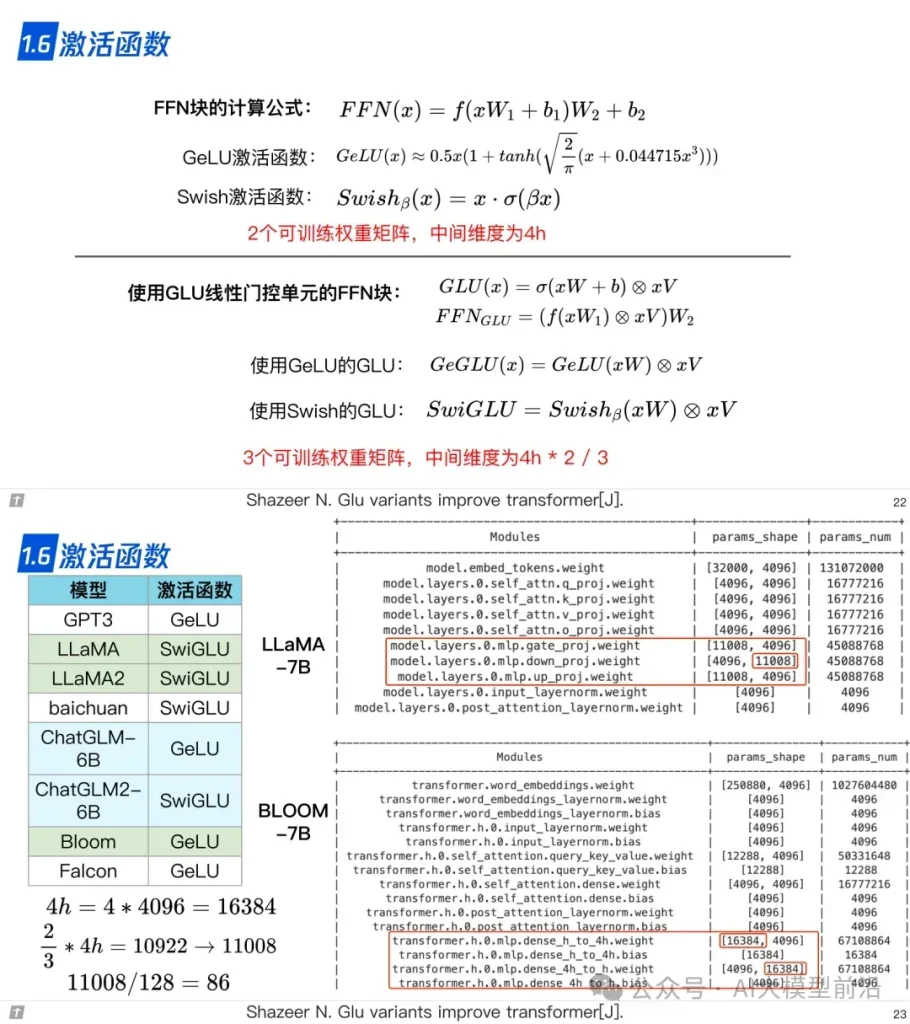

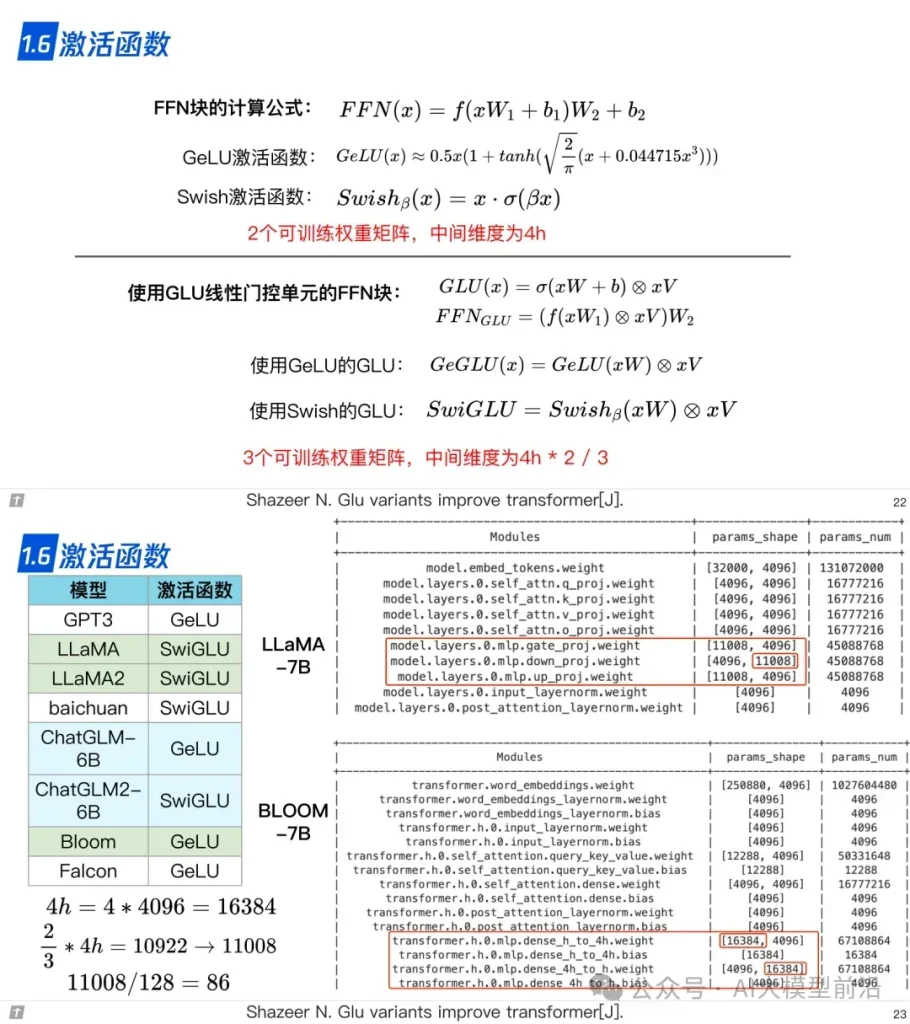

1.6 激活函數

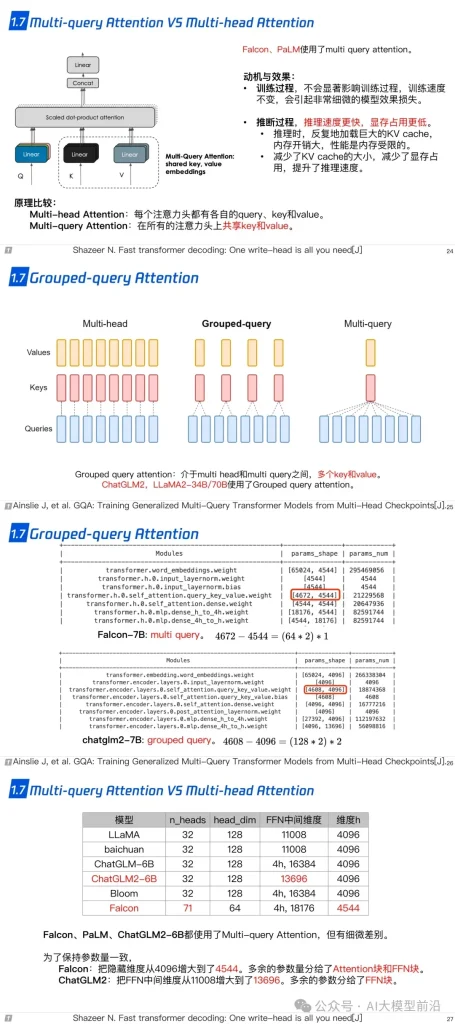

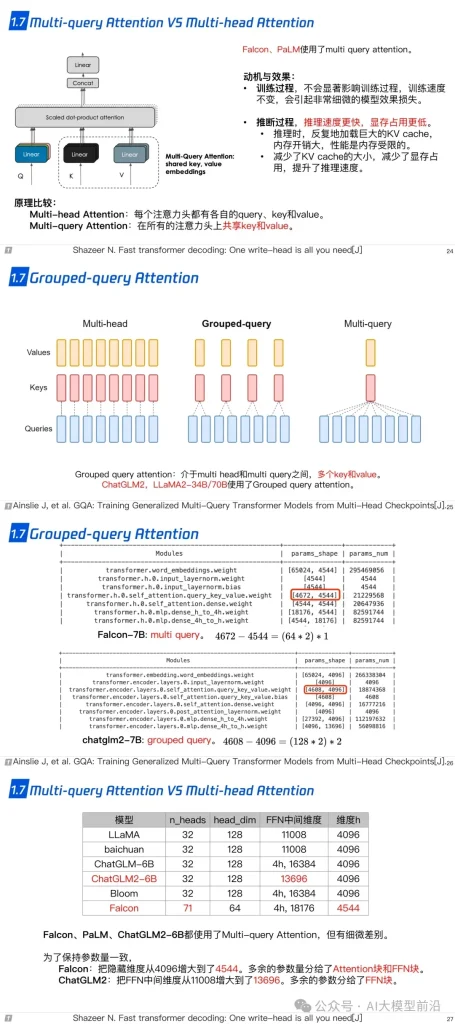

1.7 Multi-query Attention 與 Grouped-query Attention

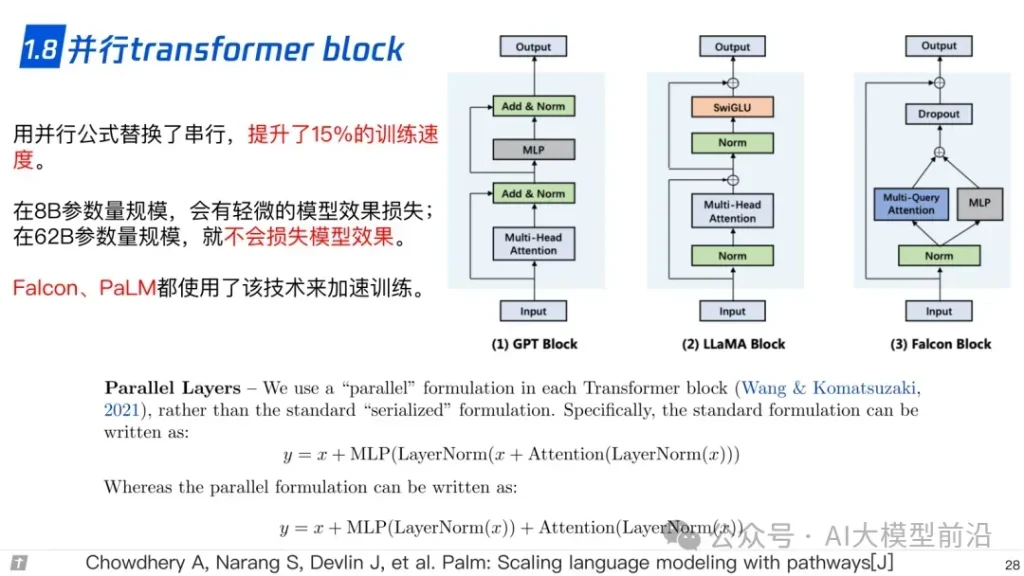

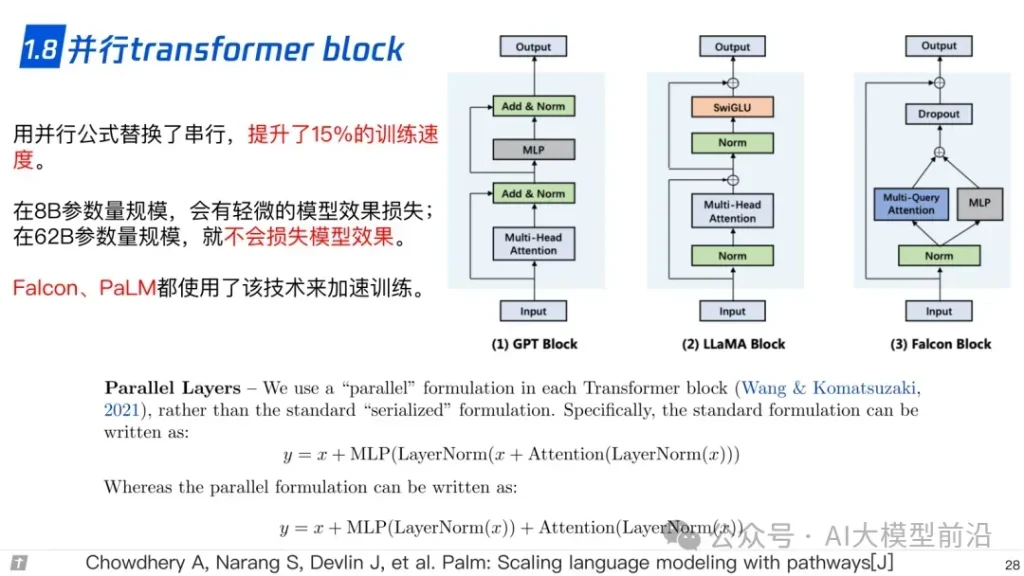

1.8 并行 transformer block

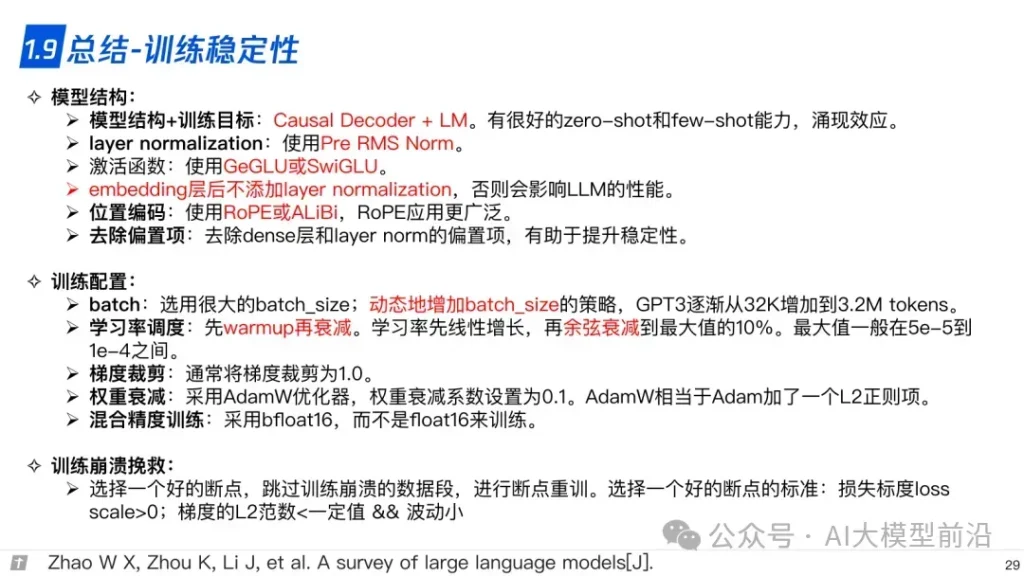

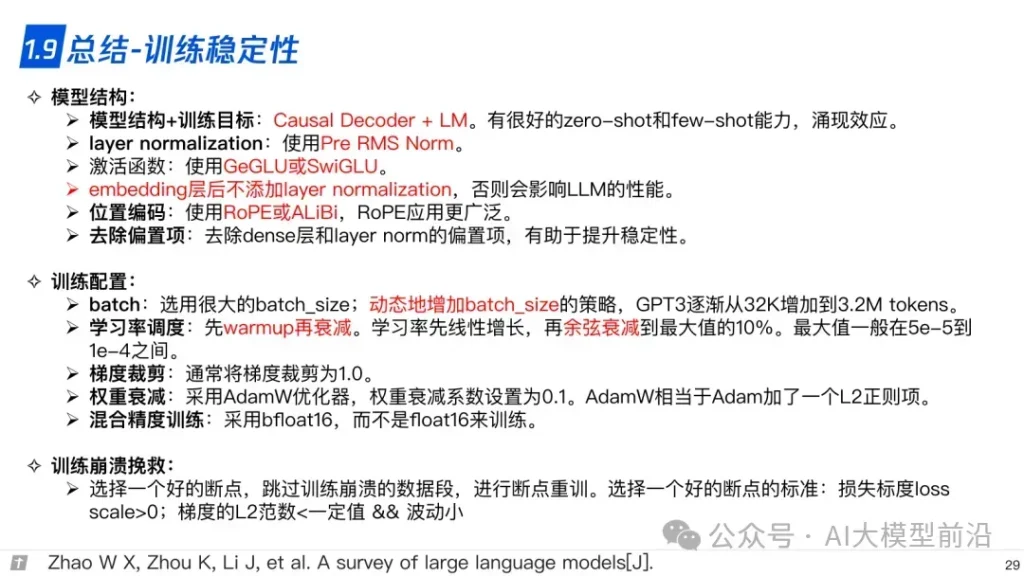

1.9 總結-訓練穩定性

導讀

理解大語言模型,可以從‘LLM的架構、LLL的訓練、LLL的微調’三個方面進行,也可以針對需求重點理解一部分。例如,訓練+微調,可以讀后兩篇,只做微調,讀最后一篇。

參考資料

原文轉自: 微信公眾號@AI大模型前沿

熱門推薦

一個賬號試用1000+ API

助力AI無縫鏈接物理世界 · 無需多次注冊

3000+提示詞助力AI大模型

和專業工程師共享工作效率翻倍的秘密

熱門推薦

一個賬號試用1000+ API

助力AI無縫鏈接物理世界 · 無需多次注冊

国内精品久久久久影院日本,日本中文字幕视频,99久久精品99999久久,又粗又大又黄又硬又爽毛片

日韩国产精品久久久|

精品乱人伦小说|

国产网站一区二区|

56国语精品自产拍在线观看|

99re视频精品|

av亚洲精华国产精华|

国产传媒日韩欧美成人|

日韩三级高清在线|

久久久久久久久久久久久夜|

日韩在线一区二区三区|

国产一区二区在线观看免费|

日本电影欧美片|

欧美刺激午夜性久久久久久久|

日韩一卡二卡三卡|

精品国产一区二区三区四区四

|

日本欧美肥老太交大片|

国产成a人无v码亚洲福利|

在线区一区二视频|

69堂亚洲精品首页|

国产精品情趣视频|

日韩av不卡一区二区|

亚洲狠狠丁香婷婷综合久久久|

麻豆国产精品视频|

欧美电影免费观看高清完整版在|

五月激情综合色|

91麻豆精品国产91久久久久久久久

|

日本黄色一区二区|

欧美视频精品在线|

国产免费观看久久|

免费精品99久久国产综合精品|

亚洲123区在线观看|

91玉足脚交白嫩脚丫在线播放|

欧美精品一区二区在线播放|

亚洲国产人成综合网站|

黑人精品欧美一区二区蜜桃|

国产精品国产自产拍高清av王其|

欧美日本精品一区二区三区|

久久不见久久见免费视频1|

久久综合国产精品|

国产宾馆实践打屁股91|

欧美日韩一区高清|

福利视频网站一区二区三区|

欧美日韩免费视频|

不卡视频在线看|

国产视频一区二区在线|

黄色日韩三级电影|

亚洲一卡二卡三卡四卡五卡|

色噜噜久久综合|

精品一区二区三区视频在线观看|

成人av中文字幕|

蜜桃久久精品一区二区|

肉肉av福利一精品导航|

亚洲精品乱码久久久久久久久

|

不卡一区二区在线|

风间由美一区二区三区在线观看

|

欧美日韩精品一区二区三区四区|

肉色丝袜一区二区|

国产欧美视频一区二区|

国产成人综合自拍|

懂色av一区二区夜夜嗨|

欧美日本在线一区|

337p粉嫩大胆色噜噜噜噜亚洲|

国产日韩欧美亚洲|

天天亚洲美女在线视频|

日韩成人免费看|

亚洲欧美国产毛片在线|

亚洲精品高清视频在线观看|

亚洲精品视频免费看|

国产精品久久久久影院色老大|

在线精品国精品国产尤物884a|

国产欧美日韩在线|

奇米777欧美一区二区|

91色综合久久久久婷婷|

色先锋aa成人|

欧美二区在线观看|

精品少妇一区二区三区日产乱码

|

粉嫩av亚洲一区二区图片|

日本韩国欧美三级|

欧美日韩一区二区三区高清|

欧美精品v国产精品v日韩精品|

中文字幕不卡的av|

综合亚洲深深色噜噜狠狠网站|

亚洲欧美一区二区视频|

全部av―极品视觉盛宴亚洲|

日韩中文字幕不卡|

精品对白一区国产伦|

日韩欧美第一区|

欧美一三区三区四区免费在线看|

国产三级欧美三级|

亚洲女同女同女同女同女同69|

2014亚洲片线观看视频免费|

99久久er热在这里只有精品66|

中国色在线观看另类|

亚洲国产成人porn|

亚洲成人av一区|

国产精品青草综合久久久久99|

亚洲国产日韩在线一区模特|

午夜不卡在线视频|

色菇凉天天综合网|

国产日韩一级二级三级|

久久99精品国产.久久久久久|

国产一区二区美女诱惑|

久久久精品人体av艺术|

正在播放亚洲一区|

色天天综合色天天久久|

韩国精品免费视频|

亚洲在线中文字幕|

中日韩av电影|

欧美剧情电影在线观看完整版免费励志电影

|

日韩精品一级二级|

在线视频国产一区|

亚洲国产一区二区视频|

欧美日韩一区在线|

天涯成人国产亚洲精品一区av|

欧美极品少妇xxxxⅹ高跟鞋|

中文字幕在线一区|

久久精品视频一区二区三区|

欧美日韩免费电影|

国产91精品在线观看|

亚洲1区2区3区视频|

欧美性xxxxxxxx|

亚洲一区二区视频在线|

亚洲一区二区欧美日韩|

天天操天天综合网|

自拍偷拍欧美精品|

久久精品人人做|

**欧美大码日韩|

欧美精品在线观看一区二区|

91蜜桃视频在线|

国产精品综合久久|

成人av影视在线观看|

91在线视频免费观看|

欧美撒尿777hd撒尿|

9191精品国产综合久久久久久|

欧美性大战xxxxx久久久|

久久精品国产免费|

欧美特级限制片免费在线观看|

国产美女在线精品|

老司机精品视频在线|

亚洲欧洲av色图|

久久精品日产第一区二区三区高清版|

精品国产91乱码一区二区三区

|

色综合色综合色综合色综合色综合|

美脚の诱脚舐め脚责91|

色妹子一区二区|

亚洲精品乱码久久久久久久久|

美脚の诱脚舐め脚责91

|

日韩av高清在线观看|

精品日韩av一区二区|

日韩av电影免费观看高清完整版在线观看|

国产成人午夜精品影院观看视频|

一本到三区不卡视频|

国产亚洲欧美在线|

亚洲va国产va欧美va观看|

国产精品一线二线三线精华|

色婷婷av一区二区|

麻豆国产欧美日韩综合精品二区|

成人黄页在线观看|

一区二区三区在线免费观看|

92精品国产成人观看免费|

91精品婷婷国产综合久久性色

|

91福利社在线观看|

亚洲成人1区2区|

91精品办公室少妇高潮对白|

欧美电视剧在线观看完整版|

视频一区二区国产|

欧美r级在线观看|

国产精品 欧美精品|

亚洲一二三四区不卡|

www久久精品|

91精品在线一区二区|

麻豆精品在线播放|

午夜成人在线视频|

91精品视频网|

久久久久久久综合狠狠综合|

成人一区二区三区视频|

日韩成人精品视频|

亚洲成av人片观看|

一区二区三区精密机械公司|

国产欧美一区二区在线|

欧美探花视频资源|

国产美女在线精品|

国产一区二区三区电影在线观看

|

亚洲在线免费播放|

国产精品日韩成人|

欧美不卡一区二区|

久久午夜羞羞影院免费观看|

欧美日本韩国一区|

精品处破学生在线二十三|

欧美日韩精品一区二区|

91麻豆国产在线观看|

91理论电影在线观看|

欧美视频中文字幕|

成人aaaa免费全部观看|

亚洲美女区一区|

天天影视涩香欲综合网|

精品一区二区三区的国产在线播放|

色久优优欧美色久优优|

国产精品每日更新在线播放网址|

国产在线国偷精品产拍免费yy|