2024年您產品必備的10大AI API推薦

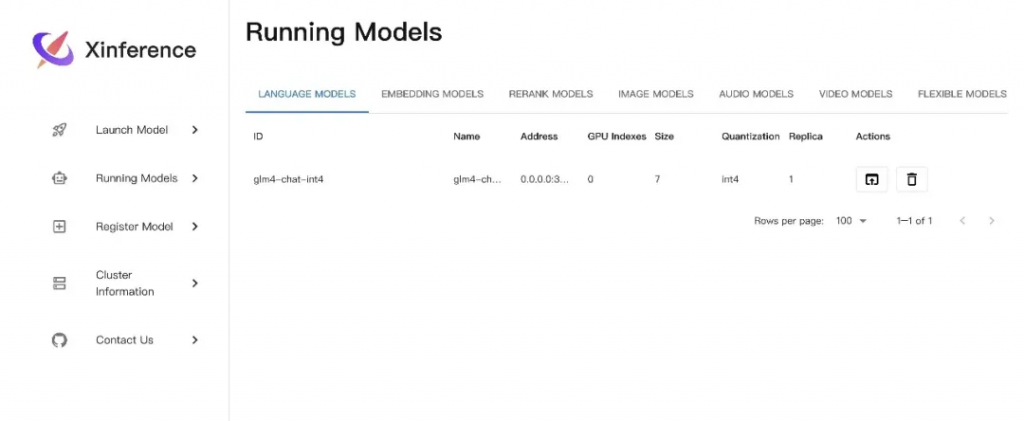

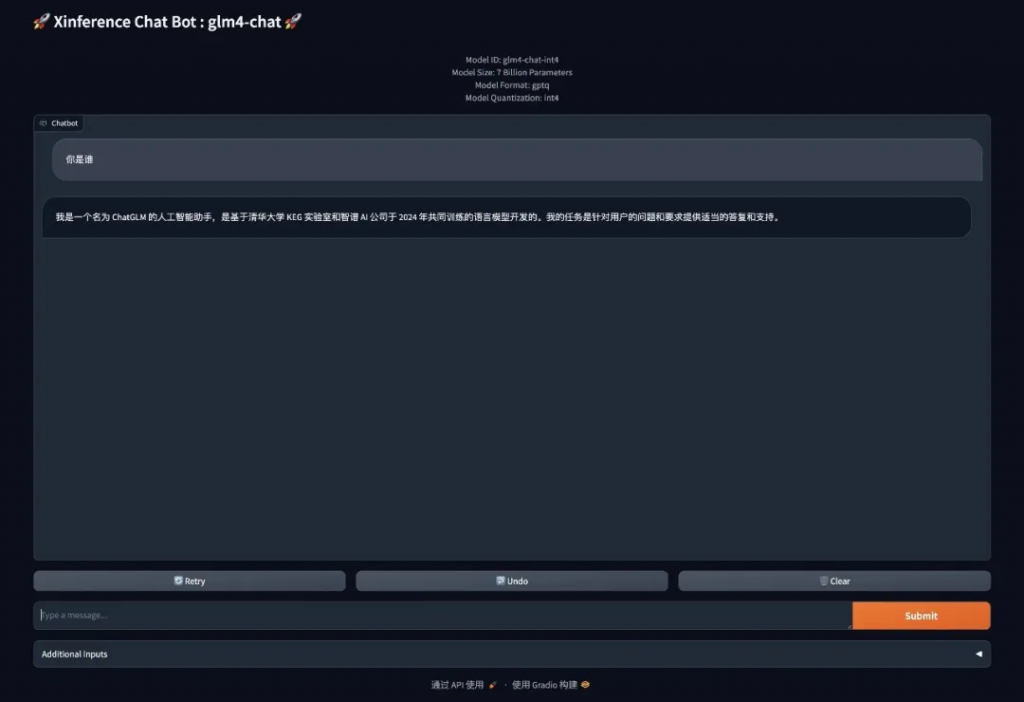

傳統的本地私有化部署,需要將大語言模型LLM(GLM-4-9B)高效地加載到系統中。比如,我們可以選擇Xinference這類推理框架,它提供了靈活、高效的模型加載與推理能力。

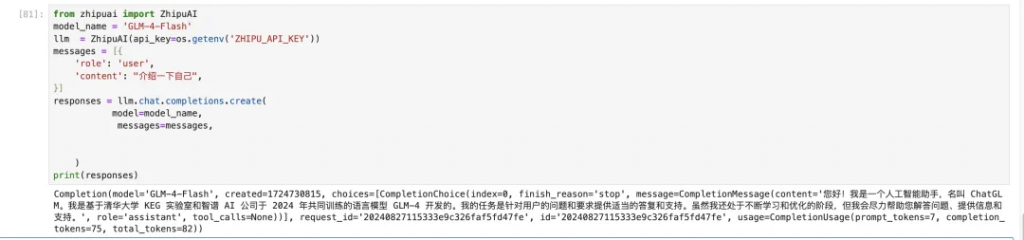

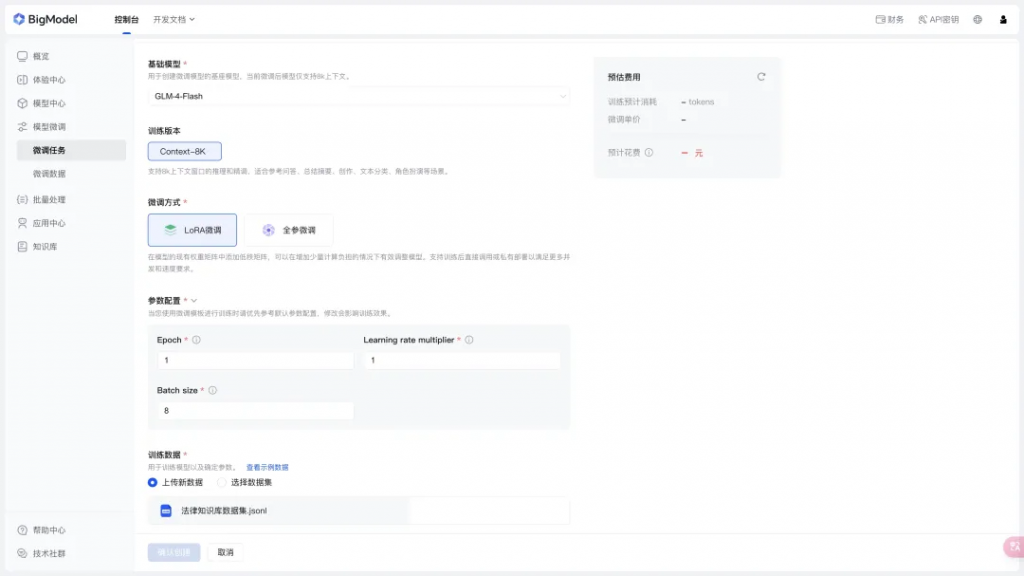

與本地私有化部署大語言模型(GLM-4-9B)不同,GLM-4-Flash支持通過API接口進行在線微調。這種方式不僅簡化了模型部署的復雜度,還使得模型能夠實時適應法律領域的新知識和變化。

首先,需要注冊并獲取GLM-4-Flash的API訪問權限,確保能夠安全、穩定地接入模型服務。

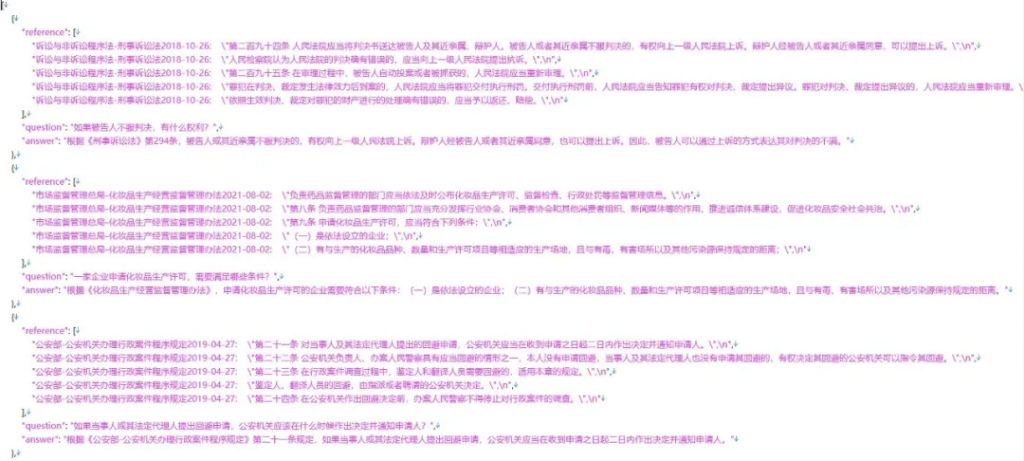

收集并整理法律領域的特定數據集,包括最新的法律條文、案例判決、法律問題等,用于模型的在線微調。

通過GLM-4-Flash提供的在線微調界面,選擇LoRA微調,設置,將準備好的數據集上傳至服務器,并啟動微調過程。在微調過程中,模型將學習法律領域的特定知識和模式,從而提升其在該領域的表現。

在法律知識庫的實際應用中,Function Calling技術能夠實現模型與用戶之間的智能交互。通過定義特定的Function Calling接口,模型可以根據用戶的問題自動檢索相關法律案件,并給出針對性的回答。

在GLM-4-Flash模型中定義Function Calling接口,用于接收用戶輸入的法律問題,并觸發案件檢索功能。

@app.route('/query_legal_case', methods=['POST'])

def query_legal_case():

# 接收用戶輸入的法律問題

user_question = request.json.get('question')

# 調用GLM-4-Flash模型或其他服務進行案件檢索(這里簡化為直接調用函數)

retrieved_cases = search_legal_cases(user_question)

# 使用GLM-4-Flash或其他NLP技術生成回答

answer = generate_answer(retrieved_cases, user_question)

# 返回回答

return jsonify({'answer': answer})

# 這里需要實現search_legal_cases和generate_answer函數

# ...

if __name__ == '__main__':

app.run(debug=True)將法律案件數據庫與GLM-4-Flash模型系統集成,確保模型能夠實時訪問并檢索相關案例。

def search_legal_cases(question):

# 連接數據庫

db_connection = get_database_connection()

# 基于問題內容構建查詢(這里簡化為示例)

query = build_query_from_question(question)

# 執行查詢并獲取結果

cases = db_connection.execute_query(query)

# 返回檢索到的案例列表

return cases

# 這里需要實現get_database_connection和build_query_from_question函數

# ...在檢索到相關法律案件后,GLM-4-Flash模型將結合案件內容和用戶問題進行分析,生成準確、全面的回答。這些回答可以直接呈現給用戶,幫助他們更好地理解法律問題和做出決策。

def generate_answer(cases, question):

# 對每個案例進行分析,提取關鍵信息

relevant_info = []

for case in cases:

info = extract_relevant_info(case, question)

relevant_info.append(info)

# 使用GLM-4-Flash對提取的信息和用戶問題進行分析

# 這里簡化為直接使用某個函數來生成回答

answer = synthesize_answer(relevant_info, question)

return answer

# 這里需要實現extract_relevant_info和synthesize_answer函數

# 注意:synthesize_answer可能需要與GLM-4-Flash進行交互

# ...在利用GLM-4-Flash進行在線微調和Function Calling時,安全性和隱私保護是不可忽視的重要環節。

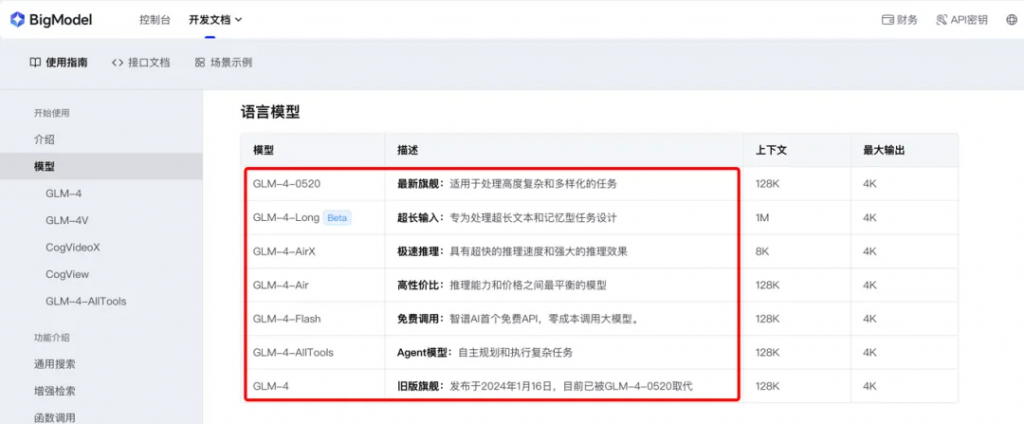

智譜BigModel大模型開發平臺免費?持2個并發,更多的是?持個?使?,如果需要使?API提供服務歡迎使?其他模型(GLM-4系列)。

點擊閱讀原文,趕快行動起來,結合GLM-4-Flash模型搭建屬于自己的行業知識庫。

文章轉自微信公眾號@架構師帶你玩轉AI