事件流處理服務(wù)-Keen

專用API

【更新時間: 2024.09.18】

事件流處理服務(wù)是一個強大的平臺,允許用戶從互聯(lián)網(wǎng)上的任何連接設(shè)備輕松收集事件數(shù)據(jù)。無論是您的網(wǎng)站、應(yīng)用程序、后端服務(wù)器、智能設(shè)備還是第三方系統(tǒng)等,都可以通過使用Keen的強大REST API和多種SDK來收集這些數(shù)據(jù)。

|

瀏覽次數(shù)

453

采購人數(shù)

0

試用次數(shù)

0

SLA: N/A

SLA: N/A

響應(yīng): N/A

響應(yīng): N/A

適用于個人&企業(yè)

適用于個人&企業(yè)

收藏

×

完成

取消

×

書簽名稱

確定

|

- API詳情

- 定價

- 使用指南

- 常見 FAQ

- 關(guān)于我們

什么是Keen的事件流處理服務(wù)?

事件流處理服務(wù)-Keen基于 Apache Kafka ® 構(gòu)建,輕松從任何地方收集事件數(shù)據(jù),添加豐富的屬性,并發(fā)送到您需要的任何地方。是一個專注于事件數(shù)據(jù)收集、豐富和轉(zhuǎn)換的服務(wù)平臺。它為用戶提供了一種方法來從各種來源收集事件數(shù)據(jù),并通過多種方式豐富這些數(shù)據(jù),如添加地理位置信息、設(shè)備類型等額外維度。同時,它也支持將數(shù)據(jù)發(fā)送到所需的任何地方,從而幫助用戶更好地理解和利用他們的數(shù)據(jù)資產(chǎn)。 |

|

什么是Keen的事件流處理服務(wù)接口?

Keen的事件流處理服務(wù)有哪些核心功能?

|

從任何來源串流 使用從 JavaScript 到 Go 的超過 15 個 SDK,從堆棧中的任何位置進行 POST。 |

|

|

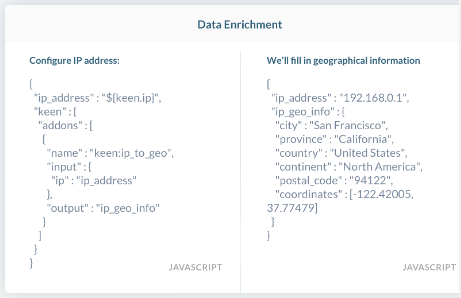

豐富與轉(zhuǎn)變 使用豐富功能添加維度,例如位置、工作日、訪問設(shè)備等。 |

|

將數(shù)據(jù)發(fā)送到任何需要的地方 使用 Keen 安全存儲數(shù)據(jù),以便使用 Keen Compute 進行即時查詢和構(gòu)建實時數(shù)據(jù)產(chǎn)品。 |

|

Keen的事件流處理服務(wù)的核心優(yōu)勢是什么?

1.快速部署與數(shù)據(jù)收集:使用我們?nèi)娴墓ぞ吆?SDK 集快速啟動并運行。您可以立即快速收集數(shù)據(jù)。

2. 全天候支持與專業(yè)團隊:讓Keen的人代替你的人負責尋呼機。我們的全球開發(fā)人員和支持人員團隊確保平臺 365、24/7 持續(xù)運行。

3. 完全定制化解決方案:通過完全可定制的堆棧準確構(gòu)建您所需要的內(nèi)容。您可以完全控制收集哪些數(shù)據(jù)以及如何描述數(shù)據(jù)。

4. 減少運維風(fēng)險與復(fù)雜性:降低您的運營和交付風(fēng)險。避免維護容錯數(shù)據(jù)管道帶來的不可避免的麻煩。

在哪些場景會用到Keen的事件流處理服務(wù)?

| 產(chǎn)品分析:企業(yè)可以使用該服務(wù)來跟蹤產(chǎn)品的使用情況和用戶的互動情況,從而獲得產(chǎn)品性能的真實視圖,并據(jù)此做出改進決策。 |

|

| 面向客戶的度量指標:通過集成“事件流處理服務(wù)-Keen”,公司可以快速開發(fā)出產(chǎn)品內(nèi)的分析工具,減少開發(fā)時間,同時提供給客戶實時的度量信息。 |

|

| 業(yè)務(wù)運營:銷售、市場和財務(wù)團隊可以通過此服務(wù)來整合其使用的各種工具,從而更有效地管理業(yè)務(wù)操作并做出決策。例如,營銷團隊可以根據(jù)用戶的活動數(shù)據(jù)來優(yōu)化營銷策略,而財務(wù)團隊則可以根據(jù)實際使用情況調(diào)整計費模型。 |

|