使用百度千帆API需要首先在平臺上注冊并申請API Key。以下是一個簡單的Python代碼示例,用于調(diào)用ERNIE-Speed-8K模型:

import requests

import json

API_KEY = "你的API Key"

SECRET_KEY = "你的Secret Key"

def main():

url = "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/ernie_speed?access_token=" + get_access_token()

payload = json.dumps({

"messages": [

{

"role": "user",

"content": "你好"

},

]

})

headers = {

'Content-Type': 'application/json'

}

response = requests.request("POST", url, headers=headers, data=payload)

print(response.text)

def get_access_token():

url = "https://aip.baidubce.com/oauth/2.0/token"

params = {"grant_type": "client_credentials", "client_id": API_KEY, "client_secret": SECRET_KEY}

return str(requests.post(url, params=params).json().get("access_token"))

if __name__ == '__main__':

main()騰訊混元平臺同樣提供了免費的AI大語言模型接口,涵蓋了多種應用場景。主要的模型包括hunyuan-lite、hunyuan-pro等。

騰訊混元大模型API的優(yōu)勢在于其并發(fā)能力和多樣化的模型選擇。hunyuan-lite模型允許開發(fā)者進行多路并發(fā)操作,適合復雜的實時交互應用場景。此外,騰訊還提供了詳盡的文檔和示例代碼,便于開發(fā)者快速實現(xiàn)功能。

要使用騰訊混元API,首先需要在平臺上創(chuàng)建密鑰。以下是使用hunyuan-lite模型的簡單示例:

import requests

url = "https://api.tencent.com/v1/chat/completions"

headers = {

"Authorization": "Bearer {YOUR TOKEN}",

"Content-Type": "application/json"

}

data = {

"model": "hunyuan-lite",

"messages": [{"role": "user", "content": "你好"}]

}

response = requests.post(url, headers=headers, json=data)

print(response.json())訊飛星火提供了一系列免費的API接口,適用于多樣化的應用場景,特別是在語音和文本處理的領域。

訊飛星火的API接口不僅支持文本對話,還可以進行語音識別和合成。Spark Lite模型提供了無限量的Tokens支持,QPS為2,適合高頻次的請求場景。

使用訊飛星火API,開發(fā)者需要在訊飛的官方網(wǎng)站上注冊并獲取相應的API密鑰。以下是一個簡單的調(diào)用示例:

import requests

url = "https://spark-api.xf-yun.com/v1.1/chat"

headers = {

"Authorization": "Bearer {YOUR API_KEY}",

"Content-Type": "application/json"

}

data = {

"messages": [{"role": "user", "content": "你好"}]

}

response = requests.post(url, headers=headers, json=data)

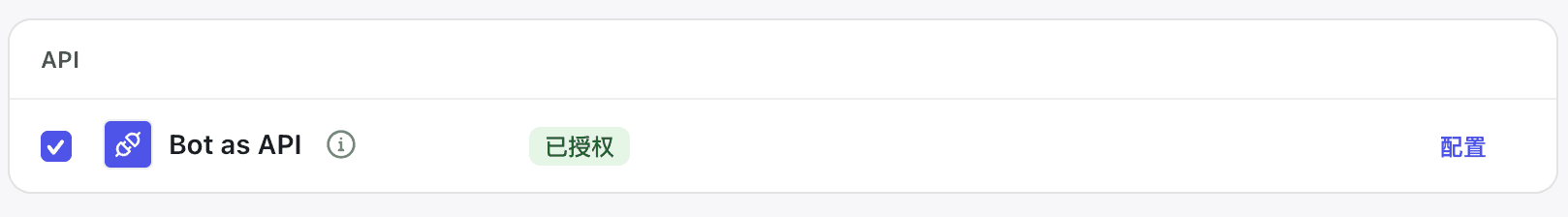

print(response.json())字節(jié)扣子平臺提供的AI大語言模型API涵蓋了從文本處理到角色扮演的多種功能,支持高效的API調(diào)用。

字節(jié)扣子的API接口特別適合于實時對話和復雜文本分析任務。它支持多種模型,如豆包·Function call模型,以及高并發(fā)的調(diào)用能力。

要使用字節(jié)扣子API,開發(fā)者需在平臺上創(chuàng)建個人訪問令牌,并發(fā)布Bot為API服務。以下是簡單的Python調(diào)用示例:

import requests

url = "https://api.coze.cn/open_api/v2/chat"

headers = {

"Authorization": "Bearer {YOUR PERSONAL_ACCESS_TOKEN}",

"Content-Type": "application/json"

}

data = {

"conversation_id": "123",

"bot_id": "{YOUR BOT}",

"user": "29032201862555",

"query": "你好",

"stream": False

}

response = requests.post(url, headers=headers, json=data)

print(response.status_code)

print(response.json())硅基流動平臺提供了多種免費的AI大語言模型接口,支持大規(guī)模的文本和數(shù)據(jù)處理。

硅基流動的API接口支持豐富的模型選擇,如Qwen系列和THUDM系列模型,適合多種復雜的應用場景。平臺提供的調(diào)試工具和詳細的文檔,使開發(fā)者能夠快速實現(xiàn)應用。

開發(fā)者可以通過硅基流動的官網(wǎng)創(chuàng)建API密鑰,并選擇合適的模型進行調(diào)用。以下是一個簡單的示例代碼:

import requests

url = "https://api.siliconflow.cn/v1/chat/completions"

payload = {

"model": "Qwen/Qwen2-7B-Instruct",

"messages": [{"role": "user", "content": "你好"}],

"max_tokens": 4096,

"stream": False,

"temperature": 0.5

}

headers = {

"accept": "application/json",

"content-type": "application/json",

"authorization": "Bearer {你的API密鑰}"

}

response = requests.post(url, json=payload, headers=headers)

print(response.text)選擇合適的API需要根據(jù)具體的應用場景和需求來決定。例如,百度千帆適合大規(guī)模文本處理,騰訊混元則在實時交互中表現(xiàn)優(yōu)異。

大多數(shù)免費API接口在請求次數(shù)和并發(fā)數(shù)量上有一定限制,開發(fā)者需要根據(jù)自身需求合理規(guī)劃使用策略。

各個平臺通常會在其官方網(wǎng)站提供詳細的API文檔,開發(fā)者可以通過注冊賬號后訪問這些文檔。

開發(fā)者應注意保護API密鑰的安全,避免泄漏。同時,應遵循平臺的使用協(xié)議,避免不當操作。

可以通過減少不必要的API調(diào)用、使用批量請求、以及優(yōu)化數(shù)據(jù)處理邏輯等方式提高API的使用效率。

總結而言,免費AI大語言模型API的出現(xiàn)極大地推動了AI技術的普及。通過合理選擇和使用這些接口,開發(fā)者能夠在不同的應用場景中實現(xiàn)智能化轉型。